MODÈLE LOCOST : UNE ALTERNATIVE AUX « TRANSFORMERS » POUR LE TRAITEMENT DE GROS VOLUMES DE TEXTE

View

QUAND L’ART RENCONTRE L’INTELLIGENCE ARTIFICIELLE

View

PROJET TELIN : COMPRENDRE LE RIRE DES BÉBÉS POUR DÉVELOPPER DES AGENTS ROBOTIQUES SOCIALEMENT INTERACTIFS

View

DYNAMISME RENOUVELÉ À L’ISIR

ViewDécouvrir l’ISIR

Nos équipes regroupent des chercheuses et chercheurs de disciplines variées, autour d’objets, d’applications et de questions scientifiques partagés relevant des deux défis majeurs de la robotique : l’interactivité avec les personnes humaines et l’autonomie.

L’avènement des intelligences artificielles et des robots induit des transformations profondes dans nos sociétés. Les chercheuses et chercheurs de l’ISIR contribuent à les anticiper en travaillant sur l’autonomie des machines et leur capacité à interagir avec les êtres humains.

Découvrez toutes les offres d’emploi, de stage, de doctorat et de post-doctorat de l’Institut des Systèmes Intelligents et de Robotique.

En ce moment

Actualités |

MODÈLE LOCOST : UNE ALTERNATIVE AUX « TRANSFORMERS » POUR LE TRAITEMENT DE GROS VOLUMES DE TEXTE

LOCOST : LOng COntext abstractive summarization with STate-space models Alors que la quantité de données textuelles générées chaque jour continue d’augmenter de manière exponentielle, les besoins en outils capables de synthétiser, analyser et comprendre de vastes quantités de texte sont devenus essentiels dans de nombreux domaines. L’état de l’art, représenté…

Actualités |

QUAND L’ART RENCONTRE L’INTELLIGENCE ARTIFICIELLE

Source de l’article : Sorbonne Université Dans un monde où la technologie façonne notre quotidien à un rythme effréné, une question persiste: l’intelligence artificielle peut-elle être douée de créativité ? Matthieu Cord, professeur en informatique spécialisé en intelligence artificielle (IA), et Hugo Caselles-Dupré, cofondateur du collectif Obvious et pionnier de l’utilisation…

Actualités |

PROJET TELIN : COMPRENDRE LE RIRE DES BÉBÉS POUR DÉVELOPPER DES AGENTS ROBOTIQUES SOCIALEMENT INTERACTIFS

Projet TELIN – The Laughing Infant Le rire, l’une des premières formes de communication chez les nourrissons, se manifeste dès l’âge de trois mois, bien avant le langage, les gestes ou la marche. Des études récentes ont mis en lumière le lien étroit entre l’acquisition du rire et des compétences…

Actualités |

ÉTUDIANTES EN TERRAIN MINÉ : FILM ET DÉBAT

L’équipe parité-égalité de l’ISIR vous propose la projection du documentaire « Étudiantes en terrain miné » de Charlotte Espel qui aborde les Violences Sexistes et Sexuelles au sein du monde de l’enseignement supérieur et de la recherche avec plusieurs témoignages d’étudiantes et doctorantes. La projection sera suivie d’un débat avec la…

Actualités |

2 POSTES D’ENSEIGNANTS CHERCHEURS OU ENSEIGNANTES CHERCHEUSES OUVERTS EN INFORMATIQUE ET EN MÉCATRONIQUE : CANDIDATEZ AVANT LE 29 MARS !

La campagne de recrutement 2024 des enseignantes-chercheuses et enseignants-chercheurs de Sorbonne Université est ouverte depuis le 22 février 2024 à 10h00 jusqu’au 29 mars 2024 à 16h00. Les inscriptions s’effectuent exclusivement sur le portail ministériel Galaxie. Parmi les postes ouverts par la Faculté des Sciences et Ingénierie de Sorbonne Université, deux postes sont ouverts avec…

Actualités |

LA CONFÉRENCE INTERNATIONALE FRANCOPHONE SUR L’INTERACTION HUMAIN-MACHINE PREND PLACE À PARIS DU 25 AU 29 MARS

35ème Conférence Internationale Francophone sur l’Interaction Humain-Machine La conférence IHM’24, soutenue par l’Association Francophone d’Interaction Humain-Machine (AFIHM), est le lieu privilégié d’échanges sur les dernières avancées de la Recherche, du Développement et de l’Innovation en Interaction Humain-Machine. Elle se déroulera du 25 au 29 mars 2024 à Sorbonne Université, à…

Actualités |

PROJET NEUROHCI : DÉVELOPPER DES MODÈLES IHM DU COMPORTEMENT UTILISATEUR-UTILISATRICE

Projet NeuroHCI – Prise de décisions multi-échelle avec les systèmes interactifs Les neurosciences étudient les phénomènes impliquant à la fois la prise de décision et l’apprentissage chez les humains, mais ont reçu peu d’attention en IHM. Le projet NeuroHCI est un projet en interaction humain-machine (IHM) qui vise à concevoir…

Actualités |

DYNAMISME RENOUVELÉ À L’ISIR

L’ISIR connaît en ce début d’année 2024 de récentes évolutions, marquées par l’arrivée d’une nouvelle direction composée de Stéphane Doncieux* et Mohamed Chetouani**. La direction entrante succède à Guillaume Morel, professeur en robotique, qui occupait la fonction de directeur depuis 2019. *Stéphane Doncieux, directeur de l’ISIR, est professeur d’informatique…

Actualités |

3 ÉQUIPES DE L’ISIR SE PRÉPARENT POUR LES ÉPREUVES DU CYBATHLON 2024

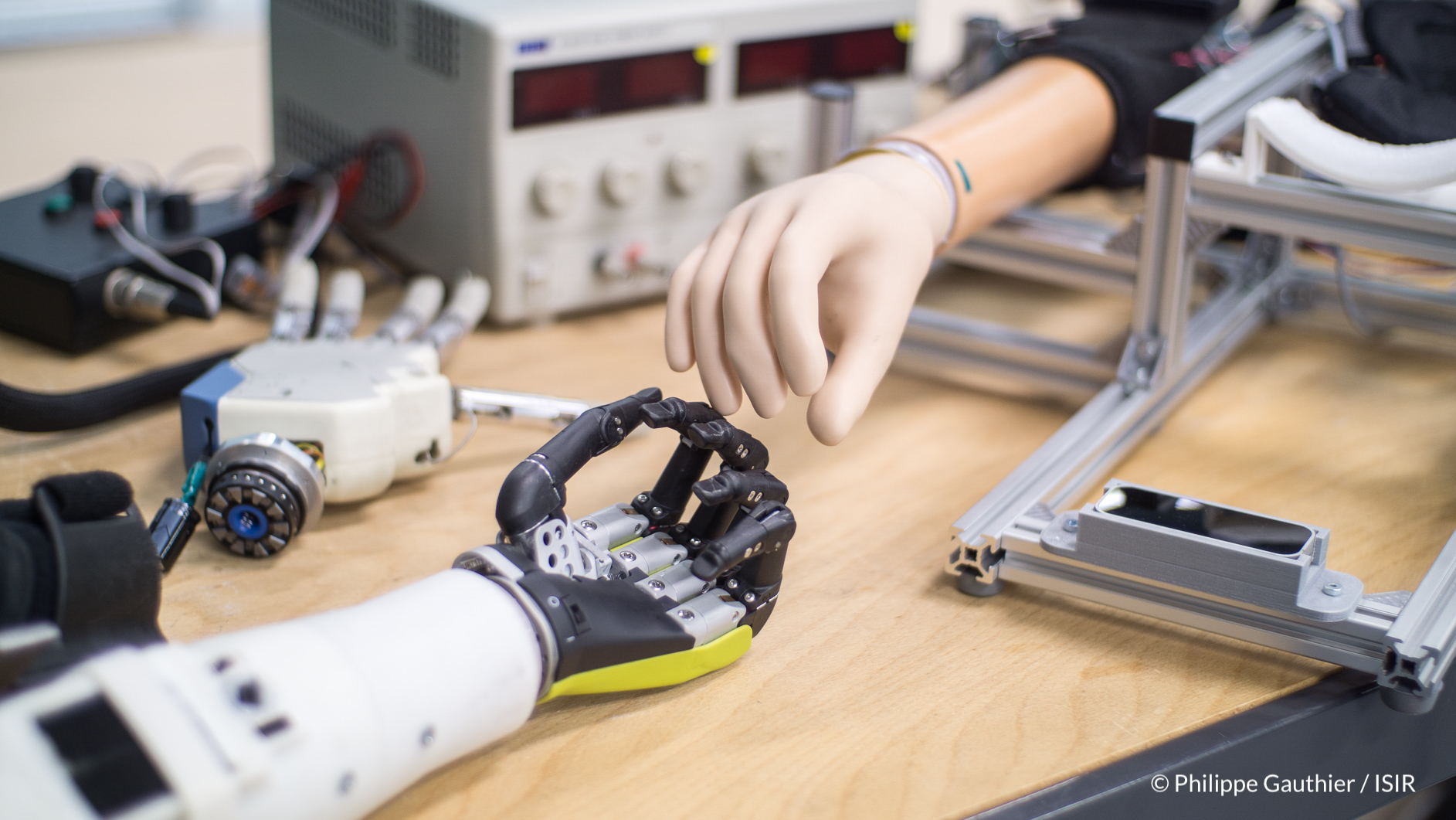

Cette année, l’ISIR se présentera au Cybathlon avec trois équipes : « A-eye », « Smart ArM », et « Smart ArM ROB ». Lors de cette compétition, les équipes pourront démontrer leurs avancées technologiques et les compétences de leurs pilotes dans des tâches spécifiques de la vie quotidienne. Ce vendredi 2 février, deux des équipes…

Actualités |

LA RÉALITÉ VIRTUELLE EN CHIRURGIE : UNE ÉTUDE SUR L’IMPACT DE L’IMMERSION SUR L’APPRENTISSAGE CHIRURGICAL

Source : CNRS Sciences Informatiques Dans le cadre de son Master 2 de sciences chirurgicales, Eya Jaafar, encadrée par Ignacio Avellino, chargé de recherche CNRS à l’ISIR et le professeur Geoffroy Canlorbe (AP-HP – Sorbonne Université), a étudié les impacts de la vidéo immersive par casque de réalité virtuelle…