À l’heure où les interactions à distance se généralisent, que ce soit en raison de l’essor du numérique, de la réalité virtuelle ou des périodes de distanciation sociale, une question persiste : comment maintenir un lien affectif sans contact physique ? Le toucher social, pourtant fondamental pour le bien-être psychologique et physiologique, reste difficile à recréer à distance. Son absence peut accentuer les sentiments d’isolement, d’anxiété et le besoin de lien social.

C’est de ce constat qu’est né le projet Audio-touch, une recherche menée à l’ISIR. Il s’appuie sur une intuition originale : exploiter les liens entre toucher et audition pour traduire des gestes tactiles affectifs en sons. En d’autres termes, il s’agit de rendre le toucher audible, pour mieux le faire percevoir à distance.

Ce projet est le fruit d’une collaboration entre Alexandra de Lagarde, doctorante à l’ISIR, Catherine Pelachaud, directrice de recherche CNRS à l’ISIR, Malika Auvray, directrice de recherche CNRS à l’ISIR, et Louise P. Kirsch, maîtresse de conférences à l’Université Paris Cité et ancienne post-doctorante à l’ISIR. Cette étude s’inscrit également dans le cadre du programme ANR MATCH, qui explore la perception du toucher dans les interactions avec des agents virtuels.

Et si l’on pouvait entendre une caresse ?

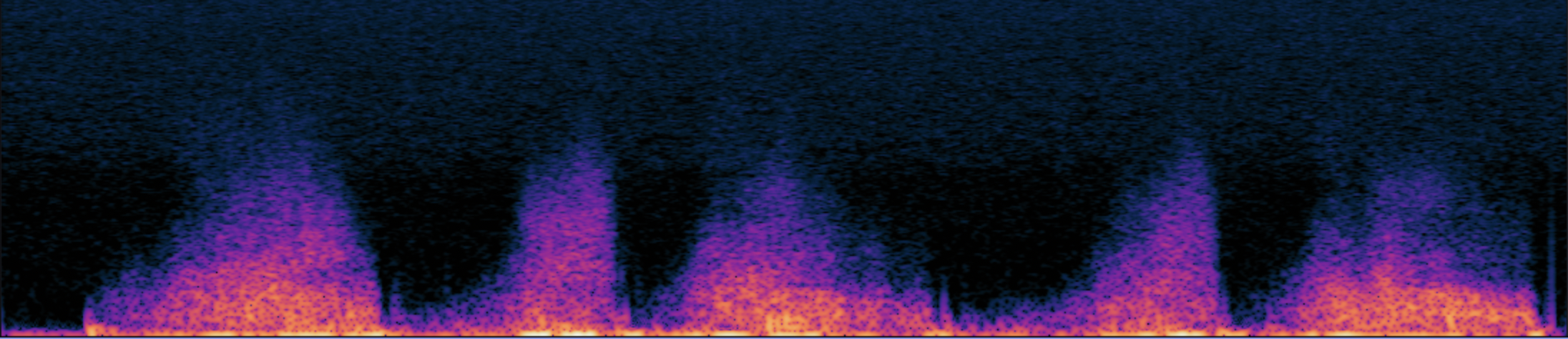

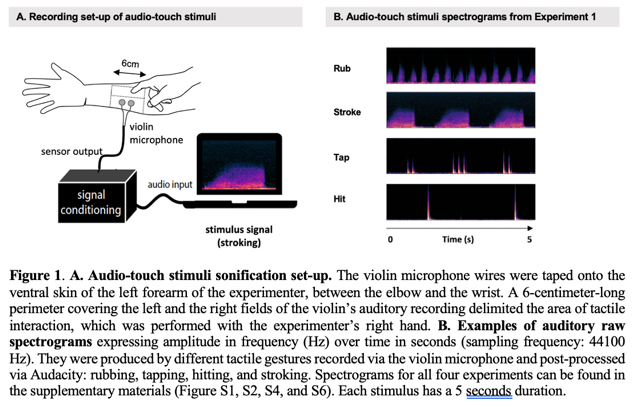

Le projet Audio-touch repose sur une observation simple : le toucher et l’audition partagent une base physique commune, celle des vibrations. Les recherches en sonification ont déjà démontré qu’il était possible de traduire des mouvements et leurs propriétés en sons. Le projet prolonge cette idée en se demandant s’il est possible de convertir les gestes du toucher social, comme une caresse, une tape ou une pression, en signaux auditifs compréhensibles.

L’objectif est double : étudier la faisabilité technique de convertir du toucher peau à peau en sons, et déterminer expérimentalement quelles informations du toucher social les stimuli audio-touch pouvaient communiquer aux personnes qui les écoutent. Le projet s’inscrit dans une approche expérimentale, menée au croisement des interactions humain-agent, de la cognition sociale, de l’haptique et de l’acoustique.

Quatre expériences pour tester la perception sonore du toucher

Au cœur du projet, une série de quatre expériences ont permis d’évaluer la reconnaissance de ces gestes et émotions à partir des sons audio-touch créés :

– les participant-es ont correctement catégorisé les gestes (expérience 1) ;

– les participant-es ont identifié les émotions transmises (exp. 2) ;

– leur reconnaissance a été influencée selon la surface sur laquelle le toucher avait lieu (exp. 3 et 4).

Les participant-es qui écoutaient les stimuli audio-touch peau à peau ont associé avec précision les sons à des gestes spécifiques et ont identifié de façon cohérente les intentions socio-émotionnelles sous-jacentes aux touchers convertis en sons. De plus, les mêmes mouvements ont été enregistrés avec des objets inanimés, et des expériences supplémentaires ont révélé que la perception des participant-es était influencée par les surfaces impliquées dans les interactions tactiles (peau vs plastique). Ces résultats sont significatifs : ils démontrent que les gestes tactiles sociaux, leurs intentions socio-émotionnelles et la surface touchée peuvent être reconnus à partir des sons produits.

Vers de nouvelles formes de communication multisensorielle

Ce projet vient compléter les travaux du projet ANR MATCH, qui vise à simuler l’illusion du toucher dans des environnements virtuels. L’approche du projet Audio-touch contribue à la compréhension des stratégies multisensorielles, en fournissant des données empiriques sur la perception du toucher via l’audition. Il alimente ainsi la réflexion sur le design des agents virtuels immersifs, capables de susciter un sentiment de lien social grâce à une combinaison subtile de signaux sensoriels.

Ces travaux font l’objet d’une parution dans la revue scientifique Proceedings of the National Academy of Sciences (PNAS) sous le titre « Paving the way for social touch at a distance: Sonifying tactile interactions and their underlying emotions » . En démontrant que des gestes affectifs peuvent être reconnus à travers leur seule traduction sonore, cette recherche ouvre des perspectives prometteuses pour le développement de nouvelles formes de communication multisensorielle, notamment dans les contextes d’interaction à distance ou avec des agents virtuels.

Contacts scientifiques à l’ISIR : Malika Auvray, directrice de recherche CNRS, Alexandra de Lagarde, doctorante, et Catherine Pelachaud, directrice de recherche CNRS.

Publié le 23/05/2025.