Le projet « Apprentissage Robotique pour la Manipulation Mobile et l’Interaction Sociale » s’inscrit dans un contexte où les robots autonomes doivent répondre à des besoins complexes, tels que l’interaction physique et sociale dans des environnements réels. Les défis actuels incluent l’adaptabilité aux situations imprévues, la collaboration fluide avec les humains, et la capacité à naviguer dans des environnements variés. Ces enjeux sont particulièrement cruciaux dans des domaines tels que les services domestiques, la logistique et l’agriculture.

Le contexte

Le contexte de l’ISIR permet d’apporter une expertise unique dans les aspects multidisciplinaires de l’apprentissage robotique, incluant le contrôle, l’apprentissage automatique et l’interaction sociale. L’ISIR met également à disposition ses plateformes robotiques avancées, telles que Tiago, Miroki, Pepper et PR2, spécialement conçues pour la manipulation mobile. Avec ces ressources et son approche innovante, le laboratoire joue un rôle crucial dans le développement de robots autonomes, capables de relever les défis sociétaux et industriels, tout en renforçant les collaborations au sein de la communauté européenne de la robotique.

Les objectifs

Le projet vise à atteindre un niveau d’autonomie élevé pour les robots dans des environnements complexes. L’un des objectifs principaux est l’utilisation des modèles de langage (LLMs) pour la planification robotique, l’identification des affordances et la saisie d’objets, permettant une meilleure compréhension et interaction avec le monde réel. En parallèle, le projet cherche à développer un système intégré combinant des modèles de perception à la pointe de la technologie, notamment basés sur la vision, et des méthodes avancées de contrôle. Par exemple, la technique de QD grasp (Quality-Diversity), développée à l’ISIR, est un pilier de cette approche.

L’objectif global est de créer des robots capables d’interagir de manière autonome, efficace et fiable avec leur environnement, tout en exploitant les synergies entre perception, contrôle et apprentissage automatique pour des applications dans des domaines variés.

Les résultats

Le projet a permis l’intégration de la pile QD-grasp sur le robot Tiago, incluant des fonctionnalités avancées telles que la génération de saisies, la détection, la segmentation et l’identification d’objets. De plus, une planification basée sur les modèles de langage (LLMs) a été intégrée, permettant au robot de comprendre et d’exécuter des tâches exprimées en langage naturel par des utilisateurs humains. Ces développements améliorent considérablement l’interaction humain-robot et la capacité des robots à évoluer dans des environnements complexes.

Le projet a également participé à la compétition annuelle euROBIN, où il a démontré ses avancées en matière de modularité et de transférabilité des compétences robotiques. Nous partageons continuellement nos composants développés pour la manipulation mobile avec la communauté, contribuant ainsi à l’évolution collective des technologies robotiques et à leur application à des défis concrets.

Partenariats et collaborations

Ce projet est une initiative interne à l’ISIR, regroupant des expertises issues de différents axes de recherche et de développement. Il s’appuie notamment sur les contributions de :

– l’équipe ASIMOV (sur l’aspect manipulation et interaction robotique),

– l’équipe ACIDE (sur l’aspect cognition et interaction,

– et de l’axe prioritaire Ingénierie des systèmes intelligents.

Ces collaborations internes permettent de mobiliser des compétences complémentaires en apprentissage robotique, perception, contrôle et interaction sociale, renforçant ainsi la capacité de l’ISIR à relever des défis scientifiques et technologiques majeurs.

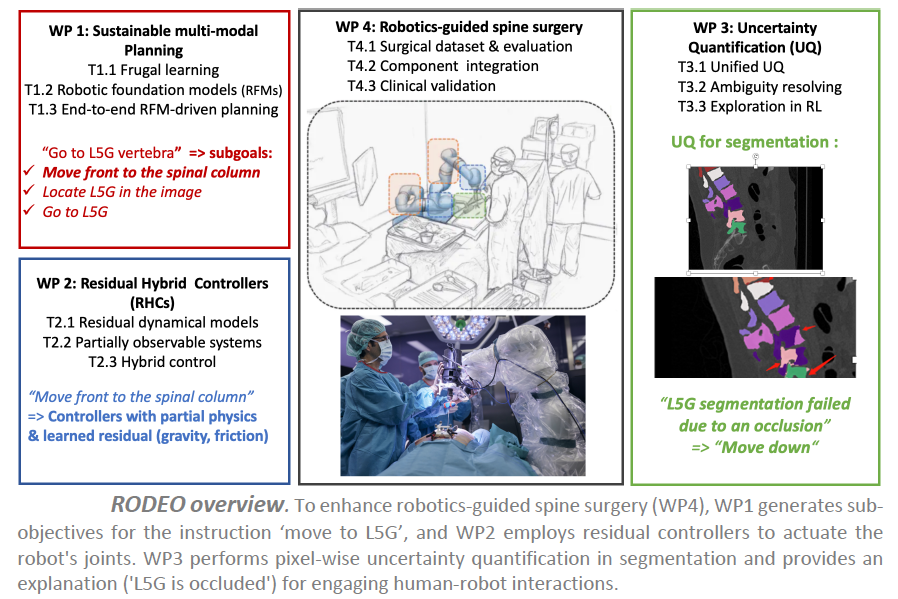

Projet RODEO – Apprentissage profond robuste pour la robotique chirurgicale

Le projet ANR RODEO vise à transformer la robotique chirurgicale en intégrant les dernières avancées en intelligence artificielle (IA). Le cadre d’application est la chirurgie guidée par robot pour la colonne vertébrale, basée sur une plateforme chirurgicale disponible à l’ISIR.

Dans ce contexte, un bras robotique à 7 degrés de liberté (DoFs) est équipé de divers capteurs (position, vitesse, force, conductivité électrique, vibrations) et utilisé pendant des interventions chirurgicales, comme l’insertion de vis pédiculaires dans la colonne vertébrale. Cette plateforme robotique actuelle utilise un ensemble de lois de commande déjà implémentées (e.g., contrôle de position, de vitesse, de force) pour exécuter des tâches ou sous-tâches chirurgicales, comme le perçage d’une trajectoire préliminaire pour le placement des vis pédiculaires. Avant l’opération, un scanner 3D du patient est réalisé, permettant au chirurgien de définir la procédure médicale à suivre pendant la chirurgie.

Bien que des contrôleurs entièrement automatiques puissent être utilisés pour certaines sous-tâches sûres, les chirurgiens préfèrent un paradigme de co-manipulation pour les opérations sensibles, où les robots chirurgicaux assistent les procédures médicales. Dans ce cas, l’assistant robotique doit réagir fidèlement aux instructions du chirurgien tout en garantissant la sécurité du patient et du personnel médical, et s’adapter à l’environnement.

Le contexte

Bien que le système actuel de co-manipulation soit utile et réponde à certains besoins des chirurgiens, il peut être considérablement amélioré pour enrichir l’expérience chirurgicale. La plateforme chirurgicale de l’ISIR manque de modules de perception et d’enregistrement, et la procédure actuelle suppose que le patient ne bouge pas une fois positionné pour la chirurgie et que la colonne vertébrale est rigide. Cela peut rendre le transfert d’informations préopératoires complexe, imprécis et dangereux pour le patient. De plus, les contrôleurs actuels ne représentent pas certains phénomènes physiques complexes lors de la co-manipulation, comme les frottements du robot, les vibrations ou la compensation gravitationnelle, tous cruciaux pour des interventions chirurgicales précises.

Les objectifs

Le projet RODEO vise à développer la prochaine génération d’IA génératives profondes pour surmonter les principaux défis mentionnés. L’objectif est de concevoir des systèmes d’IA avec une robustesse améliorée en termes de flexibilité et de fiabilité, tout en restant durables, ainsi que des modèles hybrides capables d’intégrer des connaissances physiques du monde.

L’hypothèse centrale de la recherche est que ces améliorations peuvent conduire à une avancée majeure dans la robotique chirurgicale. Des systèmes d’IA plus fiables peuvent améliorer leur acceptation par les experts médicaux et les patients, notamment en leur permettant d’évaluer leur propre confiance ou d’expliquer leurs décisions de manière compréhensible. Les modèles hybrides et durables pourraient considérablement améliorer le niveau d’automatisation dans la co-manipulation robot/chirurgien, réduisant ainsi la charge cognitive des chirurgiens et leur permettant de se concentrer entièrement sur les interventions médicales, ce qui améliorerait les procédures chirurgicales et les soins aux patients.

Les résultats

Dans notre cadre de test pour la chirurgie de la colonne vertébrale, nous attendons des améliorations majeures dans trois domaines principaux :

– concevoir des contrôleurs hybrides capables d’utiliser l’IA pour apprendre les composants résiduels des contrôleurs actuels difficiles à modéliser, tels que les frottements ou les vibrations ;

– augmenter la flexibilité du système avec des IA génératives profondes multimodales pour planifier à long terme en utilisant la perception visuelle et des méthodes basées sur l’IA pour enregistrer les scanners CT préopératoires avec les caméras de profondeur opératoires ;

– doter les systèmes d’IA de la capacité de quantifier leur propre confiance et d’expliquer leurs décisions à l’équipe chirurgicale de manière compréhensible.

Partenariat et collaboration

Le projet ANR RODEO est un projet mono-équipe mené par l’équipe projet MLR (Machine Learning and Robotics) de l’ISI, porté par Nicolas Thome, chercheur à l’ISIR et professeur à Sorbonne Université.

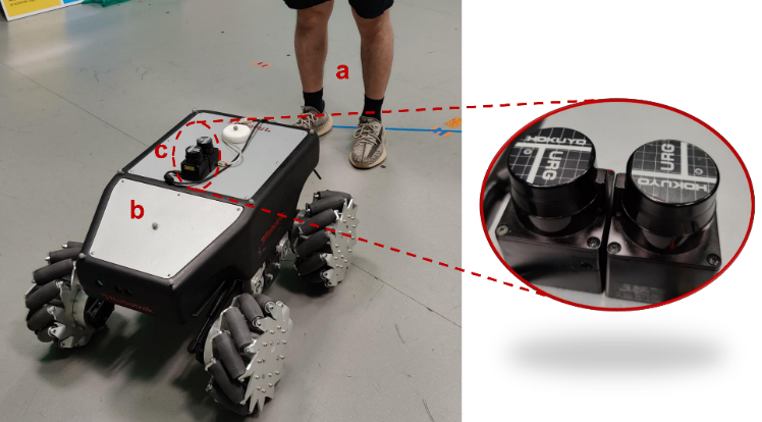

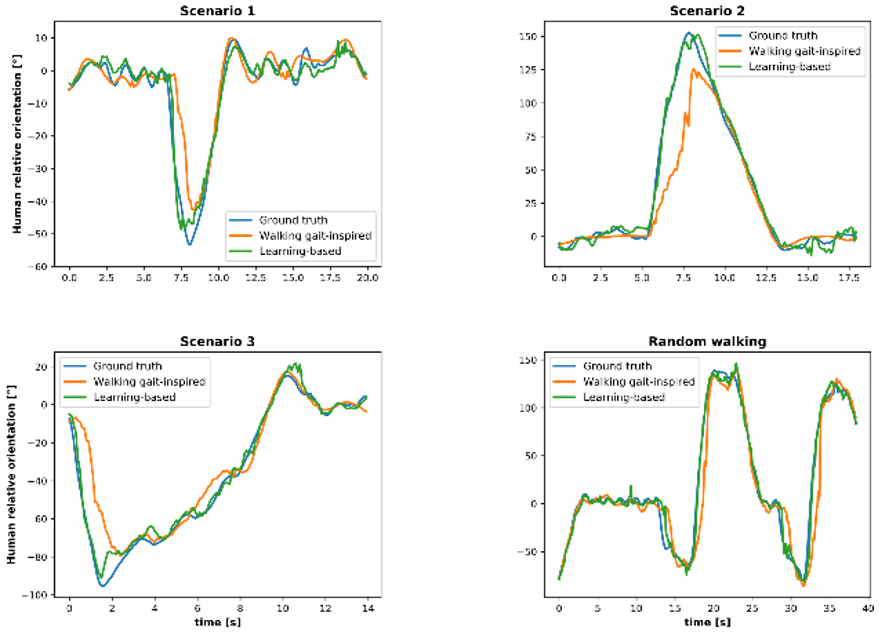

Projet FHF : A Frontal Human Following technology for mobile robots

Les robots suivant les humains sont une fonction efficace et pratique, en particulier dans le contexte de la robotique de service. Cependant, la majorité des recherches existantes se sont concentrées sur le suivi derrière un humain, avec relativement peu d’attention accordée au robot opérant devant l’humain. Ce projet de suivi frontal, où le robot reste dans le champ de vision de l’utilisateur, est plus rassurant et facilite l’interaction. De nouveaux défis se présenteront lors de la mise au point d’un tracker capable d’estimer la pose d’un utilisateur à partir d’un LiDAR 2D à hauteur de genou, en particulier lorsque les jambes sont souvent masquées l’une par l’autre. Il est également nécessaire d’assurer la sécurité de l’utilisateur tout en se demandant comment le robot peut suivre l’utilisateur dans les situations où le robot serait en retard.

Le contexte

Les robots mobiles sont de plus en plus omniprésents dans divers environnements, tels que les centres commerciaux, les hôpitaux, les entrepôts et les usines. Nombre de tâches dans ces applications sont partagées entre les robots et les opérateurs humains par la voix, la vidéo, l’interaction par la force, etc., soit parce que l’expertise ou l’agilité humaine inhérente est requise pour certaines tâches, soit parce que le robot peut fournir une assistance potentielle à l’opérateur. Dans ce projet, nous nous concentrons sur l’étude du suivi automatique de l’utilisateur par le robot mobile basé sur le LiDAR 2D. Les algorithmes communs de suivi à l’arrière maintiennent le robot à une distance de l’utilisateur. Certaines études ont montré que les gens préfèrent voir les robots dans leur champ de vision, et peuvent se sentir mal à l’aise et en danger lorsque les robots apparaissent derrière eux. En outre, les services spécifiques exigent que les robots se présentent devant les utilisateurs. Par exemple, les robots d’assistance agissent comme des chiens d’aveugle pour fournir une aide à la navigation aux malvoyants. Par conséquent, le suivi frontal devient progressivement populaire.

Les objectifs

Les objectifs scientifiques de ce projet sont les suivants :

– Construire un tracker de pose humaine (orientation et position) basé sur le LiDAR 2D à hauteur du genou pour les robots mobiles en étudiant la marche humaine ;

– Collecter des scans LiDAR de différents volontaires ainsi que des données de vérité terrain sur l’orientation humaine afin de construire un modèle basé sur les données pour améliorer l’estimation de l’orientation humaine ;

– Résoudre le problème des jambes se cachant l’une et l’autre lors du balayage en modélisant la marche ou en utilisant des techniques d’apprentissage automatique ;

– Développer un générateur de mouvement permettant au robot de se déplacer devant l’utilisateur en toute sécurité et de manière naturelle.

Les résultats

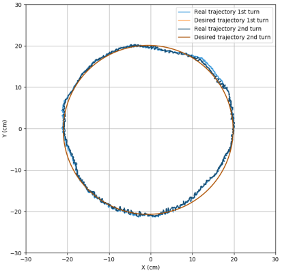

Douze volontaires (trois femmes et neuf hommes) ont été invités à participer à l’expérience de suivi frontal, et le tracker de posture humaine basé sur la marche humaine a montré de bonnes performances. Les analyses quantitatives ont révélé que l’erreur absolue moyenne (MAE) de position était d’environ 4 cm et que la MAE d’orientation était inférieure à 12 degrés pour la marche complexe.

Les données collectées pendant six heures sur cinq volontaires (une femme et quatre hommes) ont été utilisées pour construire des modèles permettant d’améliorer l’estimation de l’orientation. Grâce à la résolution du problème de retard, le modèle personnalisé a permis d’obtenir une MAE de 4 à 7 degrés pour les cinq volontaires.

Le générateur de mouvement à suivi frontal permet au robot de venir naturellement devant l’utilisateur, toujours à une distance de sécurité d’un mètre au cours de l’expérience. Voir la vidéo pour plus de détails.

Publications

– 2D LiDAR-Based Human Pose Tracking for a Mobile Robot, ICINCO 2023,

– Human Orientation Estimation from 2D Point Clouds Using Deep Neural Networks in Robotic Following Tasks, soumis à IROS 2024,

– Large Workspace Frontal Human Following for Mobile Robots Utilizing 2D LiDAR, soumis à JIRS.

Projet NeuroHCI – Prise de décisions multi-échelle avec les systèmes interactifs

Ce projet pluridisciplinaire s’appuie sur les Neurosciences Computationnelles pour développer des modèles IHM du comportement utilisateur-utilisatrice. Il s’agit d’étudier dans quelle mesure on peut transposer les théories, modèles et méthodes des Neurosciences Computationnelles à l’IHM.

Le projet NeuroHCI vise à améliorer la prise de décision humaine dans les mondes physique et numérique dans des contextes interactifs. Les situations dans lesquelles un humain prend une décision avec un système interactif sont variées :

Est-ce que j’utilise mon expérience ou Google Maps pour choisir mon itinéraire ? Est-ce que je réponds à cet e-mail sur mon smartphone ou sur mon PC ? Est-ce que j’utilise des menus ou des raccourcis pour sélectionner cette commande fréquente ? Est-ce que j’utilise le robot chirurgical Da Vinci pour opérer mon patient ou les instruments laparoscopiques traditionnels ? Comment puis-je atteindre cet objet avec ma prothèse robotique ?

La décision peut porter sur un choix complexe dans le monde réel assisté par un ordinateur (par exemple, un traitement médical) ou sur le choix d’une méthode pour réaliser une tâche numérique (par exemple, modifier une photo avec l’outil préféré).

Le contexte

Les neurosciences étudient les phénomènes impliquant à la fois la prise de décision et l’apprentissage chez les humains, mais ont reçu peu d’attention en IHM.

Le projet NeuroHCI est un projet en interaction humain-machine (IHM) qui vise à concevoir des systèmes interactifs développant l’expertise de l’utilisateur-utilisatrice en établissant un partenariat humain-machine. L’interaction avec ces systèmes peut être vue comme un problème de prise de décision à plusieurs échelles :

– Une tâche, par exemple choisir le bon traitement médical sur la base de recommandations basées sur l’IA ;

– Une méthode, par exemple choisir parmi différents dispositifs ou modalités pour réaliser une tâche ;

– Un objet, par exemple avec quel objet physique ou virtuel les utilisateurs-utilisatrices vont interagir ;

– Un mouvement, par exemple quelle trajectoire pour atteindre l’objet cible.

Les objectifs

L’objectif scientifique est de comprendre comment les utilisateurs-utilisatrices prennent des décisions avec des systèmes interactifs et comment ces décisions évoluent dans le temps. En effet, les utilisateurs-utilisatrices développent progressivement une expertise au cours de l’utilisation répétée des systèmes interactifs. Cette expertise influence la façon dont ils/elles prennent leurs décisions. Cela nécessite l’étude simultanée des phénomènes d’apprentissage et de prise de décision qui sous-tendent l’utilisation des systèmes interactifs.

L’objectif applicatif est de concevoir et de mettre en œuvre de meilleurs systèmes interactifs et adaptatifs. L’être humain s’adapte et développe son expertise en utilisant un système interactif. L’objectif ici est que le système, de son côté, évolue également pour s’adapter à ses utilisateurs-utilisatrices, c’est-à-dire qu’il s’habitue à leur comportement et en particulier à leur expertise. Il s’agit donc d’établir un partenariat humain-machine dans lequel les deux acteurs (humain et machine) s’adaptent l’un à l’autre.

Les résultats

Pour atteindre ces objectifs, nous démontrons les avantages de notre approche à travers 3 applications, pour lesquelles des plateformes existent déjà et sont maintenues par les partenaires, mais où des défis scientifiques demeurent pour leur adoption dans le monde réel. Ces trois applications sont :

– les interfaces graphiques intelligentes comme les systèmes de recommandation basés sur l’IA ;

– les systèmes de simulation immersifs offrant un riche retour haptique ;

– et les interfaces cobotiques médicales qui visent à restaurer ou à améliorer la capacité des humains à interagir avec des objets dans le monde réel.

Notre hypothèse de recherche est qu’il est nécessaire de développer des modèles computationnels robustes d’apprentissage et de prise de décision en IHM. Les modèles computationnels permettent d’expliquer et de prédire le comportement humain en synthétisant des phénomènes complexes de manière testable et réfutable. En IHM, ils servent à évaluer la qualité d’une interface sans avoir à mener des études d’utilisateurs-utilisatrices longues et coûteuses. Lorsque ces modèles sont robustes, ils peuvent être intégrés dans des systèmes interactifs pour optimiser l’interaction et adapter l’interface en fonction de l’expertise et/ou des actions des utilisateurs-utilisatrices.

Partenariats et collaborations

Porté par Gilles Bailly, directeur de recherche CNRS à l’ISIR, le projet ANR NeuroHCI est un projet inter-équipes interne à l’ISIR, qui implique plusieurs membres du laboratoire.

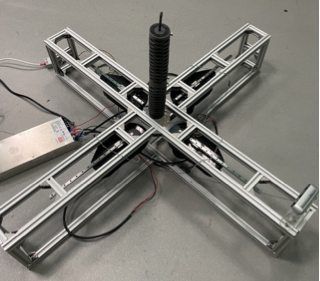

Ce projet vise le développement d’un manipulateur souple pour la cueillette. La cueillette de fruit ou de légume nécessite une préhension compliante et dextre pour garantir l’intégrité de l’objet ainsi qu’une structure porteuse souple pour pouvoir naviguer entre les branches sans les abimer. L’objectif est de développer un robot trompe continu sans articulation et actionné par des moteurs déportés et des câbles, à l’image des tendons dans une main humaine. Le projet se décline en 3 principales problématiques bien connues dans le domaine de la robotique, à savoir la conception, la modélisation et la commande. Ces 3 aspects sont en réalité très imbriqués pour ce genre de systèmes complexes. Une bonne conception avec une bonne intégration des actionneurs et des capteurs facilite énormément la commande par le biais d’une modélisation adéquate qui répond à la fois à un certain réalisme et une efficacité de calcul.

Le contexte

Dans un contexte de lutte contre le réchauffement climatique et de convergence technologique inédite (numérique, intelligence artificielle, …), l’agriculture doit se réinventer pour produire mieux, dans le respect de l’environnement et de la santé humaine. La robotique agricole est l’un des leviers de cette transformation. Elle constitue une solution prometteuse pour répondre aux enjeux environnementaux et sanitaires, qui sont posés actuellement en France et ailleurs dans tous les pays développés. L’urgence climatique imposera une réduction de plus en plus forte de l’utilisation des intrants (produits phytosanitaires, eau, etc.) et des énergies fossiles. Par ailleurs, la filière agricole souffre d’un manque d’attractivité et d’une image négative chez beaucoup de jeunes (ruralité, tâches répétitives, épuisement, difficultés économiques, isolement, etc.). La numérisation et la robotisation permettront la valorisation de ce métier et déchargera l’agriculteur des tâches répétitives et fatigantes telles que le désherbage, le portage, la cueillette et l’entretien régulier des cultures.

Les objectifs

L’objectif scientifique majeur est de pouvoir répondre aux trois problématiques que sont la conception, la modélisation et la commande, dans une approche simultanée et intégrée, parfois dite de co-design (hardware et software).

Le robot visé s’apparente à une trompe, d’environ un mètre, capable d’adopter plusieurs configurations stables de manière continue. Le laboratoire dispose de deux prototypes de manipulateurs souples continus pour mettre en œuvre différentes solutions. Le premier est constitué d’une colonne vertébrale en fils métalliques tressés et de disques en matériau à faible friction pour le passage des câbles. On utilise un actionnement par câbles en nylon et des servo-moteurs contrôlés en force pour garantir la tension dans le câble dans un intervalle donné. Le second est en TPU imprimé et utilise une structure de câbles antagonistes (un moteur actionne deux câbles antagonistes). Cette solution permet de garantir naturellement une tension minimale dans les câbles à chaque instant.

Deux principales voies sont étudiées concernant la commande de ces manipulateurs. Le manipulateur en fils métalliques tressés implémente actuellement un contrôle en boucle ouverte basé sur les données. L’exploration de son environnement a été réalisée pour apprendre, via un réseau de neurones, le modèle géométrique inverse (longueur de câbles à tirer en fonction de la position 3D de l’effecteur). Le manipulateur en TPU implémente quant à lui un contrôle basé sur la perception. L’idée est de reconstruire sa forme dans l’espace à l’aide de caméras stéréo pour pouvoir contrôler l’effecteur.

Les résultats

Les récents résultats ont démontré que l’utilisation d’un contrôle basé sur les données était tout à fait applicable dans le cas des manipulateurs souples actionnés par câbles. Que ce soit pour des tâches statiques (tâche de Reaching) ou dynamiques (suivi de trajectoires), la précision obtenue est suffisante. De plus, l’étude de la robustesse et de la répétabilité du système a démontré sa capacité à réaliser n’importe quelle tâche dans son environnement de travail de manière répétitive avec une variabilité millimétrique.

Partenariats et collaborations

Les membres du réseau Roboterrium – Equipex Tirrex sont partenaires du projet.

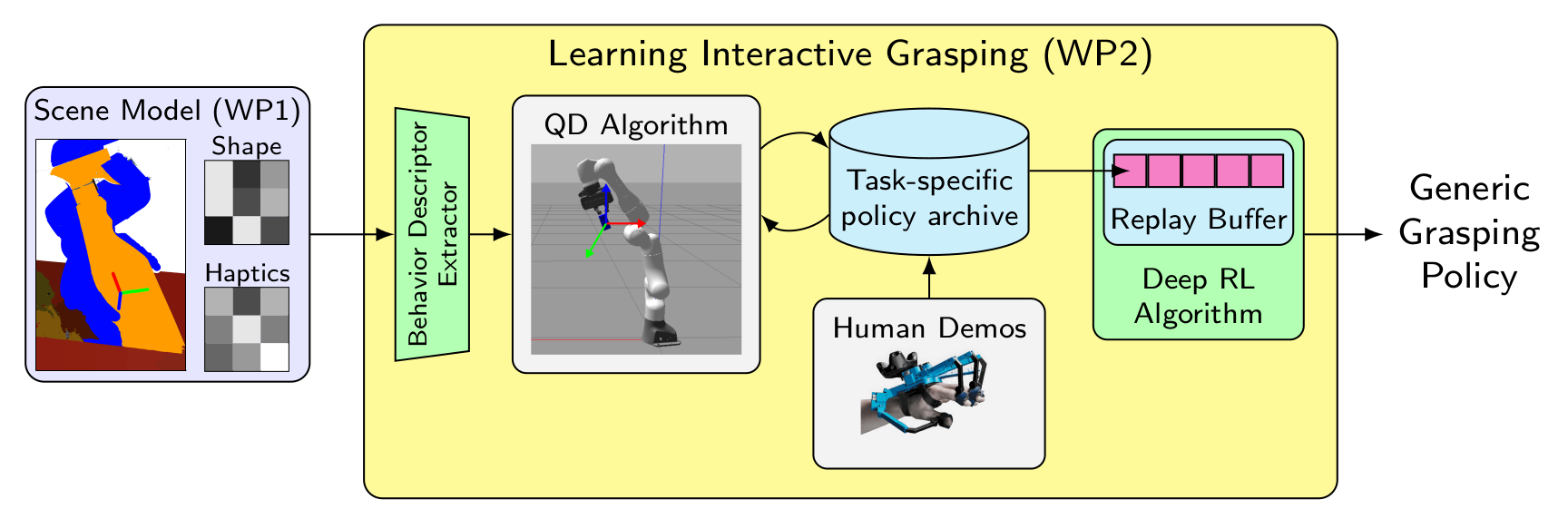

Projet Learn2Grasp : Learning Human-like Interactive Grasping based on Visual and Haptic Feedback

Le projet Learn2Grasp a pour but de développer des stratégies interactives de saisie d’objets dans des environnements encombrés en utilisant un bras robotique et une main dextre très sensible. Les stratégies de saisie seront apprises à l’aide de méthodes d’apprentissage par renforcement profond dans une simulation et sur robot réel, en utilisant des informations provenant de caméras RGB-D et des capteurs tactiles. La saisie est une tâche difficile pour l’apprentissage car il s’agit d’un problème à récompenses rares. Pour résoudre ce problème, deux approches seront combinées : une initialisation à partir de démonstrations par un humain avec une interface de téléopération immersive et une exploration des comportements améliorée par des algorithmes de qualité-diversité.

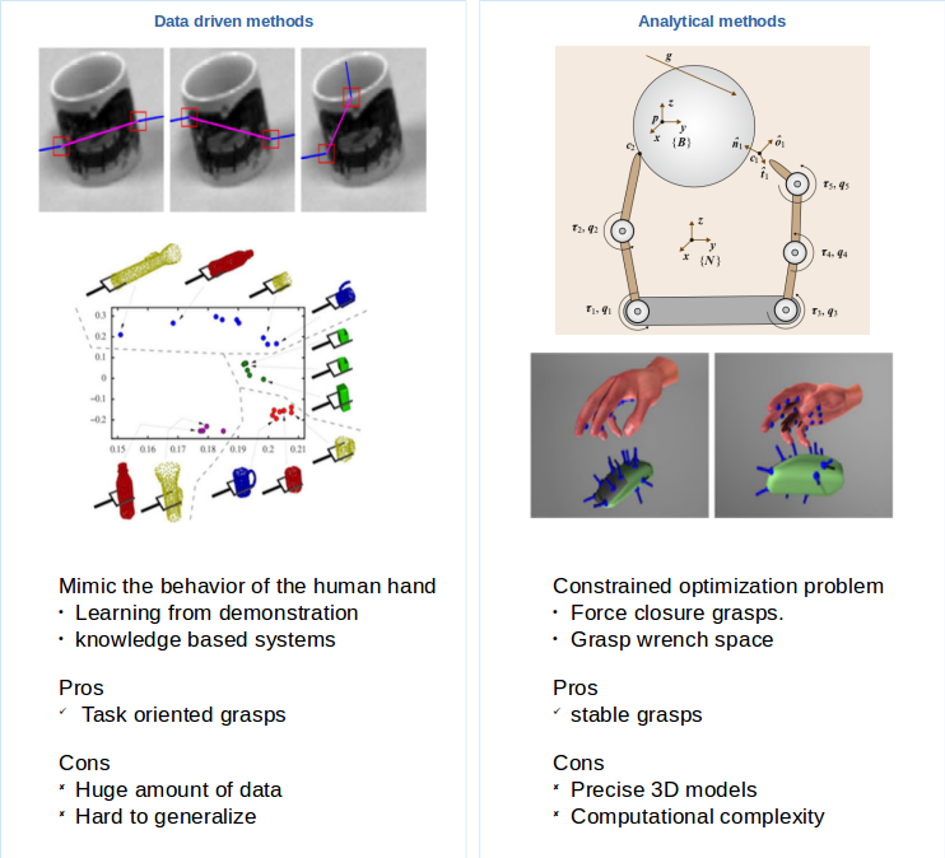

Le contexte

Les approches existantes de la manipulation fondées sur la théorie du contrôle sont efficaces mais requièrent habituellement un modèle précis des objets à saisir et de leur environnement. Inversement, les méthodes reposant sur l’apprentissage peuvent être entraînées de bout en bout sans un modèle élaboré de l’environnement, mais elles sont souvent inefficaces sur les problèmes d’exploration difficile, et demandent des gros volumes de données d’entraînement. Une troisième possibilité est d’apprendre à partir de démonstrations humaines, mais la généralisation au-delà des conditions des démonstrations est difficile.

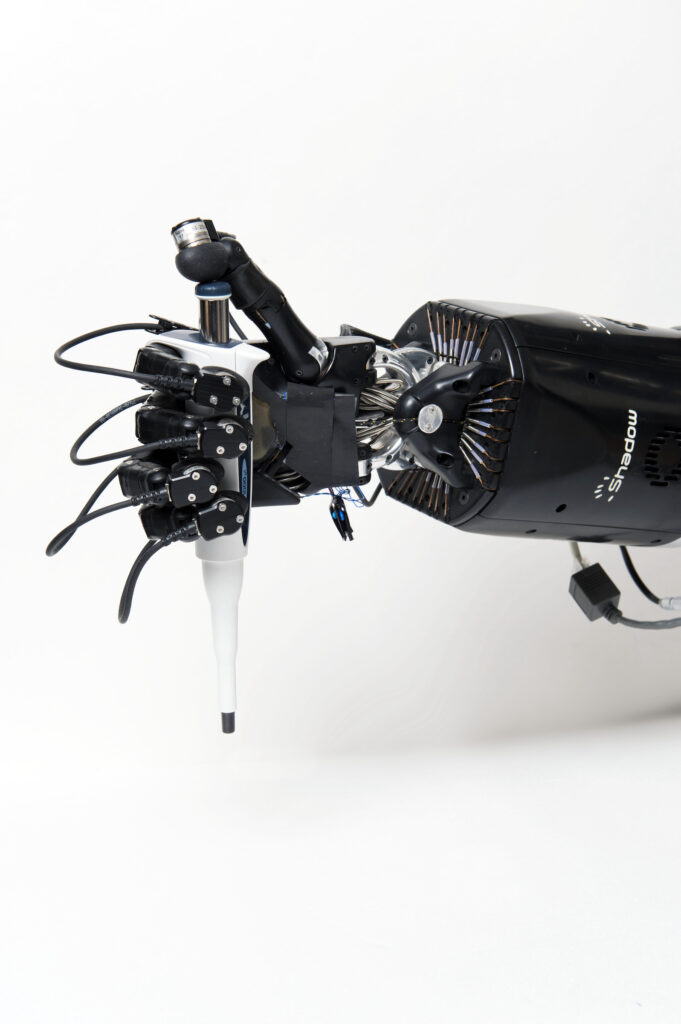

Le partenariat franco-allemand Learn2Grasp, fait intervenir deux partenaires complémentaires pour résoudre ce problème. L’Université de Bonn a une expérience reconnue en perception visuelle, modélisation de scène et apprentissage par démonstration, et Sorbonne Université a une expertise en apprentissage d’actions et stratégies d’exploration efficace dans des contextes de récompense rare. Les deux partenaires utiliseront des plateforme robotiques modernes intégrant des mains dotées de capacités tactiles avancées.

Les objectifs

Les objectifs scientifiques du projet sont les suivants :

– Coupler les méthodes de modélisation et d’analyse de scènes développées par Bonn et les techniques de génération de politiques diverses de Sorbonne Université, de façon à développer une méthode de génération de mouvements de saisie robuste, efficace, et économe en données et en calcul.

– Intégrer la modalité tactile avec les méthodes de perception basée sur la vision de façon a apprendre des politiques en boucle fermée plus flexibles et robustes.

– Permettre un apprentissage sur des données hybrides, exploitant au mieux des données issues de simulations, de démonstrations humaines (par une interface de téléopération) et d’expériences sur système réel.

Ces tâches sont structurées en 4 unités de travail :

– WP1 : Modélisation et prédiction de scène structurée et multimodale (Leader : Université de Bonn),

– WP2 : Apprentissage de la saisie interactive (Leader : Sorbonne Université),

– WP3 : Intégration technique (Leader : University of Bonn),

– WP4 : Management et collaboration scientifique (Leader : Sorbonne Université).

Les résultats

Le projet aura pour issue la réalisation d’un système intégré faisant appel aux technologies de perception visuelle et tactile développées pour construire des représentations de la scène, et utilisant de ces représentations pour apprendre efficacement, avec un volume de données non-simulées réduit, des politiques en boucle ouverte et en boucle fermée diverses permettant une saisie robuste en environnement encombré. Ce système devra être évalué sur environnement simulé et réel.

Un autre objectif du projet Learn2Grasp est de renforcer les liens et la collaboration scientifique entre l’équipe AIS de Bonn et l’ISIR à Sorbonne Université, de façon à développer un pôle d’expertise compétent sur tous les aspects de l’apprentissage pour la manipulation d’objets, allant de la perception et la création de représentations jusqu’à la génération d’actions.

Partenariats et collaborations

Le projet Learn2Grasp (réf. ANR-21-FAI1-0004) est une collaboration de recherche entre :

– l’équipe AIS de l’Université de Bonn,

– et l’ISIR de Sorbonne Université.

Cette collaboration est menée dans le cadre de l’appel à projets bilatéral franco-allemand en intelligence artificielle (MESRI-BMBF) 2021. Sa réalisation s’échelonne sur 4 ans, de 2021 à 2025.

Il est coordonné à Sorbonne Université par Miranda Coninx, maître de conférences dans l’équipe AMAC de l’ISIR, et à l’université de Bonn par Prof. Dr. Sven Behnke, responsable de l’équipe AIS (Autonomous Intelligent Systems).

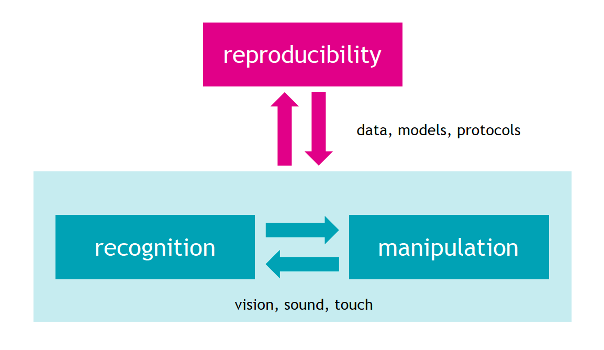

Projet CORSMAL: Collaborative Object Recognition, Shared Manipulation And Learning

Dans les robots collaboratifs et d’assistance, la transmission d’objets est une capacité fondamentale et essentielle. Bien que cette capacité puisse sembler simple, puisque les humains effectuent le transfert d’objets sans problème, il est très difficile de le reproduire chez les robots. Le problème du transfert d’objets a été étudié dans le passé et reste un domaine de recherche actif. Il englobe de nombreux sous-problèmes tels que l’étude de l’intention humaine, l’extraction des caractéristiques de l’objet, l’accessibilité, la synthèse de la manipulation et bien d’autres encore.

CORSMAL propose de développer et de valider un nouveau cadre pour la reconnaissance et la manipulation d’objets en collaboration avec des humains, capable d’imiter la capacité humaine d’apprentissage et d’adaptation à travers un ensemble de manipulateurs, de tâches, de configurations de détection et d’environnements différents. Le projet explore la fusion de plusieurs modalités de détection (le toucher, le son et la vision à la première ou à la troisième personne) pour estimer les propriétés physiques des objets de manière précise et robuste dans des environnements bruyants et potentiellement ambigus. L’objectif principal est de définir des architectures d’apprentissage pour les données sensorielles multimodales et pour les données agrégées provenant de différents environnements. L’objectif est d’améliorer continuellement l’adaptabilité et la robustesse des modèles appris, et de généraliser les capacités à travers les tâches et les sites. La robustesse du cadre proposé sera évaluée à l’aide de prototypes mis en œuvre dans différents environnements. Il est important de noter qu’au cours du projet, nous organiserons deux défis communautaires pour favoriser le partage des données et soutenir la reproductibilité des expériences dans des sites supplémentaires.

Le contexte

La coopération avec les humains est un défi important pour la robotique, car les robots seront amenés à travailler conjointement avec les humains. CORSMAL considère un scénario de coopération typique dans lequel un humain et un robot se transmettent un objet inconnu et partiellement occulté, comme par exemple un verre ou une tasse partiellement remplie de liquide, ce qui rend extrêmement difficile la détermination des affordances et des points de prise appropriés. La caractérisation des objets partiellement observables est en effet l’un des problèmes les plus critiques pour instancier des actions robotiques appropriées.

Bien que la mécatronique des manipulateurs robotiques ait atteint un niveau de sophistication considérable, la manipulation d’objets aux propriétés physiques inconnues dans des scènes du monde réel reste extrêmement difficile. Cela est principalement dû à l’absence de modèles appropriés et d’une quantité suffisante de données pour l’apprentissage de ces modèles. Les progrès sont également entravés par l’absence d’une masse critique de chercheuses et chercheurs abordant et évaluant la même tâche à l’aide d’un ensemble de données commun.

Pour résoudre ce problème, CORSMAL construira, grâce à l’inclusion de priorités physiques et de connaissances du domaine, des modèles d’apprentissage qui fonctionnent avec moins de données. En outre, CORSMAL mettra les données d’entraînement et les modèles à la disposition des autres chercheuses et chercheurs et, pour faciliter le partage des données et l’implication de la communauté des scientifiques, organisera deux défis lors de conférences internationales. Ces défis et l’évaluation associée illustreront l’interaction humain-robot typique qui a lieu lorsque le robot est chargé de manipuler des objets arbitraires manipulés quotidiennement par les humains.

Les objectifs

Les questions scientifiques spécifiques que CORSMAL abordera sont :

– Peut-on imiter la capacité humaine d’apprendre à partir de quelques exemples et d’adapter rapidement la manipulation en fusionnant de multiples indices ?

– Pouvons-nous reproduire la capacité humaine à prédire les affordances et les forces applicables appropriées pour le transfert d’objets inconnus à partir d’indices partiels ?

– Pouvons-nous apprendre efficacement les compromis entre les modèles spécifiques au manipulateur et les modèles généralisés par le partage des données pour une reconnaissance et une manipulation précise et robuste des objets ?

Pour répondre à ces questions, CORSMAL étudiera, concevra et validera de nouveaux modèles et technologies d’apprentissage pour combler l’écart entre la perception et la manipulation d’objets inconnus par le biais de la détection multimodale, de l’apprentissage automatique et de l’adaptation de modèles. Le projet vise à créer un système artificiel capable d’apprendre des primitives de mouvement adaptées à l’interaction physique humain-robot. Le système doit améliorer sa compréhension de l’environnement en utilisant les modèles appris et les observations d’un humain pour façonner les affordances du robot dans la manipulation d’objets.

Dans ce projet, l’équipe de l’ISIR se concentrera sur le problème de la préhension. En effet, un robot n’est toujours pas capable de saisir un objet aux propriétés inconnues, en mouvement et partiellement caché, comme il l’est lorsqu’il est tenu dans une main humaine.

Les résultats

Les humains peuvent sentir, peser et saisir divers objets, et en déduire simultanément leurs propriétés matérielles tout en appliquant la bonne quantité de force. Nous voulons reproduire cela avec notre système robotique. Pour ce faire, nous avons besoin d’obtenir des informations sur l’interaction entre notre robot et l’objet à saisir.

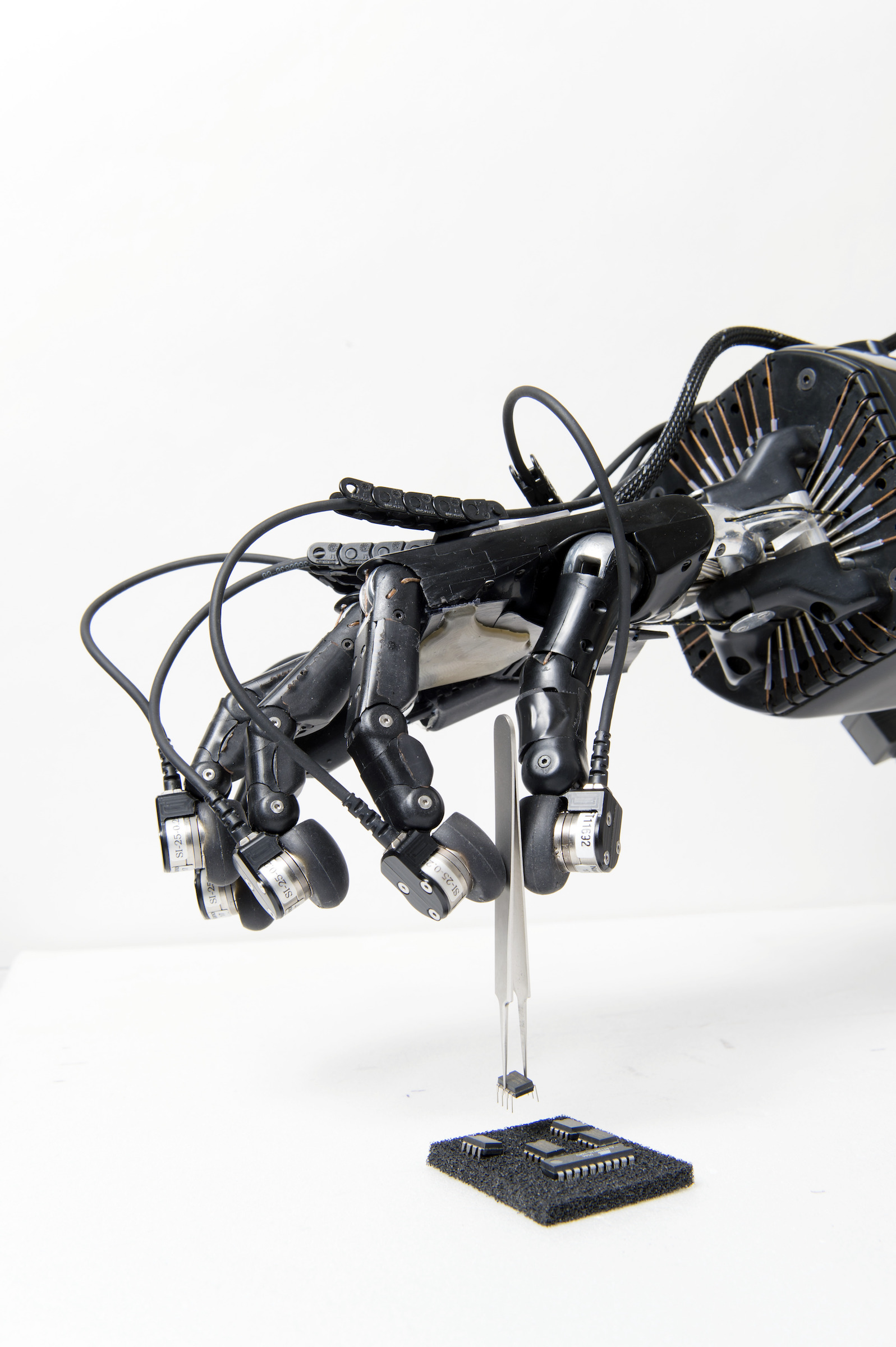

Notre approche combinera les deux méthodes existantes pour résoudre le problème de la préhension : la méthode analytique et la méthode basée sur les données (illustrée dans la figure ci-dessous).

La main du robot sera préformée en fonction de la forme primitive de l’objet, en s’inspirant des approches basées sur les données qui étudient la façon dont les humains effectuent des saisies, ce qui permet de réduire l’espace de recherche pour les saisies appropriées. Nous initierons ensuite la fermeture de la main jusqu’à ce qu’un maximum de contacts soit établi avec l’objet. Sur la base des emplacements des points de contact et des positions des articulations, nous obtiendrons les emplacements de contact dans l’espace 3D, ainsi que la somme des forces appliquées à l’objet. Nous rechercherons les forces appliquées pour obtenir une fermeture de force par une combinaison de points de contact. Lorsque la fermeture de force n’est pas atteinte, une approche analytique aidera à trouver le point de contact où placer/replacer un doigt.

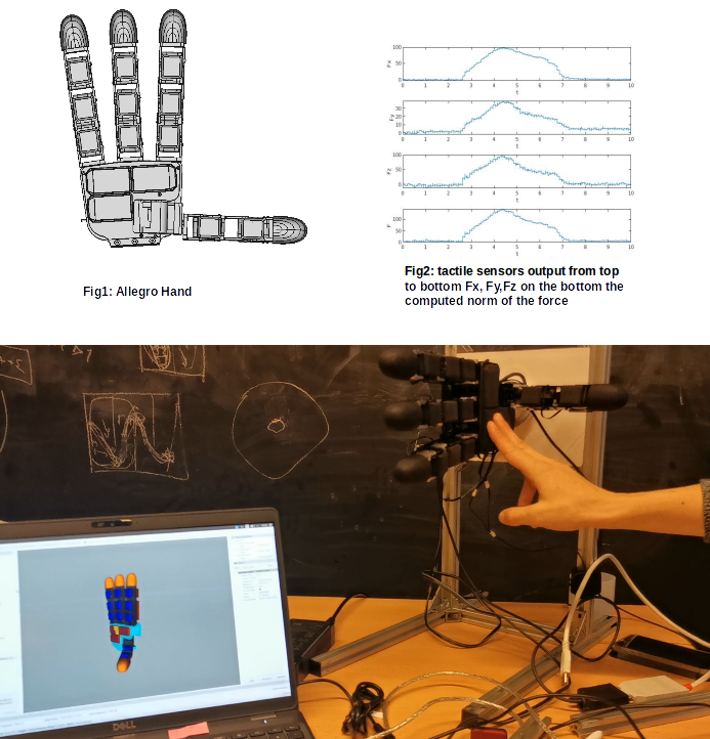

Notre approche sera testée et validée avec la main Wonik Allegro Hand with 16 DOF équipée de 368 capteurs tactiles de Xela electronics répartis sur les phalanges de la main, sa paume et le bout de ses doigts.

Partenaires et collaborations

Ce travail est soutenu par le projet européen CORSMAL dans le cadre de programme CHIST-ERA, sujet d’appel : Object recognition and manipulation by robots: Data sharing and experiment reproducibility (ORMR) et a reçu des financements du Engineering and Physical Sciences Research Council (EPSRC-UK), de l’Agence Nationale de la Recherche (ANR), et du Fonds National Suisse de la Recherche Scientifique.

Les partenaires du projet sont :

– Queen Mary University of London – Royaume-Uni, (coordinateur du projet),

– ISIR de Sorbonne Université – France,

– École Polytechnique Fédérale de Lausanne (EPFL) – Suisse.

En savoir plus sur CORSMAL : corsmal.eecs.qmul.ac.uk

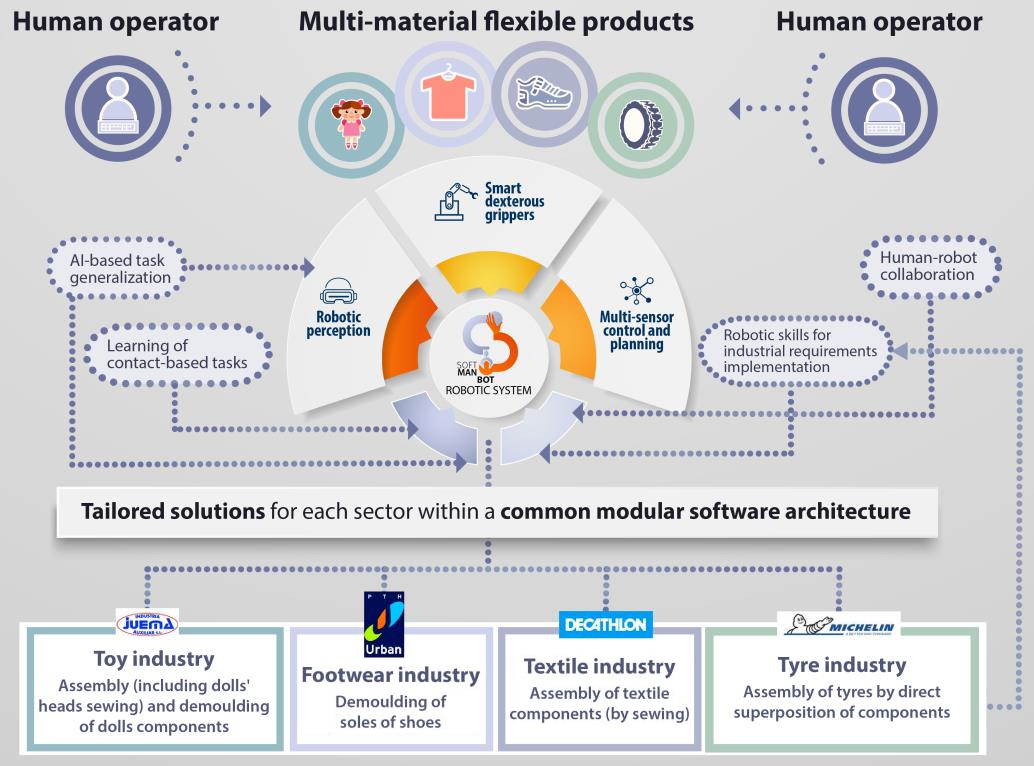

Projet SOFTMANBOT : Technologie robotique avancée pour la manipulation de matériaux mous dans les secteurs de la fabrication

SOFTMANBOT est un projet axé sur l’utilisateur industriel final, qui fournira un système robotique innovant et global pour la manipulation de matériaux souples et déformables, dans le cadre de processus de production à forte intensité de main-d’œuvre.

Le système robotique sera composé de trois éléments principaux :

– un système de perception robotique générique (perception du produit et de l’opérateur humain),

– une plateforme de contrôle et de planification multi-capteurs (algorithmes de contrôle avancés pour l’asservissement de la forme et du contact, généralisation des tâches basée sur l’IA),

– et des pinces agiles intelligentes (conception mécanique intelligente qui incarnera les compétences de préhension/manipulation et intégrera des capteurs – principalement tactiles – pour identifier précisément l’état de contact entre le produit et le préhenseur) capables de manipuler des composants souples avec des niveaux élevés de robustesse et de flexibilité.

Le contexte

Les robots sont employés depuis longtemps dans des applications de l’industrie automobile, depuis leur introduction dans ce secteur au milieu du siècle dernier. Depuis, les solutions robotiques ont été adoptées par de nombreux secteurs et pour des applications diverses comme dans les domaines de l’aéronautique, l’électronique, l’électroménager, l’industrie alimentaire, l’emballage, les machines textiles, etc. Toutefois, l’adoption de solutions robotiques dans les processus industriels reste faible dans un nombre important de secteurs qui pourraient être la cible idéale de ce type de solutions en raison de la nature de leur travail (tâches répétitives, dangereuses, etc.). Ce fait limite le niveau d’automatisation dans ces industries et restreint le potentiel de croissance de ces entreprises, en particulier dans des secteurs déterminés tels que les industries du textile, de la chaussure ou du jouet, qui doivent réduire leurs coûts de production et augmenter leur productivité en raison de la concurrence acharnée à laquelle ils sont confrontés avec des produits provenant d’autres marchés internationaux tels que l’Asie (Chine, Bangladesh, Inde, etc.).

Les objectifs

L’objectif général du projet est de développer et de démontrer une approche innovante et universelle de la manipulation robotique de matériaux flexibles et déformables, basée sur l’intégration de technologies de fabrication avancées pour l’automatisation de tâches basées sur le contact, soutenue par un système de perception robotique intelligent, une plateforme de planification et de contrôle multi-capteurs et le déploiement de préhenseurs intelligents et à dextérité universelle capables de manipuler des composants souples avec des niveaux élevés de robustesse et de flexibilité.

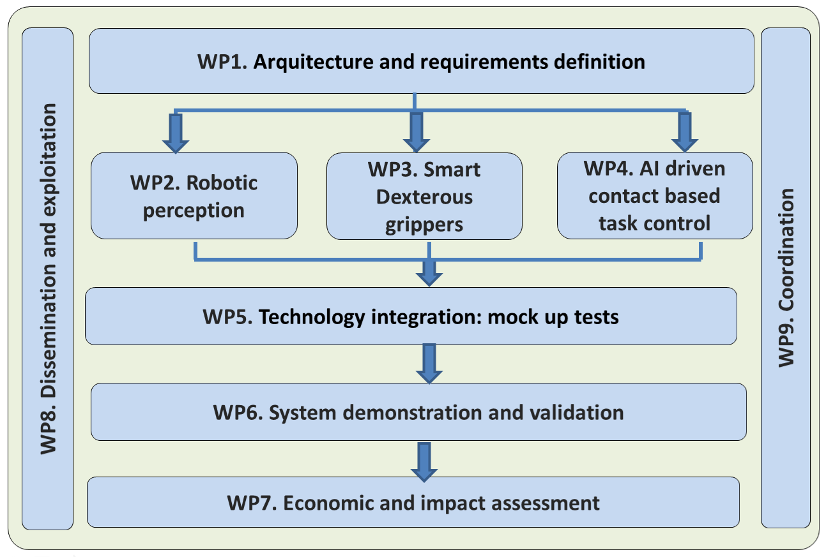

Afin de réaliser l’objectif du projet, le projet SOFTMANBOT se déroulera sur 42 mois avec un plan de travail divisé en 9 Work Packages.

Les résultats

Les résultats attendus sont les suivants :

– Une architecture modulaire et inter-opérable intégrant les différents systèmes et composants matériels et logiciels de la solution robotique SOFTMANBOT ;

– Une plateforme de perception robotique pour la configuration et le suivi en temps réel de la déformation et de l’état de contact de produits flexibles complexes intégrant des stratégies d’apprentissage ;

– Un système de planification et de contrôle multi-capteurs qui, en prenant comme entrées le modèle du produit et le modèle des interactions homme-robot, implémentera les compétences du robot pour gérer la déformation et le contact du produit, établira une séquence d’actions pour réaliser les tâches, définira les sorties requises pour interagir avec l’homme et enfin paramètrera de manière générique les tâches à réaliser ;

– Des préhenseurs intelligents, adroits et peu coûteux pour la manipulation d’objets déformables, intégrant des capteurs (tactiles, de force, de proximité, de vision…) et une structure mécanique intelligente (incarnation des capacités de préhension/manipulation) capables d’exécuter des tâches de manipulation difficiles avec des niveaux élevés de précision, de tolérance aux pannes, de robustesse et de flexibilité dans des environnements difficiles et changeants ;

– Intégration des composants et modules technologiques développés pour la conception de solutions rentables et adaptatives pour des applications industrielles ;

– Validation des résultats du projet de manière rentable dans des conditions industrielles réelles par le biais de 4 démonstrations pilotes dans quatre usines européennes (secteurs du jouet, du textile, de la chaussure et du pneumatique) ;

– Une évaluation environnementale (LCA), économique et sociale de l’ensemble de la solution SOFTMANBOT, y compris une évaluation de l’acceptation par les utilisateurs ;

– Des plans de diffusion, d’exploitation et de communication coordonnés afin de maximiser l’impact technique, social et économique du projet au sein des clusters de démonstration et à travers l’Europe.

Partenariats et collaborations

Ce projet a été financé par le programme de recherche et d’innovation Horizon 2020 de l’Union européenne « Transforming European Industry », sous la convention de subvention nº 869855.

Le consortium est composé de la manière suivante :

– Sigma Clermont, Université Clermont Auvergne – France,

– AIJU Institut Technologique – Espagne,

– INESCOP, Centre de technologie et d’innovation – Espagne,

– Industria Auxiliar Juema – Espagne,

– Sorbonne Université – France,

– Decathlon Produzione Italia – Italie,

– STAM Mastering Excellence – Italie,

– IIT, Institut Italien de Technologie – Italie,

– Zimmer Group – Allemagne,

– PTH URBAN – Espagne,

– Michelin – France.

En savoir plus sur SOFTMANBOT: http://softmanbot.eu/

Projet INDEX: Robot In-hand Dexterous manipulation by extracting data from human manipulation of objects to improve robotic autonomy and dexterity

Le projet InDex vise à comprendre comment les humains manipulent des objets avec leurs mains et reproduire les mouvements observés avec des mains artificielles dextres, en fusionnant les concepts d’apprentissage par renforcement et par transfert pour généraliser les capacités de manipulation pour de multiples objets et tâches. De plus, une abstraction et une représentation des connaissances antérieures seront fondamentales pour la reproductibilité des compétences acquises sur différents matériels. L’apprentissage utilisera des informations provenant de plusieurs modalités qui seront collectées, annotées et assemblées dans un grand ensemble de données. Les données et nos méthodes seront partagées avec la communauté de recherche au sens large afin de permettre des tests par rapport à des points de référence et la reproduction des résultats.

Le contexte

L’être humain excelle lorsqu’il s’agit de manipuler des objets du quotidien, d’apprendre de nouvelles compétences et de s’adapter à des environnements différents ou complexes. Il s’agit de compétences fondamentales pour notre survie et d’une caractéristique essentielle de notre monde d’artefacts et de dispositifs fabriqués par l’homme. Notre capacité à utiliser nos mains est le résultat d’une vie d’apprentissage, à la fois en observant d’autres humains compétents et en découvrant par nous-mêmes comment manipuler des objets. Malheureusement, les mains robotisées d’aujourd’hui sont encore incapables d’atteindre un tel niveau de dextérité par rapport aux humains et les systèmes ne sont pas non plus entièrement capables de comprendre leur propre potentiel.

Les objectifs

Pour que les robots puissent véritablement fonctionner dans un monde humain et répondre aux attentes en tant qu’assistants intelligents, ils doivent être capables de manipuler une grande variété d’objets inconnus en maîtrisant leurs capacités de force, de souplesse et de subtilité. Pour atteindre une telle dextérité avec des mains robotiques, une aptitude cognitive est nécessaire pour faire face aux incertitudes du monde réel et pour généraliser les compétences acquises précédemment à de nouveaux objets et tâches. En outre, nous affirmons que la complexité de la programmation doit être fortement réduite et que l’autonomie des robots doit devenir beaucoup plus naturelle.

Les objectifs principaux sont :

– la construction d’une architecture de perception artificielle multimodale qui extrait des données de manipulation d’objets par des humains,

– la création d’un ensemble de données multimodales de tâches de manipulation avec la main telles que la préhension, la réorientation et le repositionnement fin,

– le développement d’un système avancé de modélisation et de reconnaissance d’objets, comprenant la caractérisation des affordances et des propriétés de préhension des objets, afin de capturer à la fois les informations explicites et les utilisations implicites possibles des objets,

– l’apprentissage autonome et l’imitation précise des stratégies humaines dans les tâches de manipulation,

– et la construction d’un lien entre l’observation et l’exécution, permettant un déploiement indépendant de l’architecture du robot.

Les objectifs de l’équipe de l’ISIR sont de concevoir :

– un planificateur en temps réel pour la saisie et la manipulation robotique,

– une commande de rétroaction optimale pour déterminer les états intermédiaires qui donnent les meilleures performances possibles pour la transition d’un état initial à l’état désiré suivant,

– des contrôleurs multimodaux de bas niveau qui permettent à la main artificielle de manipuler l’objet ciblé en tenant compte du fait que le système robotique a besoin de sources d’information diverses et variées pendant la séquence d’action, ce qui donne lieu à une structure de commande complexe,

– le réglage de la saisie, la tenue d’un objet dans une main exige que les doigts maintiennent fermement l’objet sans aucun glissement et résistent aux perturbations externes liées ; en d’autres termes, la prise doit être stable.

Les résultats

La manipulation robotique de la main est basée sur une combinaison de mouvements primitifs humains. Les mouvements primitifs ont été extraits et testés pour être efficaces dans la reconstitution des trajectoires. Le planificateur de trajectoire en temps réel est en cours de conception et combine les mouvements primitifs sous les contraintes de la manipulation robotique à la main pour générer les trajectoires.

Partenariats et collaborations

Ce travail est soutenu par le projet européen InDex dans le cadre du programme CHIST-ERA, sujet d’appel « Object recognition and manipulation by robots: Data sharing and experiment reproducibility (ORMR) ». Le projet a reçu un financement du Ministère italien de l’éducation et de la recherche (MIUR), du Fonds scientifique autrichien (FWF) sous la convention de subvention n° I3969-N30, de l’Engineering and Physical Sciences Research Council (EPSRC-UK) sous la référence EP/S032355/1 et de l’Agence Nationale de la Recherche (ANR) sous la convention de subvention n° ANR-18-CHR3-0004.

Les partenaires du projets sont :

– Université Aston – Royaume-Uni (coordinateur),

– Université Technique de Vienne – Autriche,

– Université de Tartu – Estonie,

– Sorbonne Université – France,

– Université of Gênes – Italie.

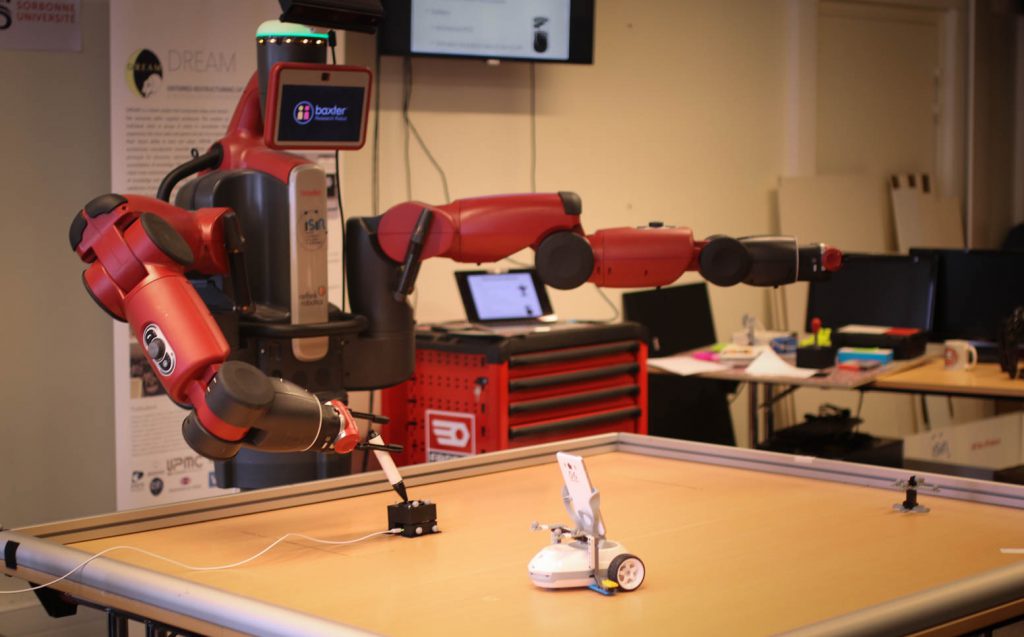

La robotique représente un défi pour les méthodes d’apprentissage car elle combine les difficultés suivantes : espaces d’état et d’action de grande dimension et continus, récompenses rares, monde dynamique, ouvert et partiellement observable avec des perceptions et des actions bruitées. Leur mise en œuvre est donc délicate et nécessite une analyse poussée des tâches à accomplir, ce qui réduit leur potentiel d’application. Dans le projet Européen DREAM, nous avons défini les bases d’une approche développementale permettant de combiner différentes méthodes pour réduire ces contraintes et donc augmenter les capacités d’adaptation des robots par le biais de l’apprentissage.

Le contexte

La conception de robots nécessite d’anticiper toutes les conditions auxquelles ils peuvent être confrontés et de prévoir les comportements appropriés. Une situation imprévue peut donc provoquer un dysfonctionnement susceptible de se reproduire si les mêmes conditions surviennent de nouveau. Ce manque d’adaptation est un frein à de nombreuses applications de la robotique, en particulier lorsqu’elles ciblent un environnement non contrôlé comme notre environnement quotidien (pour des robots compagnons, par exemple) ou plus généralement pour des robots collaboratifs, c’est-à-dire agissant au contact d’humains. Les méthodes d’apprentissage artificiel pourraient aider à rendre les robots plus adaptatifs, si toutefois elles parviennent à surmonter les multiples difficultés liées au contexte de la robotique. Ce sont ces difficultés spécifiques que ce projet se propose d’aborder.

Les objectifs

L’objectif du projet est d’aider à concevoir des robots en interaction avec un environnement non contrôlé, sur des tâches pour lesquelles le comportement désiré est partiellement connu ou même totalement inconnu.

Dans ce contexte, l’apprentissage permet de laisser le robot explorer son environnement en autonomie, afin d’en extraire des représentations sensorielles, sensori-motrices ou purement motrices pertinentes. Par exemple, apprendre à reconnaître des objets, identifier sont ceux qui sont manipulables, apprendre à les saisir, les pousser, les jeter, etc. Explorer le vaste espace sensori-moteur de manière pertinente est central, d’autant plus que nombre d’interactions sont rares (la probabilité d’attraper un objet avec un mouvement purement aléatoire est quasiment nulle).

Nous nous intéressons donc à la construction de ces représentations et nous appuyons sur une approche modulaire et itérative visant à explorer les capacités du robot et à en déduire des représentations qui faciliteront la résolution des tâches qui se présentent, que ce soit avec des méthodes de planification ou d’apprentissage.

Les résultats

La création de représentations d’états et d’actions susceptibles de servir ultérieurement nécessite dans un premier temps de générer des comportements pertinents par rapport aux capacités du robot. Un comportement est pertinent s’il met en avant la capacité du robot à obtenir un effet particulier en interagissant avec son environnement. Sachant que beaucoup de mouvements du robot ne créent aucun effet, découvrir les effets que le robot est susceptible de générer est difficile. A cela s’ajoute la difficulté d’explorer pour apprendre des comportements sans disposer de représentations appropriées.

Nous nous appuyons donc sur des algorithmes d’exploration basés notamment sur de la recherche de nouveauté et des algorithmes de Qualité-Diversité pour générer des comportements d’exploration en grande quantité et en déduire des espace d’état et d’action appropriés pour des apprentissages ultérieurs.

Partenariats et collaborations

Le projet Européen DREAM, coordonné par Sorbonne Université (FET H2020 2015-2018), a lancé cette thématique de recherche au laboratoire (http://dream.isir.upmc.fr/).

Son consortium était composé de :

– l’ENSTA-ParisTech, en France,

– Sorbonne Université, en France,

– l’Université de la Corogne, en Espagne,

– l’Université d’Édimbourg au Royaume-Uni,

– la Vrije Universiteit Amsterdam au Pays-Bas.

Il s’agissait d’un projet académique, sans partenaire industriel.

Elle se poursuit dans le cadre de plusieurs projets visant à appliquer ces travaux à un contexte industriel. La capacité d’adaptation de l’apprentissage est destinée à aider les ingénieurs dans la phase de conception et de mise à jour du comportement d’un robot. Le projet Européen SoftManBot (http://softmanbot.eu) vise des applications à la manipulation d’objets déformables. Il dispose d’un consortium de 11 partenaires, notamment SIGMA, à Clermont-Ferrand, l’IIT à Gênes et des entreprises comme Decathlon et Michelin. Le projet VeriDREAM (https://veridream.eu/), en collaboration avec le DLR, l’ENSTA-Paristech, Magazino GmbH, Synesis et GoodAI, vise à faciliter le transfert de ces méthodes dans un contexte industriel plus large, incluant en particulier des petites et moyennes entreprises avec un focus sur les secteurs de la logistique et du jeu vidéo.