Projet MAPTICS : Développement d’un cadre multisensoriel pour l’haptique

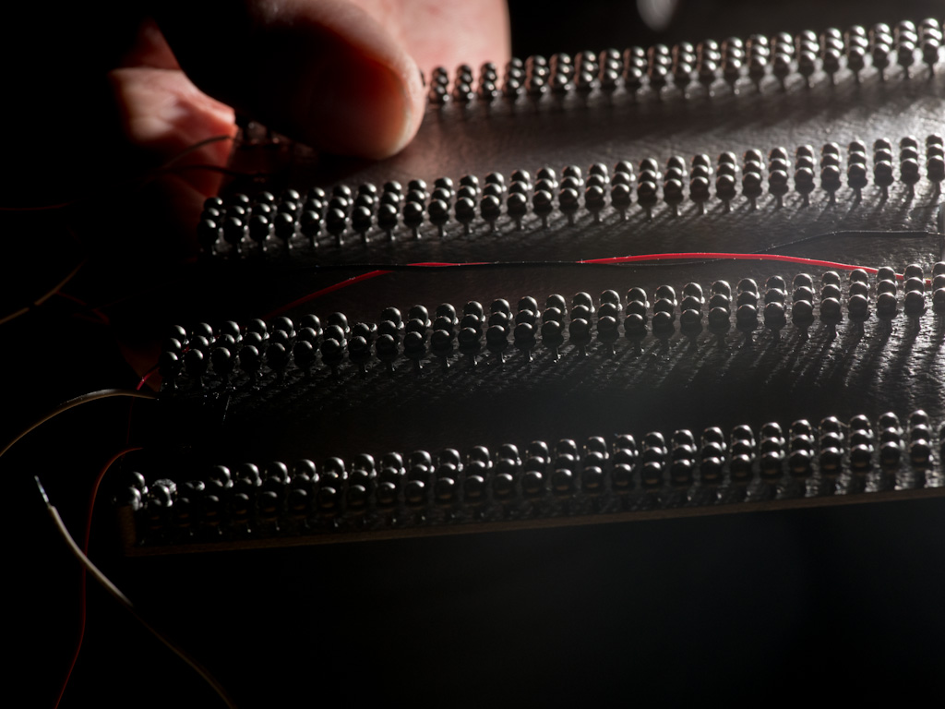

Le projet MAPTICS vise à développer un nouveau cadre haptique multimodal en caractérisant la façon dont les utilisateurs et utilisatrices intègrent les indices multisensoriels dans une perception unifiée et quelles facettes du toucher sont les plus essentielles à reproduire dans les applications virtuelles et numériques.

Dans ce but, il étudie le potentiel du rendu vibro-frictionnel et du renforcement multisensoriel pour créer l’illusion d’objets en 3D sur l’écran d’une nouvelle interface haptique multimodale et explore la manière dont l’haptique peut être intégrée dans la prochaine génération d’interfaces multisensorielles qui combinent un retour d’information tactile, auditif et visuel haute-fidélité. Cette recherche permettra finalement de créer et d’évaluer de nouvelles applications multimodales d’IHM pour les utilisateurs-utilisatrices classiques ainsi que ceux souffrant de déficiences sensorielles.

Le contexte

Les interfaces actuelles des IHM fournissent généralement un retour d’information visuel et auditif de haute résolution. En revanche, le retour haptique est souvent absent des écrans, malgré des produits commerciaux récents tels que le moteur Taptic sur les smartphones haut de gamme d’Apple. Bien que l’interaction multimodale ait le potentiel d’améliorer l’acceptabilité, l’efficacité de l’interaction et d’être plus inclusive pour les personnes souffrant de déficiences sensorielles, son développement est entravé par l’absence de cadre multisensoriel pour intégrer le retour haptique aux signaux audiovisuels, ainsi que par la faible fidélité de l’haptique par rapport à la vision et à l’audition dans les affichages.

Par conséquent, l’avenir du retour d’information multisensoriel est confronté aux défis de la conception d’un retour d’information haptique haute-fidélité et de l’utilisation efficace des principes cognitifs qui sous-tendent la perception multisensorielle. Dans ce contexte, de nouvelles stratégies de rendu et des dispositifs plus performants qui intègrent un retour haptique riche au rendu audiovisuel haute résolution sont de plus en plus envisagés.

Les objectifs

– Développer un écran interactif capable de fournir un retour haptique vibrotactile combiné avec un retour d’effort, ainsi que des capacités audiovisuelles à haute résolution. Le défi consiste à créer une interface tactile active offrant un retour d’information plus riche que les dispositifs scientifiques et commerciaux actuels.

– Développer un cadre versatile pour le rendu multisensoriel et l’utiliser pour comprendre les processus cognitifs en jeu lors du traitement des données multisensorielles. Pour ce faire, nous utilisons la plateforme multisensorielle développée dans MAPTICS pour manipuler la congruence entre les entrées sensorielles auditives, visuelles et tactiles dans le but d’étudier le renforcement ou la perturbation des représentations cognitives.

– Nous nous appuyons sur les deux sous-objectifs précédents pour construire une interface utilisateur-utilisatrice avec un retour haptique multisensoriel renforcé à haute résolution. Avec cette nouvelle interface, nous étudierons des scénarios liés à la navigation dans des cartes interactives multisensorielles ou à l’utilisation de boutons virtuels.

Les résultats

La stimulation vibrotactile et la lubrification ultrasonique simultanées n’ont pas encore été étudiées, bien qu’elles puissent potentiellement lever de sérieuses limitations technologiques actuelle, telles que : l’incapacité des vibrations ultrasoniques à fournir un retour d’information convaincant lorsque le geste de l’utilisateur ou l’utilisatrice n’implique pas de mouvement du doigt, ou la difficulté de créer des formes virtuelles avec des vibrations mécaniques.

Une meilleure compréhension de la mise en œuvre conjointe des deux types de retour d’information permettra de créer des dispositifs haptiques plus efficaces et plus convaincants. Par ailleurs, le rendu haptique vibrotactile et le rendu haptique par friction sont actuellement des sujets de recherche distincts.

Après Maptics, nous espérons que la recherche haptique étudie de plus en plus ces deux techniques complémentaires afin de développer efficacement un rendu tactile plus intégré. En outre, le projet fournira un nouvel outil expérimental multisensoriel qui permettra une étude et une compréhension plus poussées des mécanismes sous-jacents de l’intégration sensorielle.

Partenariats et collaborations

Le projet MAPTICS est un projet ANR (Agence nationale de la recherche), mené en partenariat avec Betty Lemaire-Semail du laboratoire L2Ep de l’Université de Lille.

Projet Open A-Eye : Le retour kinesthésique pour guider les personnes malvoyantes

L’originalité du dispositif de l’équipe A-Eye est de fournir un guidage kinesthésique qui se veut plus intuitif que les retours audio et/ou vibrants proposés dans les solutions du commerce. Cela permet de réduire la charge cognitive nécessaire pour suivre les informations. Ce dispositif, les réglages fins de la rétroaction qu’il propose ainsi que toutes les autres solutions permettant de répondre aux différents challenges du Cybathlon* ont été co-conçus avec l’aide de notre « pilote ». L’équipe A-Eye place en effet la co-création au cœur du processus, travaillant avec des associations, des experts en accessibilité et la pilote aveugle d’A-Eye. L’objectif est de créer une solution ergonomique, accessible, facile à utiliser et adaptée à la vie quotidienne.

Le dispositif de l’équipe A-Eye intègre des technologies de pointe, combinant le retour kinesthésique intuitif à des fonctionnalités de vision par ordinateur et d’intelligence artificielle. Le dispositif portable, sous forme d’un harnais/sac à dos offre une navigation précise, mimant l’interaction avec un guide humain et offrant ainsi une expérience intuitive.

*Le Cybathlon est un évènement qui a lieu tous les 4 ans et organisé par l’École polytechnique fédérale de Zurich qui met au défi des équipes du monde entier autour de 8 épreuves. L’objectif est de démontrer les progrès technologiques d’assistance dans l’accomplissement des tâches de la vie quotidienne de personnes en situation d’handicap.

Le contexte

Il est connu que le guidage le moins fatiguant dans un environnement nouveau est celui fourni par une personne formée aux techniques de guide. Ce guidage est bien plus intuitif et nécessite ainsi beaucoup moins de concentration qu’une déambulation avec un dispositif classique d’assistance comme la canne blanche.

Un environnement nouveau suppose des obstacles difficilement prévisibles (notamment ceux à hauteur de tête) et une trajectoire à préparer à l’avance. Cela a pour effet de demander une surcharge cognitive importante. Dans cette situation, une assistance numérique capable de capter l’environnement, de calculer une trajectoire et de fournir une information intuitive (information positive) sur la direction à suivre serait beaucoup plus simple à intégrer qu’une solution qui indique seulement les obstacles (information négative), comme c’est le cas des cannes blanches même celles dites « intelligentes ». L’information intuitive pourrait mimer les informations de forces et mouvements échangées entre guidant et guidé. Nous appelons ce type d’informations des informations kinesthésiques.

Notre expertise sur le sujet prend plusieurs formes :

– En tant que roboticien, nous avons noté que les technologies utilisées pour la détection d’obstacles et la planification de trajectoire pour les robots autonomes pourraient trouver un écho positif dans l’élaboration d’un dispositif d’assistance ;

– D’autre part, l’ISIR et ses activités spécifiques s’intéressent justement aux bonnes pratiques et à l’élaboration de nouveaux dispositifs permettant d’augmenter/substituer de l’information sensorielle dans différents cadres d’application (assistance/rééducation/chirurgie).

Les objectifs

Nous avions pour ambition de concevoir un dispositif d’une intuitivité optimale. Ainsi, le dispositif de l’équipe A-Eye a été créé avec une série d’objectifs convergents :

– exploiter le contexte offert par la compétition internationale du Cybathlon pour valider l’efficacité des retours sensoriels élaborés au sein de nos équipes,

– et tirer parti des compétences des étudiants de nos formations afin de mettre en évidence tout le potentiel de ces dernières.

Le dispositif se présente sous la forme d’un harnais/plastron sur lequel est fixé un système de retour kinesthésique (pantographe), avec une caméra 3D. Il possède aussi un ordinateur puissant permettant d’analyser/cartographier l’environnement avant de proposer une trajectoire permettant d’atteindre la position désirée tout en actualisant cette dernière en fonction de l’apparition de nouveaux obstacles. Le retour kinesthésique permet d’appliquer un effort dans deux directions (gauche/droite et avant/arrière), ce qui permet d’indiquer la direction à suivre de manière intuitive.

Ce dispositif représente une solution innovante à la frontière des technologies et des logiciels actuels développés en robotique, en traitement d’image, en intelligence artificielle et en communication haptique/kinesthésique.

Les résultats

Le dispositif développé à l’ISIR a atteint un niveau de maturité suffisant, permettant désormais une utilisation autonome par la pilote, avec la capacité de changer de mode en fonction des défis rencontrés.

Les séances d’entraînement hebdomadaires de la pilote, Salomé Nashed, malvoyante depuis sa naissance est chercheuse en biologie, permet d’affiner et de personnaliser le guidage pour s’adapter aux différentes épreuves du Cybathlon. Bien qu’elle qualifie le retour d’ « intuitif », il devient essentiel de l’éprouver auprès d’un plus large panel d’utilisateurs et utilisatrices afin de continuer à améliorer la solution et d’en renforcer les possibilités de personnalisation. Parallèlement, présenter le dispositif permettra de sensibiliser aux avancées technologiques actuelles, en montrant à la fois leur potentiel et leurs limites. Le partenariat avec l’INJA (Institut National des Jeunes Aveugles) Louis Braille permettra ainsi de présenter le dispositif aux élèves mais aussi aux instructeurs en mobilités.

La mission principale sera de rendre le dispositif existant open-source. Nous détaillons ici la démarche envisagée pour atteindre cet objectif :

– La documentation et la maintenance d’un GIT accessible en open source,

– Le bilan et l’optimisation des choix de matériaux et de quincailleries,

– L’élaboration de plans pour l’impression 3D et la découpe laser,

– La création de tutoriels vidéo,

– Tout le long du développement, nous recueillerons les retours des utilisateurs « techniques »:

(1) Prendre en compte les retours d’un groupe d’étudiants utilisateurs du fablab de Sorbonne Université qui auront à reproduire le dispositif à partir de la documentation disponible,

(2) Prendre en compte les retours des instructeurs en locomotion de l’INJA Louis Braille, premiers testeurs du dispositif en tant qu’équipe technique nouvellement formée. Leur rôle sera de s’approprier le dispositif et de proposer des personnalisations adapt.es aux utilisateurs, afin d’améliorer son ergonomie de mieux répondre aux besoins et aux difficultés spécifiques de chaque usager.

Au-delà de l’ouverture du dispositif actuel, le projet vise aussi à évaluer et développer des solutions plus en connections avec les personnes concernées. Ainsi des contacts ont été pris avec l’INJA Louis Braille pour avoir l’occasion de travaux d’innovations participatives. Ce projet s’effectue également avec le FabLab de Sorbonne Université. Ce projet sera par ailleurs l’occasion d’organiser des groupes de discussion et idéations entre les chercheurs-chercheuses, les étudiants-étudiantes de nos formations à Sorbonne Université, et des jeunes aveugles et personnes déficientes visuels. Ces animations seront portées par le projet pour développer des briques technologiques adaptés aux personnes concernées.

Partenariats et collaborations

L’équipe A-Eye a été fondé par Ludovic Saint-Bauzel et Fabien Vérité, chercheurs à l’ISIR et maîtres de conférences à Sorbonne Université. L’ingénieur en charge du projet est Axel Lansiaux, avec l’aide d’Aline Baudry et de Samuel Hadjes, ingénieur·e·s à l’ISIR. De nombreux étudiant·e·s des masters de Sorbonne université, des spécialités Main et ROB de l’école Polytech Sorbonne, ont participé au projet dans le cadre de leur projet de fin d’étude. Ce projet concerne aussi d’autres collègues à l’ISIR comme Nicolas Baskiotis et Olivier S. (Machine Learning), Nizar Ouarti (Perception) qui sont intéressés d’apporter leurs expertises à ce projet opensource.

Lien vers le site internet de l’équipe A-Eye : https://a-eye.isir.upmc.fr

Projet « Intégration multi-sensorielle pour le maintien de l’équilibre »

Le contexte

Le maintien de l’équilibre nécessite l’intégration d’informations venant des différents systèmes sensoriels : visuels, vestibulaires, proprioceptifs et haptiques. Ces différents sens sont typiquement étudiés un par un, ce qui laisse ouverte la question de leur intégration. L’équipe IRIS de l’ISIR regroupe des experts et expertes sur le contrôle postural, l’haptique et l’adaptation visio-motrice.

Les objectifs

L’objectif est de combiner ces expertises pour étudier l’intégration multi-sensorielle pendant des perturbations de l’équilibre, en combinant des perturbations :

– mécaniques (via une plateforme de perturbation),

– visuelles (en réalité virtuelle),

– et haptiques (avec un dispositif de « light touch » et des dispositifs de stimulation haptique).

Partenariats et collaboration

Le projet « Intégration multi-sensorielle pour le maintien de l’équilibre » est un projet fédérateur, interne à l’ISIR, qui n’implique pas de collaboration extérieure au laboratoire.

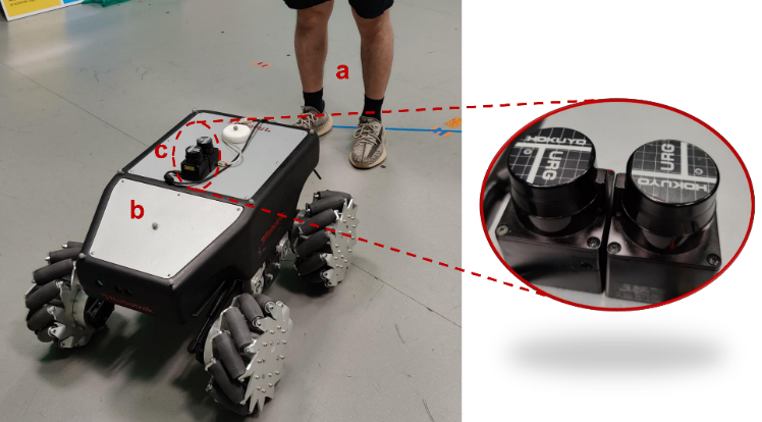

Projet FHF : A Frontal Human Following technology for mobile robots

Les robots suivant les humains sont une fonction efficace et pratique, en particulier dans le contexte de la robotique de service. Cependant, la majorité des recherches existantes se sont concentrées sur le suivi derrière un humain, avec relativement peu d’attention accordée au robot opérant devant l’humain. Ce projet de suivi frontal, où le robot reste dans le champ de vision de l’utilisateur, est plus rassurant et facilite l’interaction. De nouveaux défis se présenteront lors de la mise au point d’un tracker capable d’estimer la pose d’un utilisateur à partir d’un LiDAR 2D à hauteur de genou, en particulier lorsque les jambes sont souvent masquées l’une par l’autre. Il est également nécessaire d’assurer la sécurité de l’utilisateur tout en se demandant comment le robot peut suivre l’utilisateur dans les situations où le robot serait en retard.

Le contexte

Les robots mobiles sont de plus en plus omniprésents dans divers environnements, tels que les centres commerciaux, les hôpitaux, les entrepôts et les usines. Nombre de tâches dans ces applications sont partagées entre les robots et les opérateurs humains par la voix, la vidéo, l’interaction par la force, etc., soit parce que l’expertise ou l’agilité humaine inhérente est requise pour certaines tâches, soit parce que le robot peut fournir une assistance potentielle à l’opérateur. Dans ce projet, nous nous concentrons sur l’étude du suivi automatique de l’utilisateur par le robot mobile basé sur le LiDAR 2D. Les algorithmes communs de suivi à l’arrière maintiennent le robot à une distance de l’utilisateur. Certaines études ont montré que les gens préfèrent voir les robots dans leur champ de vision, et peuvent se sentir mal à l’aise et en danger lorsque les robots apparaissent derrière eux. En outre, les services spécifiques exigent que les robots se présentent devant les utilisateurs. Par exemple, les robots d’assistance agissent comme des chiens d’aveugle pour fournir une aide à la navigation aux malvoyants. Par conséquent, le suivi frontal devient progressivement populaire.

Les objectifs

Les objectifs scientifiques de ce projet sont les suivants :

– Construire un tracker de pose humaine (orientation et position) basé sur le LiDAR 2D à hauteur du genou pour les robots mobiles en étudiant la marche humaine ;

– Collecter des scans LiDAR de différents volontaires ainsi que des données de vérité terrain sur l’orientation humaine afin de construire un modèle basé sur les données pour améliorer l’estimation de l’orientation humaine ;

– Résoudre le problème des jambes se cachant l’une et l’autre lors du balayage en modélisant la marche ou en utilisant des techniques d’apprentissage automatique ;

– Développer un générateur de mouvement permettant au robot de se déplacer devant l’utilisateur en toute sécurité et de manière naturelle.

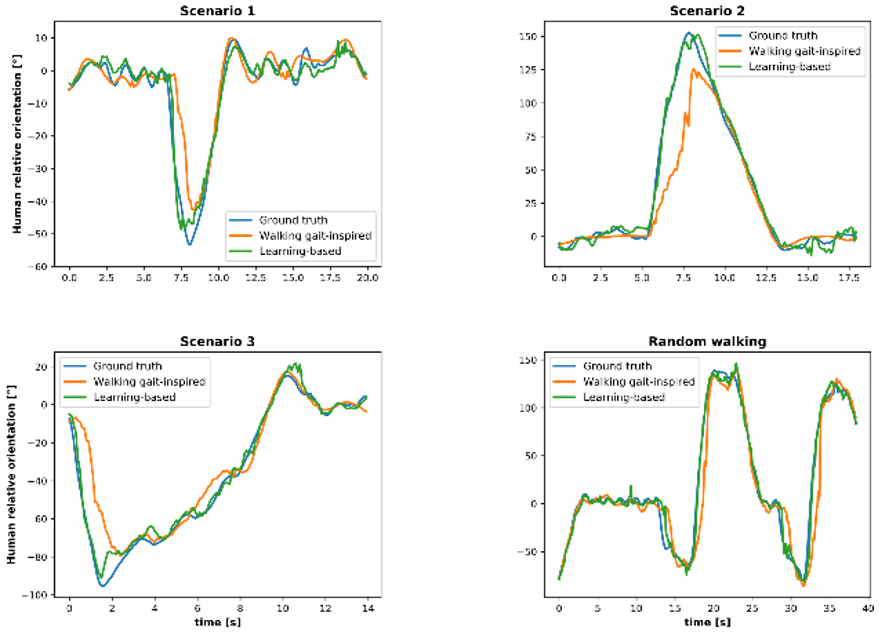

Les résultats

Douze volontaires (trois femmes et neuf hommes) ont été invités à participer à l’expérience de suivi frontal, et le tracker de posture humaine basé sur la marche humaine a montré de bonnes performances. Les analyses quantitatives ont révélé que l’erreur absolue moyenne (MAE) de position était d’environ 4 cm et que la MAE d’orientation était inférieure à 12 degrés pour la marche complexe.

Les données collectées pendant six heures sur cinq volontaires (une femme et quatre hommes) ont été utilisées pour construire des modèles permettant d’améliorer l’estimation de l’orientation. Grâce à la résolution du problème de retard, le modèle personnalisé a permis d’obtenir une MAE de 4 à 7 degrés pour les cinq volontaires.

Le générateur de mouvement à suivi frontal permet au robot de venir naturellement devant l’utilisateur, toujours à une distance de sécurité d’un mètre au cours de l’expérience. Voir la vidéo pour plus de détails.

Publications

– 2D LiDAR-Based Human Pose Tracking for a Mobile Robot, ICINCO 2023,

– Human Orientation Estimation from 2D Point Clouds Using Deep Neural Networks in Robotic Following Tasks, soumis à IROS 2024,

– Large Workspace Frontal Human Following for Mobile Robots Utilizing 2D LiDAR, soumis à JIRS.

Projet NeuroHCI – Prise de décisions multi-échelle avec les systèmes interactifs

Ce projet pluridisciplinaire s’appuie sur les Neurosciences Computationnelles pour développer des modèles IHM du comportement utilisateur-utilisatrice. Il s’agit d’étudier dans quelle mesure on peut transposer les théories, modèles et méthodes des Neurosciences Computationnelles à l’IHM.

Le projet NeuroHCI vise à améliorer la prise de décision humaine dans les mondes physique et numérique dans des contextes interactifs. Les situations dans lesquelles un humain prend une décision avec un système interactif sont variées :

Est-ce que j’utilise mon expérience ou Google Maps pour choisir mon itinéraire ? Est-ce que je réponds à cet e-mail sur mon smartphone ou sur mon PC ? Est-ce que j’utilise des menus ou des raccourcis pour sélectionner cette commande fréquente ? Est-ce que j’utilise le robot chirurgical Da Vinci pour opérer mon patient ou les instruments laparoscopiques traditionnels ? Comment puis-je atteindre cet objet avec ma prothèse robotique ?

La décision peut porter sur un choix complexe dans le monde réel assisté par un ordinateur (par exemple, un traitement médical) ou sur le choix d’une méthode pour réaliser une tâche numérique (par exemple, modifier une photo avec l’outil préféré).

Le contexte

Les neurosciences étudient les phénomènes impliquant à la fois la prise de décision et l’apprentissage chez les humains, mais ont reçu peu d’attention en IHM.

Le projet NeuroHCI est un projet en interaction humain-machine (IHM) qui vise à concevoir des systèmes interactifs développant l’expertise de l’utilisateur-utilisatrice en établissant un partenariat humain-machine. L’interaction avec ces systèmes peut être vue comme un problème de prise de décision à plusieurs échelles :

– Une tâche, par exemple choisir le bon traitement médical sur la base de recommandations basées sur l’IA ;

– Une méthode, par exemple choisir parmi différents dispositifs ou modalités pour réaliser une tâche ;

– Un objet, par exemple avec quel objet physique ou virtuel les utilisateurs-utilisatrices vont interagir ;

– Un mouvement, par exemple quelle trajectoire pour atteindre l’objet cible.

Les objectifs

L’objectif scientifique est de comprendre comment les utilisateurs-utilisatrices prennent des décisions avec des systèmes interactifs et comment ces décisions évoluent dans le temps. En effet, les utilisateurs-utilisatrices développent progressivement une expertise au cours de l’utilisation répétée des systèmes interactifs. Cette expertise influence la façon dont ils/elles prennent leurs décisions. Cela nécessite l’étude simultanée des phénomènes d’apprentissage et de prise de décision qui sous-tendent l’utilisation des systèmes interactifs.

L’objectif applicatif est de concevoir et de mettre en œuvre de meilleurs systèmes interactifs et adaptatifs. L’être humain s’adapte et développe son expertise en utilisant un système interactif. L’objectif ici est que le système, de son côté, évolue également pour s’adapter à ses utilisateurs-utilisatrices, c’est-à-dire qu’il s’habitue à leur comportement et en particulier à leur expertise. Il s’agit donc d’établir un partenariat humain-machine dans lequel les deux acteurs (humain et machine) s’adaptent l’un à l’autre.

Les résultats

Pour atteindre ces objectifs, nous démontrons les avantages de notre approche à travers 3 applications, pour lesquelles des plateformes existent déjà et sont maintenues par les partenaires, mais où des défis scientifiques demeurent pour leur adoption dans le monde réel. Ces trois applications sont :

– les interfaces graphiques intelligentes comme les systèmes de recommandation basés sur l’IA ;

– les systèmes de simulation immersifs offrant un riche retour haptique ;

– et les interfaces cobotiques médicales qui visent à restaurer ou à améliorer la capacité des humains à interagir avec des objets dans le monde réel.

Notre hypothèse de recherche est qu’il est nécessaire de développer des modèles computationnels robustes d’apprentissage et de prise de décision en IHM. Les modèles computationnels permettent d’expliquer et de prédire le comportement humain en synthétisant des phénomènes complexes de manière testable et réfutable. En IHM, ils servent à évaluer la qualité d’une interface sans avoir à mener des études d’utilisateurs-utilisatrices longues et coûteuses. Lorsque ces modèles sont robustes, ils peuvent être intégrés dans des systèmes interactifs pour optimiser l’interaction et adapter l’interface en fonction de l’expertise et/ou des actions des utilisateurs-utilisatrices.

Partenariats et collaborations

Porté par Gilles Bailly, directeur de recherche CNRS à l’ISIR, le projet ANR NeuroHCI est un projet inter-équipes interne à l’ISIR, qui implique plusieurs membres du laboratoire.

Projet « Le langage et sa sémantique »

Le contexte

Ce groupe de travail s’intéresse aux différentes formes de langage (texte écrit et langage oral, parole et signaux sociaux, geste, visage, etc.) ainsi qu’à la notion de sémantique qui en découle. A l’intersection entre le traitement automatique du langage, la perception, les sciences cognitives et la robotique, le langage soulève de nombreux enjeux dérivant de l’analyse à la génération, que ce soit dans un contexte individuel ou interactif.

Voici une liste non exhaustive d’exemples d’applications tirées de nos domaines de recherche :

– Prise en compte des hésitations, du rire et autres signaux sociaux

– Lien parole et comportements non verbaux ;

– Dialogues contextualisés (historique, tâche, interaction) / Systèmes de questions-réponses ;

– Synthèse textuelle d’information et d’interaction ;

– Recommandation et recherche d’information ;

– Analyse et représentation de la sémantique ;

– Variation de style ou de contenu.

Les objectifs

L’objectif de ce groupe est de rassembler des chercheuses et chercheurs ayant des expertises différentes autour du langage. A ce jour, les activités mises en place sont essentiellement des groupes de discussion ou présentation scientifiques dans l’objectif de faire émerger des centres d’intérêts communs.

Sur le long terme, un des enjeux sera de mettre en place des co-supervisions de stagiaires et/ou doctorantes et doctorants autour de cette thématique ou des mini-projets scientifiques.

Partenariats et collaboration

Le projet « Le langage et sa sémantique » est un projet fédérateur, interne à l’ISIR, qui n’implique pas de collaboration extérieure au laboratoire.

Contact du projet : projet-federateur-langage(at)listes.isir.upmc.fr

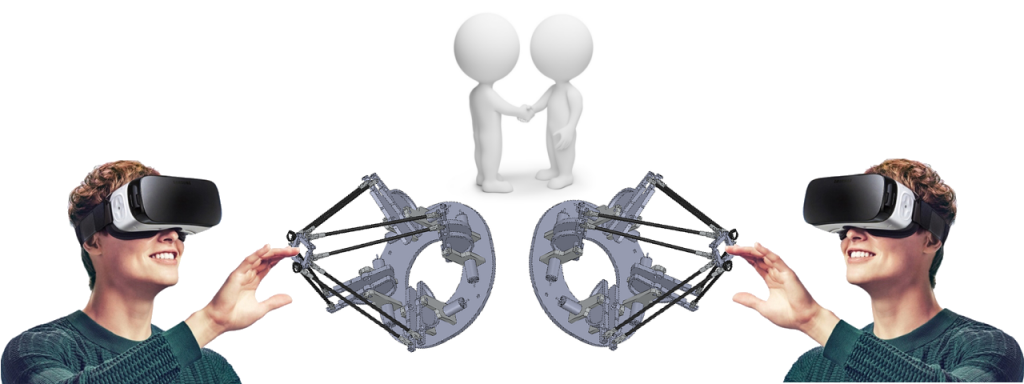

Projet WAVY – Wearable hAptics for Virtual realitY

Le projet WAVY vise à concevoir un dispositif haptique portable de pointe pour la réalité virtuelle, en mettant l’accent sur les illusions sensorielles et en le rendant accessible au public. Il se positionne par rapport à trois principaux domaines de recherche :

– les dispositifs haptiques portables et en particulier kinesthésiques ;

– les illusions de perception sensorielle ;

– et les cadres permettant de concevoir facilement des retours haptiques pour la réalité virtuelle et les processus créatifs.

Le contexte

La réalité virtuelle (RV) a longtemps été réservée au monde universitaire et à l’industrie. Aujourd’hui, elle s’infiltre dans l’éducation, le tourisme, l’art, la thérapie et bien d’autres domaines encore. La réalité virtuelle a suscité un intérêt croissant ces dernières années sur le marché grand public, grâce à l’impact de progrès technologiques au niveau des casques, des contrôleurs et des rendus visuels et audio. Cependant, une expérience réalité virtuelle vraiment réussie et complète repose sur l’exploitation de toutes les modalités sensorielles et sur l’illusion donnée à l’utilisateur qu’il évolue dans un monde réaliste. À cet effet, un retour haptique convaincant, qui permet de ressentir des sensations pendant l’interaction, fait cruellement défaut.

Les objectifs

Les objectifs du projet WAVY sont :

– étudier la combinaison d’illusions perceptuelles multisensorielles et de retours haptiques (vibrations, pression cutanée, retour kinesthésique) pour améliorer l’expérience globale en termes de présence, d’émotion, de qualité du retour, etc. ;

– concevoir un dispositif haptique porté sur la main pour la réalité virtuelle, léger, compact et abordable qui fournit un retour kinesthésique, vibrotactile et de pression cutanée ;

– poursuivre la recherche sur le processus de création haptique et le développement d’un framework pour « l’haptique générique » ; il s’agit de faciliter la conception de retours haptiques pour la RV quel que soit le dispositif utilisé et ses capacités, pour des personnes qui n’ont pas forcément une grande expertise en haptique.

Les résultats

Le résultat attendu est un dispositif avec une large gamme de retours (vibrations, pression cutanée, retour résistif) associé à une solution logicielle pour la création des interactions haptiques et des illusions sensorielles. L’objectif est que cet outil logiciel soit accessible et puisse servir à développer des applications réalité virtuelle via les cas d’usages artistiques et industriels.

Partenariats et collaborations

Ce projet implique l’ISIR dans le cadre d’un partenariat avec Sorbonne Université dirigé par David Gueorguiev, Chargé de recherches au CNRS. Le consortium est composé de la manière suivante :

– Le Laboratoire des Interfaces Sensorielles et Ambiantes – CEA List (coordinateur du projet),

– l’ISIR – Sorbonne Université,

– la start-up GoTouch VR,

– l’Atelier Arts Sciences, plateforme commune de recherche et de création partagée avec le CEA Grenoble.

Projet Lexikhum : Communication Kinesthesique Humain-Machine

Le but de ce projet est de construire un lexique d’unités de sens kinesthésiques qui permettraient d’aborder l’interaction physique homme-robot comme une phrase combinant ces unités de sens. L’émergence de ces unités de sens est étudié dans des interactions humain-humain et le projet est d’en extraire les parties programmables en faisant des modèles computationnels pour construire des partenaires virtuels, capable de produire une interaction aussi naturelle qu’avec un humain. Ses unités de sens visent à être développées et étudiées par une équipe pluridisciplinaire composée de chercheures et chercheurs qui placent le caractère cognitif de cette interaction au cœur de leur recherches. La quantification de la qualité des interactions humain-humain et humain-partenaire virtuel est un apport espéré de ce projet, car il donnera une base d’unités avec une connaissance précise de son caractère vraisemblable et de sa compréhensibilité lorsque cela vient d’un humain et lorsque cela vient d’un partenaire virtuel.

Le contexte

L’automatisation au cœur de notre quotidien – Les mutations technologiques à l’œuvre dans les systèmes complexes (comme en aéronautique) ont profondément modifié l’interaction entre l’humain et la machine. Au fil de cette évolution, les opératrices et opérateurs se sont retrouvés face à des systèmes de plus en plus complexes et de plus en plus automatisés. Si le public a bien souvent été fasciné par l’ingéniosité de tels systèmes, de nombreuses tragédies plus ou moins récentes montrent à quel point l’interaction entre l’humain et les automatismes reste un problème sensible. Ainsi, de nombreux travaux soulignent les conséquences négatives en matière de sécurité et de performance d’une automatisation des systèmes : difficultés pour détecter les erreurs ou pannes du système (Kessel & Wickens, 1982), pour comprendre son état courant (Sarter, Woods, & Billings, 1997) et pour déterminer les actions appropriées pour la suite de la tâche (Endsley, 1999). Ces difficultés d’interaction entre l’humain et l’automatisme constituent un enjeu de recherche majeur. Ce projet a pour ambition de participer à la compréhension et la compensation de ces difficultés d’interaction entre l’humain et les automatismes.

La difficile mais nécessaire intelligibilité des systèmes – L’opacité des agents artificiels est considérée comme une cause majeure de ces difficultés (Christoffersen & Woods, 2002 ; Dekker & Woods, 2002). En effet, le manque d’informations renvoyées par le système sur son propre fonctionnement et, en amont, par le manque de dialogue possible portant sur le statut de l’information transmise, sont des éléments centraux dans les difficultés rencontrées par les opératrices et opérateurs. Les systèmes complexes actuels ont tendance à développer des cascades de réactions automatiques qui diminuent, voire éliminent la capacité des opérateurs à prédire leur fonctionnement et provoquent des événements démesurés et imprévisibles (Taleb, 2012). Ce manque d’information renvoie à ce que l’on a classiquement appelé « l’opacité du système ». L’opacité des systèmes artificiels a tendance à rendre difficile la compréhension des intentions de ces agents artificiels. Cet état de fait est de nature à engendrer des difficultés d’anticipation/compréhension des actions de mon partenaire artificiel, générant par là même des difficultés en termes de coordination, d’acceptabilité et de sentiment de contrôle. En ce sens, l’intelligibilité des systèmes artificiels (par exemple, le fait de produire un comportement clair, prévisible et compréhensible) constitue un défi majeur par la communauté en ingénierie des systèmes.

Nous pensons qu’il est possible d’utiliser le sens haptique (combinaison du sens du toucher et de la kinesthésie) afin de rendre les systèmes artificiels plus intelligibles, plus prédictibles. Cependant, si nous considérons l’existence d’une communication, alors nous devons pouvoir envoyer et recevoir des messages clairs et complets sans perturber la tâche, ou en tout cas de manière comparable à un partenaire humain. Pour cela, nous souhaitons tout d’abord identifier les informations nécessaires à la coopération. Ensuite, nous souhaitons produire des messages kinesthésiques permettant de transmettre ces informations. Nous ferons notamment évoluer nos modèles pour obtenir un comportement dont le message est le plus clair possible pour l’utilisatrice et l’utilisateur. Le taux de compréhension de ce message chez les personnes testées sera notre mesure principale. Nous espérons ainsi construire un lexique, une base de messages, dont l’utilisation effective autant que la validité sera mesurée statistiquement, le projet étant à terme de combiner ces messages pour construire une communication complexe et augmenter ainsi les capacités de communication des machines lors des interactions humain-robot. Nous appellerons ces messages des unités de sens kinesthésiques. Ces unités pourront s’agencer en messages complexes appelés discours kinesthésiques, autrement dit des enchaînements d’unités de sens kinesthésiques qui mettent au clair l’intention, le statut de l’information. Nous évaluerons finalement l’impact de ces messages sur l’utilisabilité et l’acceptabilité de fonctions d’assistance au pilotage, ainsi que leur impact sur le sentiment de contrôle de l’opératrice et l’opérateur humain.

Les objectifs

L’objectif de ce projet est de rendre intelligible les machines à travers l’interaction kinesthésique. Pour atteindre cet objectif quatre sous-objectifs ont été identifiés :

– définir un cadre théorique de la communication kinesthésique,

– analyser les conditions de l’action conjointe et leurs modèles psychologiques pour l’interaction humain-humain,

– comprendre et modéliser les mécanismes en jeux dans une telle communication (il s’agira de construire un lexique de l’interaction kinesthésique),

– implémenter ce lexique dans des agents artificiels afin d’améliorer leur intelligibilité par l’opératrice et l’opérateur humain et supporter la coopération humain machine.

Les résultats

Le laboratoire a développé un robot permettant d’étudier les interactions à un degré de liberté : SEMAPHORO-1D (Système d’Evaluation de la Manipulation Physique Homme-Robot).

Ce système a permis de mettre en valeur une unité de sens kinesthésique pour la négociation binaire (Gauche-Droite). Cette unité de sens est paramétrable et permet de montrer un comportement plus ou moins dominant (Roche et Saint-Bauzel ICRA19, THRI accepted). Cette interface a permis aussi d’étudier la notion d’agentivité dans la décision collaborative et a montré à l’heure actuelle que les partenaires virtuelles ne permettent pas de produire un sentiment de contrôle de l’interaction. Ce sentiment de contrôle a été mesuré avec des mesures de l’ « intentional binding » (Grynszpan et al., Concog 19). Enfin cette interface à permis de montrer que l’interaction kinesthésique est un moyen implicite et rapide pour transmettre la confiance (Piezzulo, Roche et Saint-Bauzel, Nature ScR 20).

Partenariats et collaborations

Le projet scientifique collaboratif ANR réuni les chercheurs et chercheurs suivant :

– Bruno Berberian, Chargé de Recherche à l’ONERA dans le laboratoire DTIS, spécialisé dans l’ergonomie et la mesure de performance de l’interaction,

– Camille Debras, Maître de Conférences à l’Université Paris-Nanterre, spécialiste en gestualité et linguistique,

– Ouriel Grynszpan, Professeur à l’Université Paris-Saclay – laboratoire LIMSI, spécialisé dans les sciences cognitives et les questions d’intelligence sociale,

– Aliyah Morgenstern, Professeur à l’Université de Paris Nanterre – laboratoire MoDyCo, spécialiste en Linguistique développementale et langue des signes,

– Ludovic Saint-Bauzel, Maître de Conférence à Sorbonne Université – laboratoire ISIR, spécialisés dans les sciences de l’ingénieur et de l’information et les sciences du vivant,

– Claudia Savina Bianchini, Maître de Conférences à l’Université Poitiers – laboratoire FORELLIS, spécialiste de linguistique et plus particulièrement dans la gestualité par la langue des signes.

Ce projet est aussi source d’une collaboration internationale avec :

– Giovanni Pezzulo Chercheur au CNR (Centre National de Recherche Italien) dans le laboratoire ISTC (Institut des Sciences et Technologies de la Cognition).