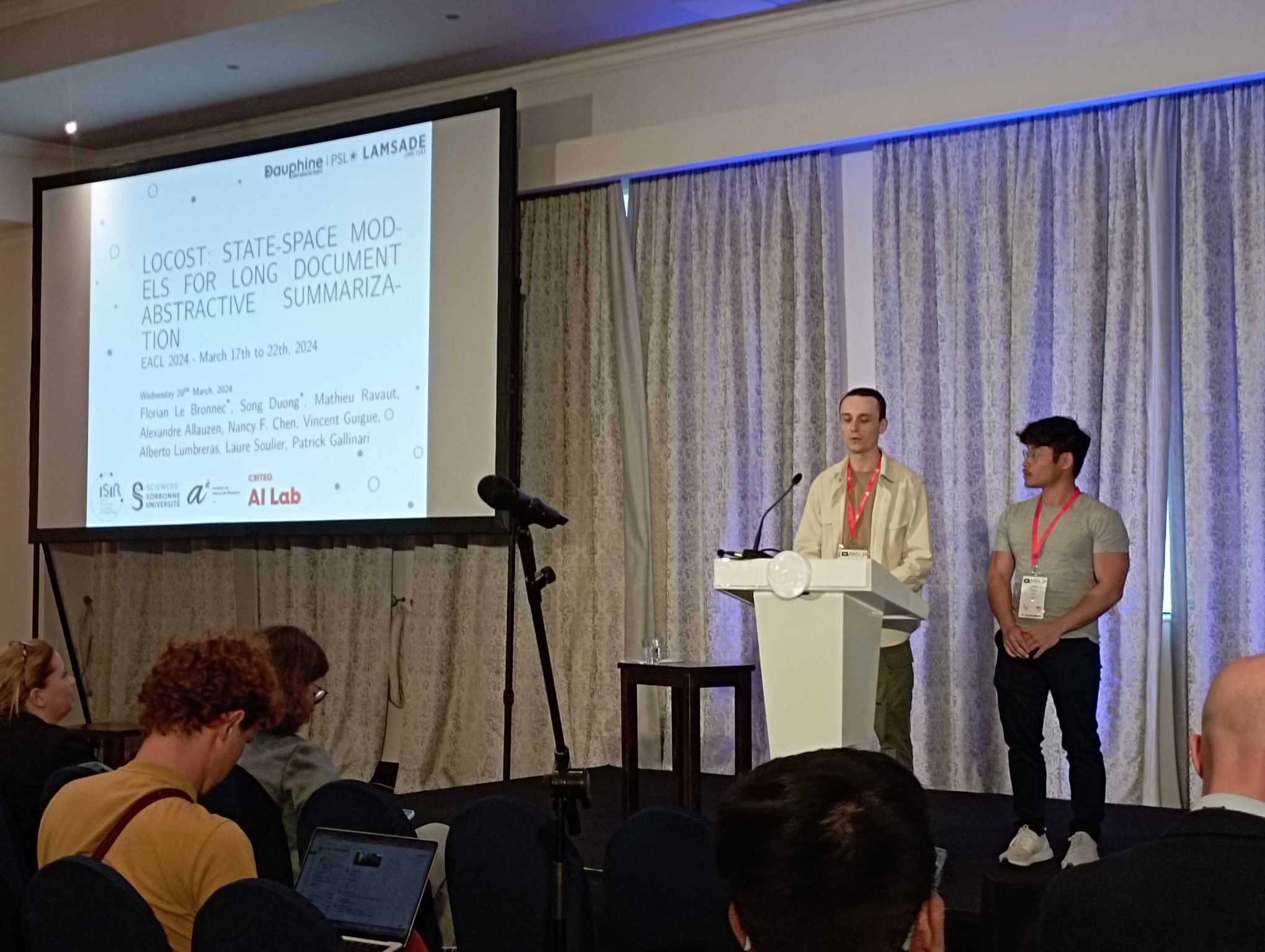

LOCOST : LOng COntext abstractive summarization with STate-space models

Alors que la quantité de données textuelles générées chaque jour continue d’augmenter de manière exponentielle, les besoins en outils capables de synthétiser, analyser et comprendre de vastes quantités de texte sont devenus essentiels dans de nombreux domaines. L’état de l’art, représenté par les architectures neuronales basées sur les « transformers », présente des limitations en termes de consommation de ressources, surtout lorsque les textes à traiter sont longs.

Le modèle LOCOST émerge dans ce contexte où la demande de traitement automatique du langage naturel est grandissante. Il vise à trouver une méthode plus économe en ressources, capable de traiter des textes de plusieurs dizaines de pages. LOCOST représente une réponse innovante aux défis posés par le traitement de textes longs, ouvrant ainsi de nouvelles perspectives pour l’analyse et la compréhension de l’information textuelle à grande échelle.

Ce travail est mené par une équipe de chercheurs et chercheuses de diverses institutions françaises et singapouriennes, impliquant l’ISIR (CNRS/Sorbonne Université), le LAMSADE (CNRS/Université Paris Dauphine-PSL), le Criteo AI Lab, l’Institute for Infocomm Research (A*Star), le Nanyang Technological University, et AgroParisTech.

Description du modèle LOCOST par les membres de l’ISIR impliqués dans ces travaux.

L’innovation face aux modèles traditionnels de traitement de texte

Le principal défi du modèle LOCOST est de trouver une alternative efficace aux modèles qui représentent l’état de l’art en génération de texte appelés « transformers ». Bien que ces derniers soient largement utilisés pour la génération de texte, ils consomment des ressources de calcul considérables lorsqu’ils sont confrontés à des textes de grande taille.

C’est là qu’intervient l’innovation apportée par LOCOST, en utilisant une architecture encodeur-décodeur basée sur les modèles à espace d’état avec une complexité sous-quadratique en fonction de l’entrée du modèle. L’équipe de recherche a réussi à concevoir un système capable de gérer des séquences textuelles allant jusqu’à 500 000 mots, tout en offrant des performances comparables aux « transformers » traditionnels. Cependant, ce qui distingue vraiment ce modèle, c’est son efficacité : il permet d’économiser jusqu’à 50% de mémoire lors de l’entraînement et jusqu’à 87% lors de l’inférence.

Vers de nouveaux horizons textuels

Les applications de cette découverte sont vastes. Non seulement elle ouvre la voie à un traitement plus efficace des textes longs, mais elle propose également de nouvelles perspectives pour des domaines tels que le droit, la médecine et la littérature, qui nécessite le traitement de grands volumes de texte.

Les membres du projet ont déjà commencé à explorer diverses applications pour leur modèle, notamment pour le résumé automatique de texte longs tels que des documents scientifiques, des rapports administratifs et des livres. Cependant, les possibilités ne s’arrêtent pas là. L’équipe envisage également d’étendre leur architecture à d’autres tâches de génération de texte, telles que la traduction de documents longs, ainsi qu’à d’autres modalités telles que le traitement de fichiers tableurs.

Bien que l’architecture à espace d’état utilisée par LOCOST soit encore relativement récente, l’équipe de recherche est optimiste quant à son potentiel d’amélioration future. Ils espèrent affiner davantage leur système pour le rendre encore plus efficient et performant.

Le modèle LOCOST représente ainsi une avancée dans le domaine du traitement automatique du langage naturel. Les travaux publiés sous le titre “LOCOST: State-Space Models for Long Document Abstractive Summarization” ont été distingué par le prix Best Paper Award lors de la 18ème Conference of the European Chapter of the Association for Computational Linguistics (EACL 2024) qui s’est tenue du 17 au 22 mars 2024. En proposant une alternative efficace et économe en ressources aux modèles existants, ces travaux ouvrent la voie à de nouvelles perspectives de traitement de texte, où les documents longs peuvent être analysés et résumés de manière plus rapide et plus précise.

Contact scientifique à l’ISIR : Florian Le Bronnec, doctorant ; Song Duong, doctorant ; Laure Soulier, maîtresse de conférences ; et Patrick Gallinari, professeur des Universités.

Lien vers le papier : https://arxiv.org/abs/2401.17919

Publié le 25 avril 2024.