Projet TELIN – The Laughing Infant

Le projet TELIN se concentre sur le développement d’un agent robotique socialement interactif (SIA) capable de reproduire le comportement d’un nourrisson pendant son apprentissage du rire. Ses principaux défis résident dans la modélisation des rires du robot et dans la décision en temps réel de déterminer quand rire, en tenant compte de l’état cognitif des nourrissons, dépassant ainsi les capacités cognitives actuellement supposées.

Pour répondre à ces défis, TELIN compile un vaste corpus d’enregistrements d’enfants riant dans divers contextes, et développe des méthodes d’annotation manuelle et automatique. Le projet analyse ensuite la production de rires chez les nourrissons pour créer un modèle formel. À partir de ce modèle, TELIN développe et évalue un modèle computationnel qui permet au robot de décider et de générer des rires en temps réel lors d’interactions. Cette initiative nécessite une collaboration interdisciplinaire entre la linguistique formelle, l’intelligence artificielle et le traitement du signal audio.

Le contexte

Le rire, l’une des premières formes de communication chez les nourrissons, se manifeste dès l’âge de trois mois, bien avant le langage, les gestes ou la marche. Des études récentes ont mis en lumière le lien étroit entre l’acquisition du rire et des compétences cognitives avancées, notamment liées à la compréhension de la négation, offrant ainsi une perspective intrigante sur l’évolution de la communication humaine.

Le projet The Laughing Infant (TELIN) s’appuie sur une synthèse de recherches variées portant sur l’acquisition du langage, la sémantique et la pragmatique du rire, les Agents Socialement Interactifs (SIA), ainsi que sur l’analyse et la synthèse du rire, combinées à des avancées en matière d’apprentissage automatique. Son objectif est de développer un SIA capable d’imiter un nourrisson pendant l’acquisition du rire, et d’utiliser ce SIA pour évaluer plusieurs algorithmes d’apprentissage. Ces algorithmes prennent en compte différentes modalités d’entrée telles que l’audio, l’expression faciale et le langage, ainsi que divers contextes tels que le jeu avec des jouets et les interactions familiales, pour générer des réponses de rire.

Le projet est soutenu par La Mission pour les Initiatives Transverses et l’Interdisciplinarité (MITI) du CNRS qui soutient des projets de recherche interdisciplinaires en finançant des allocations doctorales d’une durée de trois ans, qui sont associées à un budget de recherche durant les deux premières années.

Les objectifs

Le sujet de thèse de ce projet TELIN est de développer des modèles formels et computationnels qui calculent quand et comment un bébé robot (utilisation du robot Furhat avec un masque de bébé) répond à l’expression et à l’activité d’un participant humain. L’accent est mis sur la production du rire chez les bébés. Cela implique :

- l’analyse d’un corpus de rires de bébés,

- le développement d’une analyse théorique rigoureuse du rire lors d’une interaction entre un parent et des bébés,

- le développement d’un modèle computationnel basé sur une approche d’apprentissage profonde qui simule quand le rire doit être déclenché.

Les modèles seront évalués objectivement ainsi que par des études expérimentales.

Les résultats

L’intégration du langage et du non-verbal est un objectif essentiel pour l’IA. TELIN fait progresser ce domaine en l’étudiant dans un environnement plus simple, mais écologiquement valide, en ce qui concerne la compréhension du langage naturel, l’interaction et la connaissance du monde.

La modélisation du moment où le rire doit se produire dans une interaction entre l’humain et l’IA n’en est qu’à ses débuts. La recherche dans le cadre de TELIN abordera cette question et contribuera à recentrer les efforts dans cette direction. En outre, le développement d’un modèle informatique d’un agent virtuel rieur (intégré dans la plateforme Greta) profitera à la communauté de l’IA en fournissant une nouvelle architecture séquence à séquence.

Enfin, TELIN fournira une plate-forme permettant une étude plus écologique du développement de la communication, étant donné l’accent mis sur l’interaction multimodale. Il fournira des comptes rendus empiriques et formels détaillés de l’émergence du rire, un domaine encore relativement peu exploré. La plateforme SIA issue de TELIN sera disponible pour mener des études humain-agent.

Partenariats et collaborations

Le projet est porté par l’Université Paris-Cité et implique également :

- l’ISIR de Sorbonne Université,

- et le laboratoire Sciences et Technologies de la Musique et du Son (STMS) de Sorbonne Université.

Projet NeuroHCI – Prise de décisions multi-échelle avec les systèmes interactifs

Ce projet pluridisciplinaire s’appuie sur les Neurosciences Computationnelles pour développer des modèles IHM du comportement utilisateur-utilisatrice. Il s’agit d’étudier dans quelle mesure on peut transposer les théories, modèles et méthodes des Neurosciences Computationnelles à l’IHM.

Le projet NeuroHCI vise à améliorer la prise de décision humaine dans les mondes physique et numérique dans des contextes interactifs. Les situations dans lesquelles un humain prend une décision avec un système interactif sont variées :

Est-ce que j’utilise mon expérience ou Google Maps pour choisir mon itinéraire ? Est-ce que je réponds à cet e-mail sur mon smartphone ou sur mon PC ? Est-ce que j’utilise des menus ou des raccourcis pour sélectionner cette commande fréquente ? Est-ce que j’utilise le robot chirurgical Da Vinci pour opérer mon patient ou les instruments laparoscopiques traditionnels ? Comment puis-je atteindre cet objet avec ma prothèse robotique ?

La décision peut porter sur un choix complexe dans le monde réel assisté par un ordinateur (par exemple, un traitement médical) ou sur le choix d’une méthode pour réaliser une tâche numérique (par exemple, modifier une photo avec l’outil préféré).

Le contexte

Les neurosciences étudient les phénomènes impliquant à la fois la prise de décision et l’apprentissage chez les humains, mais ont reçu peu d’attention en IHM.

Le projet NeuroHCI est un projet en interaction humain-machine (IHM) qui vise à concevoir des systèmes interactifs développant l’expertise de l’utilisateur-utilisatrice en établissant un partenariat humain-machine. L’interaction avec ces systèmes peut être vue comme un problème de prise de décision à plusieurs échelles :

- Une tâche, par exemple choisir le bon traitement médical sur la base de recommandations basées sur l’IA ;

- Une méthode, par exemple choisir parmi différents dispositifs ou modalités pour réaliser une tâche ;

- Un objet, par exemple avec quel objet physique ou virtuel les utilisateurs-utilisatrices vont interagir ;

- Un mouvement, par exemple quelle trajectoire pour atteindre l’objet cible.

Les objectifs

L’objectif scientifique est de comprendre comment les utilisateurs-utilisatrices prennent des décisions avec des systèmes interactifs et comment ces décisions évoluent dans le temps. En effet, les utilisateurs-utilisatrices développent progressivement une expertise au cours de l’utilisation répétée des systèmes interactifs. Cette expertise influence la façon dont ils/elles prennent leurs décisions. Cela nécessite l’étude simultanée des phénomènes d’apprentissage et de prise de décision qui sous-tendent l’utilisation des systèmes interactifs.

L’objectif applicatif est de concevoir et de mettre en œuvre de meilleurs systèmes interactifs et adaptatifs. L’être humain s’adapte et développe son expertise en utilisant un système interactif. L’objectif ici est que le système, de son côté, évolue également pour s’adapter à ses utilisateurs-utilisatrices, c’est-à-dire qu’il s’habitue à leur comportement et en particulier à leur expertise. Il s’agit donc d’établir un partenariat humain-machine dans lequel les deux acteurs (humain et machine) s’adaptent l’un à l’autre.

Les résultats

Pour atteindre ces objectifs, nous démontrons les avantages de notre approche à travers 3 applications, pour lesquelles des plateformes existent déjà et sont maintenues par les partenaires, mais où des défis scientifiques demeurent pour leur adoption dans le monde réel. Ces trois applications sont :

- les interfaces graphiques intelligentes comme les systèmes de recommandation basés sur l’IA ;

- les systèmes de simulation immersifs offrant un riche retour haptique ;

- et les interfaces cobotiques médicales qui visent à restaurer ou à améliorer la capacité des humains à interagir avec des objets dans le monde réel.

Notre hypothèse de recherche est qu’il est nécessaire de développer des modèles computationnels robustes d’apprentissage et de prise de décision en IHM. Les modèles computationnels permettent d’expliquer et de prédire le comportement humain en synthétisant des phénomènes complexes de manière testable et réfutable. En IHM, ils servent à évaluer la qualité d’une interface sans avoir à mener des études d’utilisateurs-utilisatrices longues et coûteuses. Lorsque ces modèles sont robustes, ils peuvent être intégrés dans des systèmes interactifs pour optimiser l’interaction et adapter l’interface en fonction de l’expertise et/ou des actions des utilisateurs-utilisatrices.

Partenariats et collaborations

Porté par Gilles Bailly, directeur de recherche CNRS à l’ISIR, le projet ANR NeuroHCI est un projet inter-équipes interne à l’ISIR, qui implique plusieurs membres du laboratoire.

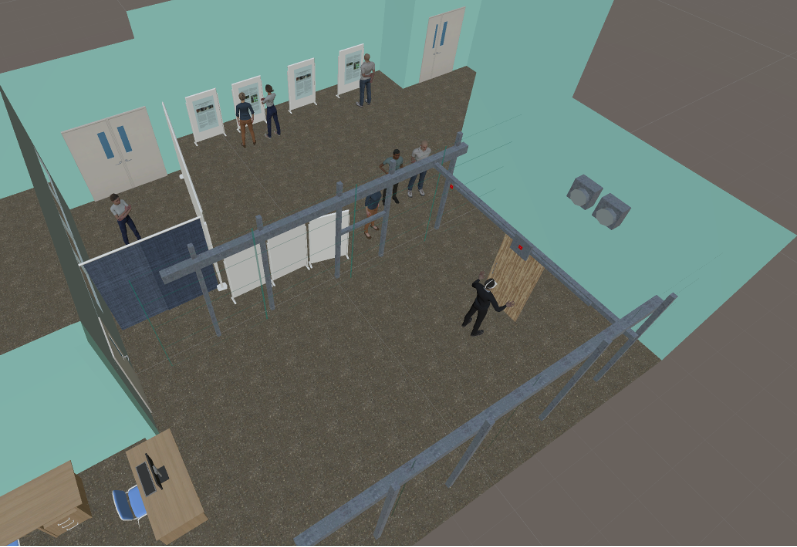

Le projet CoVR vise à améliorer le retour haptique, c’est à dire le sens du toucher, en réalité virtuelle. CoVR est une arène de réalité virtuelle augmentée d’un système robotisé pour rendre des objets virtuels tangibles. Cette plateforme est au carrefour de l’interaction humain-machine (IHM), de la réalité virtuelle, de la robotique et de l’haptique et illustre donc une grande variété des compétences de l’ISIR.

Le contexte

De nombreux systèmes pour stimuler le toucher sont développés à travers le monde. L’originalité du projet CoVR tient dans son interface robotisée, qui anticipe les mouvements de l’utilisateur-utilisatrice, et qui déplace des « props », des objets réels (une balle, une porte, un mur, etc.) et bon marché du quotidien pour qu’ils soient en contact avec l’utilisateur-utilisatrice.

Concrètement, une colonne attachée à un robot cartésien se déplace au milieu d’une arène et interagit avec l’utilisateur-utilisatrice. Quand l’utilisateur-utilisatrice va approcher sa main du mur virtuel, la colonne robotisée va se déplacer et arriver exactement au bon endroit, au bon moment. Ainsi, lorsque la main virtuelle touche le mur virtuel, la main réelle va toucher la colonne exactement au même moment, et donc avoir l’impression de toucher un vrai mur solide.

Les objectifs

Les objectifs du projet CoVR sont les suivants :

- Se positionner comme un démonstrateur d’expérience VR pour exposer le savoir faire du laboratoire aux partenaires universitaires et industriels ;

- Une plateforme éducative pour que de futur ingénieur-e en réalité virtuelle puisse avoir une expérience sur une plateforme mettant en œuvre des techniques et outils de pointe ;

- Un espace de vulgarisation pour transmettre au public les avancés dans le domaine de la robotique et des interactions Humain-Machine et qui sait éveiller une passion pour les plus jeunes.

Les résultats

La plateforme CoVR a fait l’objet d’une publication à la conférence ACM UIST : https://hal.science/hal-02931830.

C’est également une plateforme fonctionnelle avec plusieurs démonstrateurs qui ont déjà été montrés à la fête des Sciences. Des travaux continuent pour améliorer l’immersion et proposer de nouvelles démonstrations encore plus bluffantes.

Partenariats et collaborations

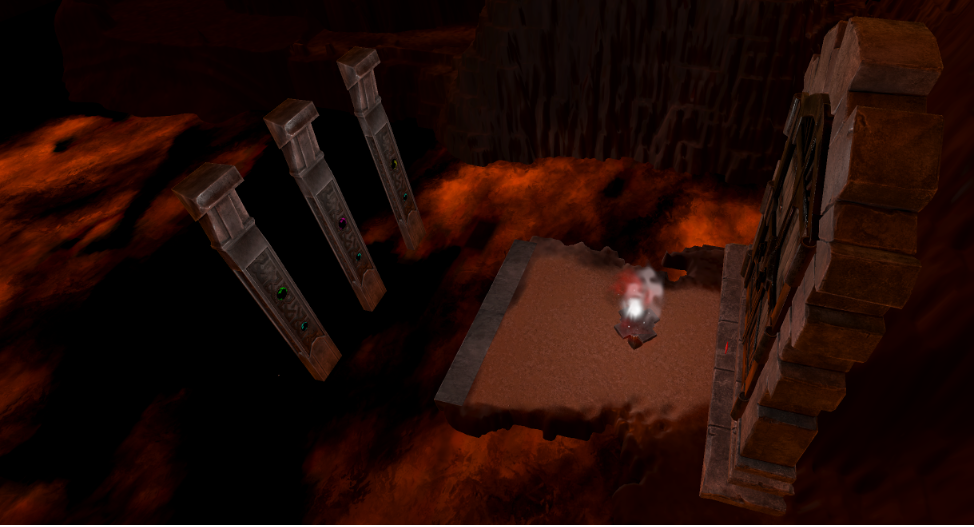

L’ISIR collabore actuellement avec ISART Digital, une école du jeu vidéo et d’animation 3D et d’effets spéciaux qui incorpore dans leur programme l’aspect scientifique. Des étudiants et étudiantes ont pu contribuer au projet en apportant un savoir-faire propre, ce qui a permis l’élaboration de scènes mettant en avant les points fort de la plateforme.

Projet CAVAA – Counterfactual Assessment and Valuation for Awareness Architecture

Le projet CAVAA propose que la conscience serve à la survie dans un monde régi par des états cachés, pour faire face à « l’invisible », des environnements inexplorés aux interactions sociales qui dépendent des états internes des agents et des normes morales. La conscience reflète un monde virtuel, un hybride de preuves perceptives, d’états de mémoire et « d’inobservables » déduits, étendus dans l’espace et le temps.

Le projet CAVAA mettra en œuvre une théorie de la conscience instanciée sous la forme d’une architecture informatique intégrée et de ses composants, de façon à contribuer à l’explication de la conscience dans les systèmes biologiques et à sa conception dans les systèmes technologiques. Le projet concevra les composants informatiques sous-jacents à la perception, la mémoire, la virtualisation, la simulation mentale, et à leur intégration. Puis cette architecture et ses composants seront testés et validés de manière incarnée, dans des robots et des agents artificiels, dans une série de scénarios impliquant l’interaction entre plusieurs humains et agents artificiels, en utilisant des mesures quantitatives standards et des corrélats comportementaux de la prise de conscience. Les scénarios porteront sur la navigation et recherche de ressources par les robots, la robotique sociale, les jeux informatiques et les arbres de décision générés par l’humain pour un coach de santé. Les tests se concentreront sur la résolution de différents compromis, par exemple entre exploration et exploitation, ou entre efficacité de la recherche et robustesse, et évalueront l’acceptabilité d’une telle technologie consciente par les utilisateurs humains.

L’ingénierie de la conscience du projet CAVAA s’accompagne d’un cadre éthique pour les utilisateurs-trices humains et les artefacts conscients dans le spectre plus large de l’IA digne de confiance, en tenant compte des ontologies partagées, de la complémentarité des intentions et de la correspondance des comportements, de l’empathie, de la pertinence des résultats, de la réciprocité, des contrefactuels et des projections vers de nouveaux scénarios futurs, ainsi que de la prévision de l’impact des choix. CAVAA offrira une meilleure expérience à l’utilisateur-trice grâce à sa capacité d’explication, d’adaptation et de lisibilité. Le cadre intégré de CAVAA redéfinit la façon dont nous envisageons la relation entre les humains, les autres espèces et les technologies intelligentes, car il rend visible l’invisible.

Le contexte

Selon Thomas Nagel, les agents conscients ont conscience de ce que c’est que d’être cet agent. Cette définition à la première personne exclut une recherche scientifique à la troisième personne, ce qui conduit à ce que le philosophe David Charlmers appelle « le problème difficile de la conscience », donc à une lacune explicative avec sa solution pragmatique consistant à distinguer la conscience phénoménale de la conscience d’accès. La conscience peut en outre être caractérisée en termes de niveaux, du coma à l’éveil, et de contenu ou de quale concernant la distinction entre le monde extérieur et le soi et le niveau d’abstraction. Face à ces défis définitionnels, les théories de la conscience ont mis l’accent sur différents aspects non exclusifs tels que l’ancrage dans le soi et les contingences sensori-motrices, la complexité, l’accès à l’information, la prédiction, l’attention ou les méta-représentations. Cependant, aucune de ces théories ne donne d’hypothèse sur ce que pourrait être la fonction de la conscience, sans parler de son rôle dans les technologies futures et les systèmes d’intelligence artificielle. Les suggestions vont plutôt du panpsychisme à l’épiphénoménalisme, ou à la réalisation de fonctions cognitives spécifiques. Il n’est pas surprenant que la réalisation de machines conscientes soit considérée comme peu plausible.

Le projet CAVAA se démarque de cette position. CAVAA propose que la conscience ait une fonction spécifique dans le contrôle du comportement adaptatif qui est apparu pendant l’explosion cambrienne : la capacité de survivre dans un monde régi par des états cachés, en particulier ceux qui concernent d’autres agents. En effet, CAVAA propose que la conscience permette aux agents de se découpler des états sensoriels immédiats et de gérer « l’invisible », allant des politiques comportementales dans des environnements inexplorés et des aspects non observables des tâches, aux complexités de l’interaction sociale qui dépendent des états internes des agents (par exemple, les intentions, les connaissances et les émotions), et aux normes morales qui guident l’action de l’interaction collective. La conscience reflète donc un monde virtuel qui est un hybride de preuves perceptives, d’états de mémoire et « d’inobservables » déduits, étendu dans l’espace et le temps et qui repose sur cinq processus fondamentaux : la capacité de virtualiser des espaces de tâches, de fusionner des éléments « réels » et virtuels dans ces modèles internes, d’exécuter des simulations parallèles orientées vers l’avenir d’états possibles du soi-monde, de les fusionner en une seule scène consciente qui définit le contenu de la conscience, et d’utiliser la conscience pour biaiser l’évaluation et la consolidation de la mémoire.

Pour atteindre cet objectif, le consortium CAVAA s’appuiera sur notre compréhension croissante de des bases biologiques de la conscience et de son rôle dans la construction de modèles internes de mondes virtualisés dans lesquels se déroule la vie mentale.

Les objectifs

Le projet se concentre sur la mise en place du plan de gestion des données, l’organisation des flux de collecte de données, la mise en place du cadre éthique et juridique, la définition des exigences et des spécifications de la technologie, la réalisation d’une analyse des brevets et du marché et la mise en place des bases de l’architecture CAVA et de ses composants, des scénarios de validation et des métriques, et des spécifications des aspects éthiques et juridiques. Les principaux objectifs du projet sont :

- développer cette activité et accélérer l’interfaçage de l’architecture avec les systèmes externes et l’intégration globale ;

- déployer des scénarios et valider l’obtention des premiers résultats, sous réserve d’une analyse plus approfondie et de la mise à jour des exigences. Ces résultats permettront également d’identifier les limites éventuelles de l’architecture et de ses composants ;

- mettre à jour de l’architecture pour en faire une solution clé en main et se concentrer sur l’avancement des tâches de référence les plus difficiles. L’architecture et son code sous-jacent seront présentés et documentés en vue d’une diffusion publique dans l’attente des objectifs des petites et moyennes entreprises en vue d’une commercialisation ultérieure.

Les résultats

Le projet CAVAA développera une architecture de contrôle cognitif au-delà de l’état de l’art pour des systèmes synthétiques avancés validés dans des tâches d’interaction spatiale et sociale. La réalisation de l’architecture CAVAA fait progresser l’état de l’art en matière d’intelligence artificielle, d’interaction homme-robot et d’informatique basée sur les neurosciences en fournissant une architecture intégrée et en ayant un impact sur plusieurs domaines de recherche : des neurosciences théoriques et computationnelles et des sciences cognitives à l’ingénierie, la philosophie et les sciences sociales. L’approche à cinq niveaux de CAVAA comprend l’architecture cognitive, les systèmes informatiques, la conscience de la machine, l’incarnation et le comportement conscient.

Partenaires et collaboration

Le projet est financé par le Conseil Européen de l’Innovation (EIC) de l’Union Européenne, sous la référence : EIC 101071178. Il s’agit d’un projet européen collaboratif incluant les partenaires suivants :

- Radboud University, Pays-Bas ;

- Centre for Research & Technology, Hellas (CERTH), Grèce ;

- University of Technology Chemnitz, Allemagne ;

- Sorbonne University, France ;

- Eodyne, Espagne ;

- Robotnik, Espagne ;

- Uppsala University, Suède ;

- Tp21, Allemagne ;

- University of Oxford, Royaume-Uni ;

- University of Sheffield, Royaume-Uni.

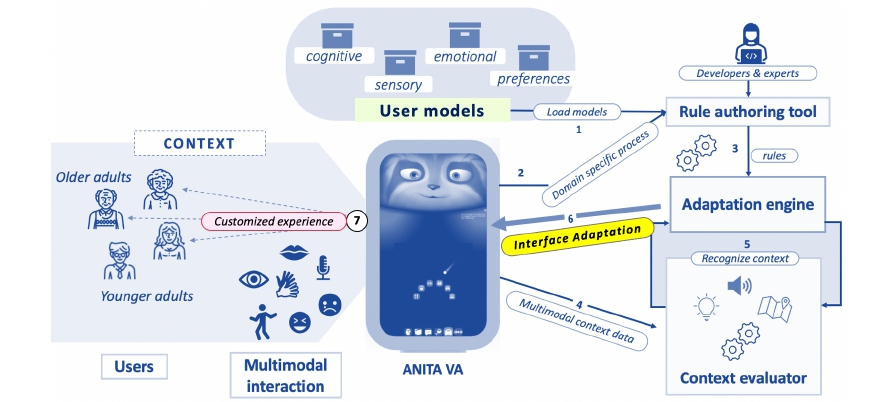

Projet ANITA – Adaptive iNterfaces for accessible and Inclusive digiTal services for older Adults

Le projet ANITA aborde la question de l’accessibilité et de l’e-inclusion pour les personnes âgées. En utilisant une approche multidisciplinaire et intégrative, nous visons à contribuer à une meilleure compréhension des besoins et des préférences des personnes âgées en ce qui concerne l’accès aux services numériques utilisant des assistants virtuels. Des méthodes qualitatives et expérimentales (associant des évaluations cliniques, des approches UX (expérience utilisateur), de l’apprentissage automatique, des techniques de traitement des signaux sociaux, des méthodes de sciences sociales) permettront une meilleure compréhension des besoins des personnes âgées afin de concevoir des interfaces d’assistants virtuels plus inclusives, efficaces, utiles et accessibles.

À son terme, le projet proposera des moyens concrets de réduire le fossé numérique chez les personnes âgées en identifiant les points clés d’une conception d’interface accessible. Ces résultats seront résumés dans un ensemble de lignes directrices pratiques destinées aux parties prenantes souhaitant s’engager dans une approche de conception inclusive et utiliser ces solutions. ANITA fournira également une base technologique et conceptuelle pour d’autres publics ayant des besoins spécifiques, et qui pourraient également bénéficier de l’adaptabilité dynamique des assistants numériques pour différentes tâches.

Le contexte

Les technologies numériques sont devenues indispensables dans notre vie quotidienne, mais elles peuvent poser des défis pour les personnes âgées qui ne sont pas toujours familières avec ces outils. Le numérique est souvent source d’exclusion pour les seniors. C’est pour cela que le projet ANITA a été mis en place, afin d’aider les personnes âgées à s’approprier les outils numériques et à les utiliser en toute autonomie.

Le projet ANITA – Adaptive iNterfaces for accessible and Inclusive digiTal services for older Adults est un projet ANR qui vise à améliorer l’accessibilité et l’inclusion numérique pour les personnes âgées.

Les objectifs

L’objectif principal d’ANITA est la conception, le développement et l’évaluation d’une plateforme d’assistants virtuels adaptatifs, pour fournir un accès aux services numériques, qui est capable de répondre aux différents besoins et capacités des personnes âgées. Les deux principales caractéristiques du projet sont :

- l’accent mis sur la reconnaissance automatique et dynamique du comportement de l’utilisateur (verbal et non verbal), qui servira de base au système pour fournir des ajustements personnalisés des paramètres d’accessibilité et des modalités d’interaction,

- et la conception de comportements d’interface pour les assistants virtuels qui favorisent l’accessibilité, ainsi que des interactions efficaces et positives lors de l’utilisation du système.

Les résultats

La principale application est la mise en place d’interfaces facilitant l’accès à des services.

ANITA fournira une approche complète de la conception et de l’utilisation des assistants virtuels pour les organismes d’évaluation, en abordant des thèmes tels que la fracture numérique, l’inclusion sociale, les représentations, ainsi que les avantages et les inconvénients liés à l’utilisation des assistants virtuels par les organismes d’évaluation eux-mêmes et par les concepteurs technologiques. Nous examinerons également les risques éthiques (par exemple, la déception, l’attachement, le remplacement de l’assistance humaine, la vulnérabilité, la stigmatisation) et les préoccupations juridiques (par exemple, le consentement, la vie privée, la sécurité) concernant les technologies utilisant l’IA, la collecte de données des utilisateurs et le profilage des utilisateurs pour le fonctionnement efficace des services.

Partenariats et collaborations

Coordonné par l’Hôpital Broca (APHP), le projet implique plusieurs partenaires européens à savoir :

- le Laboratoire d’Informatique de Grenoble (LIG),

- l’Assistance Publique des Hôpitaux de Paris (APHP),

- l’ISIR de Sorbonne Université,

- et Spoon .

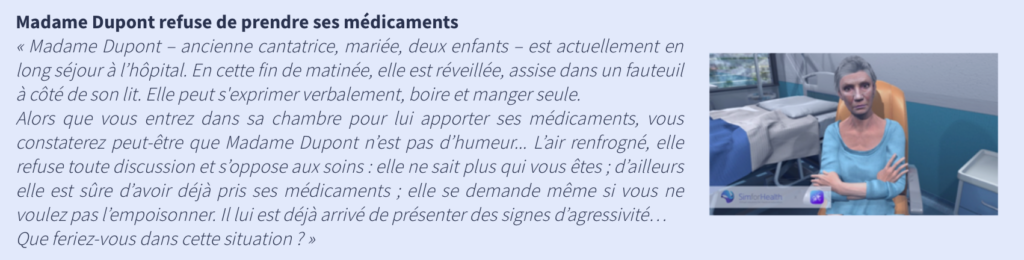

Projet VirtuAlz – Outil de formation par simulation « Patient Virtuel » pour des professionnels des secteurs sanitaire et medicosocial travaillant auprès de personnes atteintes de la maladie d’Alzheimer ou maladies apparentées.

Comment permettre aux soignants, en particulier infirmiers et aides-soignants, de surmonter les difficultés à interagir au quotidien avec les patients atteints de la maladie d’Alzheimer ? Comment les former aux bons gestes et à une communication appropriée à chaque stade de la maladie ? Comment peut-on améliorer la pratique professionnelle par la simulation ? C’est en réponse à ce besoin de formation exprimé par les professionnels de santé qu’est né le projet VirtuAlz.

Le jeu sérieux VirtuAlz est conçu pour fournir, aux professionnels en gériatrie, un module de formation au raisonnement clinique et aux compétences de communication non verbales en proposant différents scénarii de situations critiques fréquemment rencontrées et de prise, en charge délicate (i.e refus de prise de médicaments, déambulation), dans un cadre sécurisé.

Le contexte

Les capacités de communication des personnes présentant la maladie d’Alzheimer ou autre maladie apparentée (MAAD) s’altèrent avec le temps, à mesure que s’aggravent les pertes de mémoire et/ou les atteintes de certaines fonctions cognitives. Ces troubles dégradent la qualité de leurs relations avec leurs aidants et soignants, et cette dimension serait peu prise en compte dans la formation initiale et continue des professionnels de santé.

Une préparation insuffisante, en particulier en communication non verbale à laquelle ces patients seraient très sensibles, serait aujourd’hui la cause de nombreuses dicultés rencontrées par les soignants. Les formations pour les professionnels de santé au contact et en charge de personnes atteintes de troubles cognitifs devraient inclure des connaissances non seulement théoriques, mais également pratiques afin de communiquer efficacement avec ces patients et de gérer des situations complexes en respectant leur sécurité et dignité.

Ces compétences, pourtant essentielles pour les professionnels de santé et le personnel en charge des personnes atteintes de la maladie d’Alzheimer sont aujourd’hui insuffisamment maîtrisées et rarement enseignées, que ce soit en formation initiale ou en formation continue.

Les objectifs

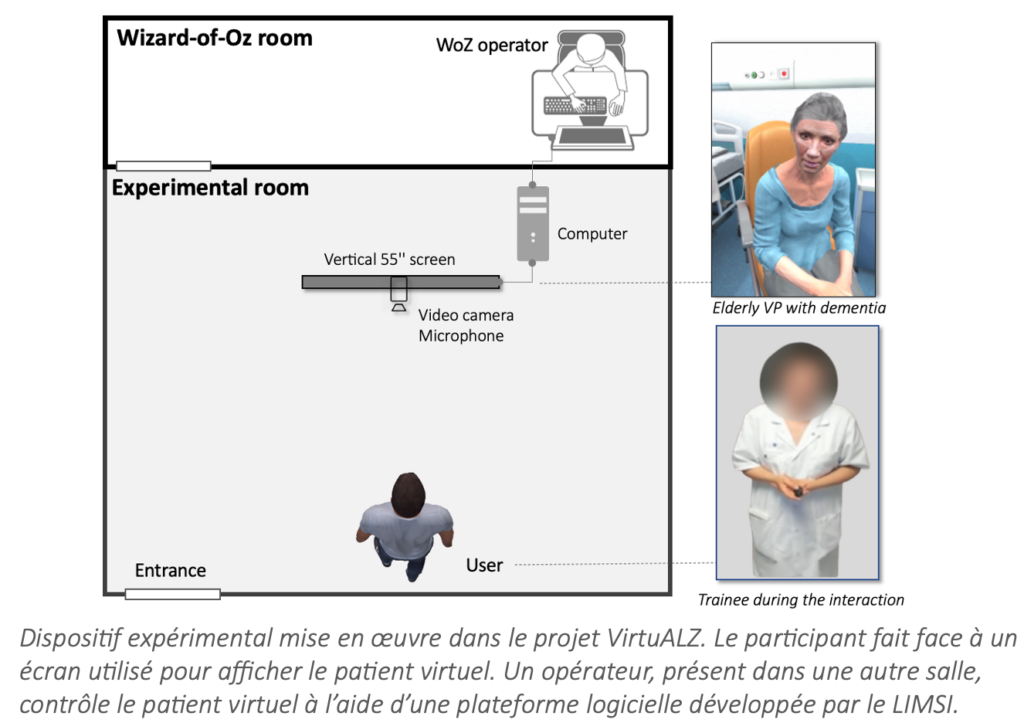

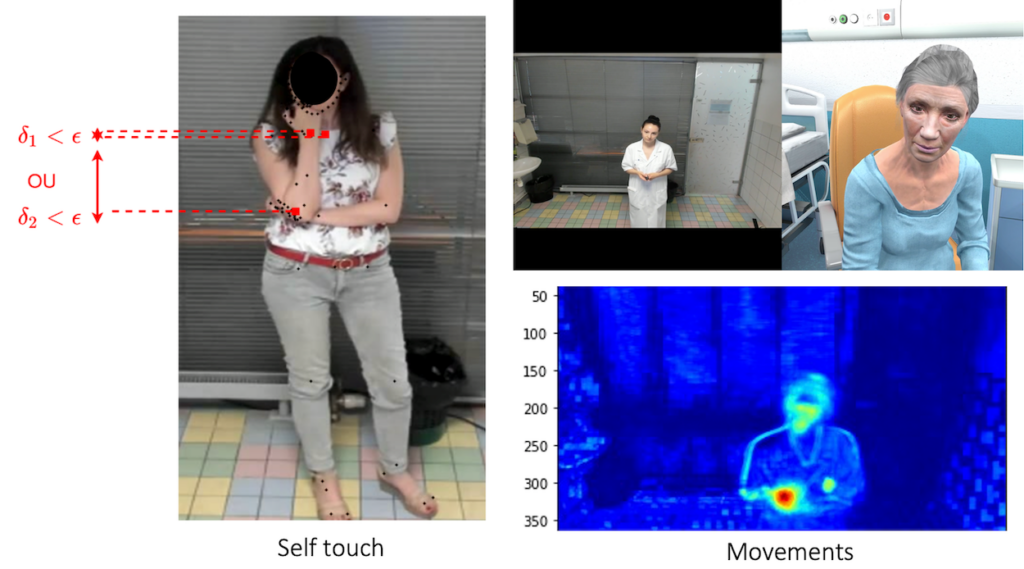

Le projet VirtuAlz avait pour objectif d’élaborer, de développer et d’évaluer un patient virtuel (PV) qui pouvait simuler des symptômes de maladie d’Alzheimer, sur le plan verbal et non verbal (expression du visage, posture, mouvements). Le projet s’est appuyé sur l’analyse de l’activité en situation de travail pour la formation, la scénarisation de simulation numérique relationnelle avec patient virtuel et l’interprétation automatisée et en temps réel du comportement de l’apprenant à partir de signaux sociaux (mouvements, gestes, expressions faciales, distance interpersonnelle).

Les résultats

Dans les pré-tests, nous avons évalué les qualités ergonomiques du dispositif et des scénarii proposés à l’aide d’entretiens et de questionnaires auprès de professionnels de santé. Cette étape a permis de faire les modifications techniques nécessaires dans le dispositif.

Puis, nous avons conduit deux vagues d’expérimentations, incluant deux scénarios (« la prise de médicaments » et « la déambulation ») auprès de professionnels de santé et montré que le dispositif Virtualz permettait d’interagir avec un patient virtuel utilisable, acceptable et ayant un bon niveau de réalisme selon ces professionnels.

Nous avons pu développer la génération de comportements du patient virtuel tels que des comportements verbaux (voix synthétisée) et non verbaux (mouvements du corps et de la tête, direction du regard, expressions faciales) imitant un patient âgé présentant des signes de la maladie d’Alzheimer (apathie, perte de mémoire, agitation, agressivité ou refus de soins). Le stagiaire pouvait interagir en langage naturel avec le patient virtuel par le biais d’une simulation en magicien d’Oz. La plateforme développée analyse le flux vidéo et transmet en temps-réel une suite de symboles décrivant les comportements non-verbaux du professionnel de santé aux autres modules informatiques du projet VirtuALZ.

Un aspect essentiel du jeu sérieux Virtualz concernait l’évaluation automatique des comportements non verbaux (expressions faciales, proxémie, toucher facial, mouvements, postures) des apprenants capturés pendant l’interaction avec le patient virtuel.

Enfin, nous avons examiné les conditions d’implémentation du dispositif dans la formation des professionnels. Le dispositif de patient virtuel créé pose les bases pour un socle de modules de formations variées dans tout type de contexte.

Partenariats et collaborations

Soutenu par l’Agence Nationale de la Recherche (ANR) dans le cadre du Challenge Life, health and wellbeing, le projet Virtualz a associé l’Assistance Publique-Hôpitaux de Paris (APHP, coordinnateur), l’Institut des Systèmes Intelligents et de Robotique (ISIR), le laboratoire d’Informatique pour la Mécanique et les Sciences de l’Ingénieur (LIMSI), le laboratoire Centre interuniversitaire de recherche en éducation de Lille (CIREL), ainsi que l’entreprise SimForHealth (Interaction Healthcare). Il a duré 48 mois (mai 2018 à mai 2022).

Projet « Le langage et sa sémantique »

Le contexte

Ce groupe de travail s’intéresse aux différentes formes de langage (texte écrit et langage oral, parole et signaux sociaux, geste, visage, etc.) ainsi qu’à la notion de sémantique qui en découle. A l’intersection entre le traitement automatique du langage, la perception, les sciences cognitives et la robotique, le langage soulève de nombreux enjeux dérivant de l’analyse à la génération, que ce soit dans un contexte individuel ou interactif.

Voici une liste non exhaustive d’exemples d’applications tirées de nos domaines de recherche :

- Prise en compte des hésitations, du rire et autres signaux sociaux

- Lien parole et comportements non verbaux ;

- Dialogues contextualisés (historique, tâche, interaction) / Systèmes de questions-réponses ;

- Synthèse textuelle d’information et d’interaction ;

- Recommandation et recherche d’information ;

- Analyse et représentation de la sémantique ;

- Variation de style ou de contenu.

Les objectifs

L’objectif de ce groupe est de rassembler des chercheuses et chercheurs ayant des expertises différentes autour du langage. A ce jour, les activités mises en place sont essentiellement des groupes de discussion ou présentation scientifiques dans l’objectif de faire émerger des centres d’intérêts communs.

Sur le long terme, un des enjeux sera de mettre en place des co-supervisions de stagiaires et/ou doctorantes et doctorants autour de cette thématique ou des mini-projets scientifiques.

Partenariats et collaboration

Le projet « Le langage et sa sémantique » est un projet fédérateur, interne à l’ISIR, qui n’implique pas de collaboration extérieure au laboratoire.

Contact du projet : projet-federateur-langage(at)listes.isir.upmc.fr

Projet ELSA – Apprentissage effectif des affordances sociales pour l’interaction humain-robot

« Étudier l’apprentissage d’affordances sociales chez les robots ». Les affordances sont des opportunités d’actions perçues par un agent pour interagir avec son environnement. Elles intéressent les roboticiens pour décrire les interactions potentielles du robot avec des objets au-delà des simples propriétés physiques.

Dans le projet ELSA, nous étendons la notion aux affordances sociales, qui n’ont pour l’instant été que peu étudiées en robotique. Ici, nous faisons les hypothèses suivantes :

- que les robots peuvent apprendre les affordances sociales de la même façon qu’ils apprennent des affordances dans des situations non-sociales ;

- que les robots, en apprenant à reconnaître de manière autonome les affordances sociales offertes par leurs partenaires humains, pourront répondre plus efficacement et de manière plus appropriée aux humains. Ceci permettrait ainsi de faciliter la coordination et la coopération entre humains et robots.

Le contexte

Le concept d’affordances est la capacité d’un objet ou d’un environnement à évoquer son utilisation ou sa fonction. Il attire progressivement l’attention des scientifiques en robotique et en Intelligence Artificielle (IA) comme un moyen de fournir aux agents artificiels plus d’autonomie, en leur permettant d’apprendre par eux-mêmes quelles commandes envoyées à leurs moteurs produisent des effets sur l’environnement.

Néanmoins, les avantages sociaux demeurent largement inexplorés en robotique et en IA. Si les affordances physiques représentent une étape vers des agents autonomes qui comprennent mieux leur environnement physique, les affordances sociales sont nécessaires pour évoluer vers des environnements multi-agents plus réalistes. Nous savons que les humains acquièrent des affordances sociales pour apprendre comment bien interagir avec les autres. Permettre aux robots de faire ce même type d’apprentissage leur permettrait de mieux interagir avec les humains.

Les objectifs

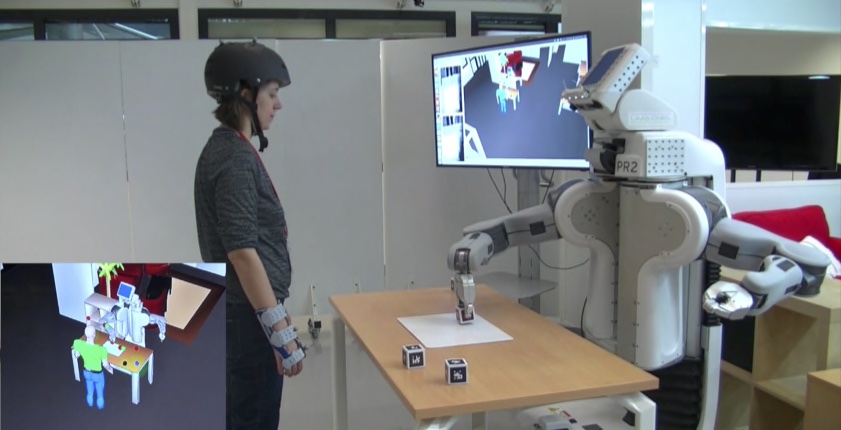

L’objectif central du projet est d’étudier les conditions qui permettent à un robot d’apprendre de manière efficace des affordances sociales, de façon à faciliter la communication et la coopération avec les humains. Nous allons en particulier étudier les problèmes liés aux affordances sociales en robotique, organisés en 4 lots de travail :

- Théorie et pratique des affordances sociales ;

- Les affordances sociales dans la prise de décision (dirigé par l’ISIR) ;

- Les affordances sociales pour l’exécution des actions ;

- Architecture, scénario, intégration.

Les résultats

Le cadre applicatif principal de ce travail est celui de l’interaction humain-robot, et plus précisément de la coopération humain-robot. Mieux comprendre comment les robots peuvent apprendre à reconnaître et à exprimer des affordances sociales aiderait à contribuer à la conception de robots plus coopératifs avec l’humain. Cela permettrait alors de seconder l’humain dans une variété de tâches, comme la manipulation d’objets ou encore la navigation. Le projet contribuera également à d’autres retombées, notamment en termes de connaissances fondamentales sur la manière dont l’humain apprend, perçoit et exprime des affordances sociales. Mettre au point des algorithmes permettant à un robot d’apprendre des affordances sociales est une manière de proposer des modèles de la façon dont les humains font cet apprentissage.

D’une façon générale, le projet répond à un manque critique de connaissances de base sur la façon dont les affordances sociales sont apprises et utilisées dans le contexte de l’interaction humain-robot. L’atout majeur du projet est qu’il s’attaque à un sous-domaine relativement inexploré (les affordances sociales en robotique) qui s’appuie sur des domaines bien étudiés (les affordances non-sociales en robotique, mais aussi en psychologie).

Partenariats et collaborations

Le projet est coordonné par Mehdi Khamassi, Directeur de Recherche à l’ISIR. Le consortium du projet est composé de la manière suivante :

- L’ISIR, Sorbonne Université – France,

- LAAS-CNRS – France,

- Department of Computer Science (IFI), Université de Innsbruck – Autriche,

- Digital Science Center (DiSC), Université de Innsbruck – Autriche.

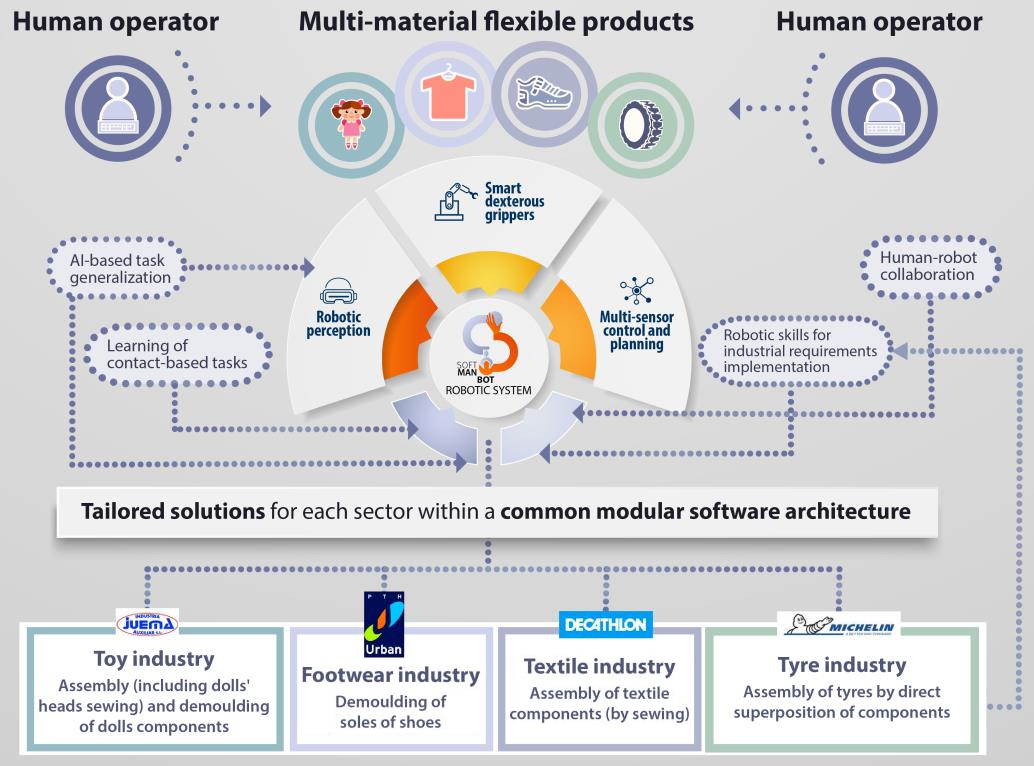

Projet SOFTMANBOT : Technologie robotique avancée pour la manipulation de matériaux mous dans les secteurs de la fabrication

SOFTMANBOT est un projet axé sur l’utilisateur industriel final, qui fournira un système robotique innovant et global pour la manipulation de matériaux souples et déformables, dans le cadre de processus de production à forte intensité de main-d’œuvre.

Le système robotique sera composé de trois éléments principaux :

- un système de perception robotique générique (perception du produit et de l’opérateur humain),

- une plateforme de contrôle et de planification multi-capteurs (algorithmes de contrôle avancés pour l’asservissement de la forme et du contact, généralisation des tâches basée sur l’IA),

- et des pinces agiles intelligentes (conception mécanique intelligente qui incarnera les compétences de préhension/manipulation et intégrera des capteurs – principalement tactiles – pour identifier précisément l’état de contact entre le produit et le préhenseur) capables de manipuler des composants souples avec des niveaux élevés de robustesse et de flexibilité.

Le contexte

Les robots sont employés depuis longtemps dans des applications de l’industrie automobile, depuis leur introduction dans ce secteur au milieu du siècle dernier. Depuis, les solutions robotiques ont été adoptées par de nombreux secteurs et pour des applications diverses comme dans les domaines de l’aéronautique, l’électronique, l’électroménager, l’industrie alimentaire, l’emballage, les machines textiles, etc. Toutefois, l’adoption de solutions robotiques dans les processus industriels reste faible dans un nombre important de secteurs qui pourraient être la cible idéale de ce type de solutions en raison de la nature de leur travail (tâches répétitives, dangereuses, etc.). Ce fait limite le niveau d’automatisation dans ces industries et restreint le potentiel de croissance de ces entreprises, en particulier dans des secteurs déterminés tels que les industries du textile, de la chaussure ou du jouet, qui doivent réduire leurs coûts de production et augmenter leur productivité en raison de la concurrence acharnée à laquelle ils sont confrontés avec des produits provenant d’autres marchés internationaux tels que l’Asie (Chine, Bangladesh, Inde, etc.).

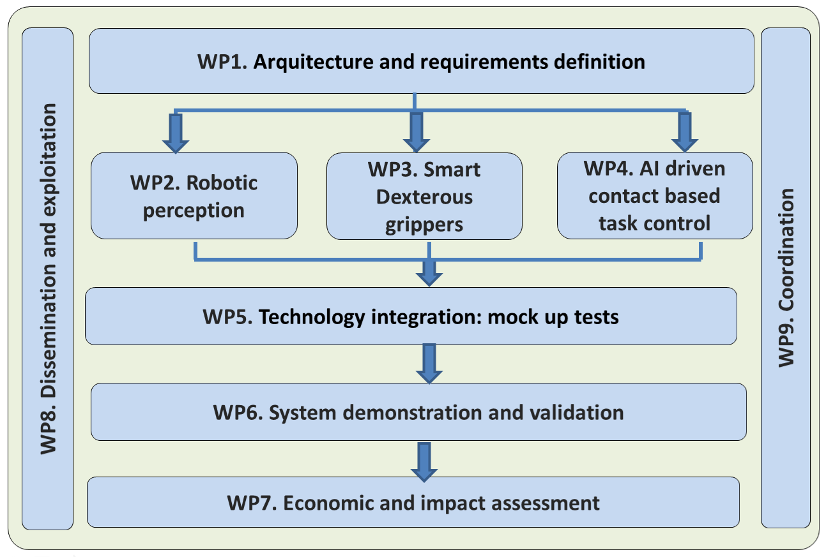

Les objectifs

L’objectif général du projet est de développer et de démontrer une approche innovante et universelle de la manipulation robotique de matériaux flexibles et déformables, basée sur l’intégration de technologies de fabrication avancées pour l’automatisation de tâches basées sur le contact, soutenue par un système de perception robotique intelligent, une plateforme de planification et de contrôle multi-capteurs et le déploiement de préhenseurs intelligents et à dextérité universelle capables de manipuler des composants souples avec des niveaux élevés de robustesse et de flexibilité.

Afin de réaliser l’objectif du projet, le projet SOFTMANBOT se déroulera sur 42 mois avec un plan de travail divisé en 9 Work Packages.

Les résultats

Les résultats attendus sont les suivants :

- Une architecture modulaire et inter-opérable intégrant les différents systèmes et composants matériels et logiciels de la solution robotique SOFTMANBOT ;

- Une plateforme de perception robotique pour la configuration et le suivi en temps réel de la déformation et de l’état de contact de produits flexibles complexes intégrant des stratégies d’apprentissage ;

- Un système de planification et de contrôle multi-capteurs qui, en prenant comme entrées le modèle du produit et le modèle des interactions homme-robot, implémentera les compétences du robot pour gérer la déformation et le contact du produit, établira une séquence d’actions pour réaliser les tâches, définira les sorties requises pour interagir avec l’homme et enfin paramètrera de manière générique les tâches à réaliser ;

- Des préhenseurs intelligents, adroits et peu coûteux pour la manipulation d’objets déformables, intégrant des capteurs (tactiles, de force, de proximité, de vision…) et une structure mécanique intelligente (incarnation des capacités de préhension/manipulation) capables d’exécuter des tâches de manipulation difficiles avec des niveaux élevés de précision, de tolérance aux pannes, de robustesse et de flexibilité dans des environnements difficiles et changeants ;

- Intégration des composants et modules technologiques développés pour la conception de solutions rentables et adaptatives pour des applications industrielles ;

- Validation des résultats du projet de manière rentable dans des conditions industrielles réelles par le biais de 4 démonstrations pilotes dans quatre usines européennes (secteurs du jouet, du textile, de la chaussure et du pneumatique) ;

- Une évaluation environnementale (LCA), économique et sociale de l’ensemble de la solution SOFTMANBOT, y compris une évaluation de l’acceptation par les utilisateurs ;

- Des plans de diffusion, d’exploitation et de communication coordonnés afin de maximiser l’impact technique, social et économique du projet au sein des clusters de démonstration et à travers l’Europe.

Partenariats et collaborations

Ce projet a été financé par le programme de recherche et d’innovation Horizon 2020 de l’Union européenne « Transforming European Industry », sous la convention de subvention nº 869855.

Le consortium est composé de la manière suivante :

- Sigma Clermont, Université Clermont Auvergne – France,

- AIJU Institut Technologique – Espagne,

- INESCOP, Centre de technologie et d’innovation – Espagne,

- Industria Auxiliar Juema – Espagne,

- Sorbonne Université – France,

- Decathlon Produzione Italia – Italie,

- STAM Mastering Excellence – Italie,

- IIT, Institut Italien de Technologie – Italie,

- Zimmer Group – Allemagne,

- PTH URBAN – Espagne,

- Michelin – France.

En savoir plus sur SOFTMANBOT: http://softmanbot.eu/

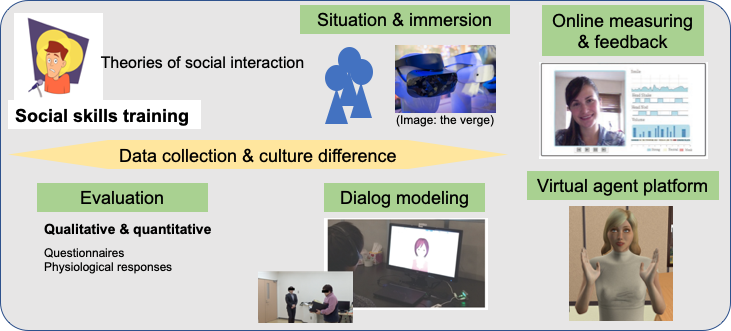

Projet TAPAS : Entrainement d’aptitudes sociales affectives personnalisées et adaptées avec des agents culturels virtuels

Le projet TAPAS vise à développer des outils et des méthodes de formation aux compétences sociales (de l’anglais SST : Social Skill Training) pour une grande variété de population. Les compétences sociales font référence à la gestion des comportements verbaux et non verbaux lors d’une interaction avec une ou plusieurs personnes. Les personnes qui ont des difficultés à interagir avec les autres souffrent d’utiliser de manière appropriée leurs comportements sociaux et de les interpréter chez les autres. Les thérapeutes utilisent les SST (formation aux compétences sociales) pour former les personnes à pratiquer l’interaction sociale et à surmonter leur peur sociale. Elle repose sur le jeu de rôle comme moyen de mettre les participants dans une situation sociale contrôlée.

Le contexte

La SST conventionnelle est une méthode établie qui a été développée à l’origine pour réduire l’anxiété et l’inconfort, et pour apprendre les compétences appropriées requises lors des interactions sociales. Elle améliore efficacement les compétences sociales des personnes atteintes de TSA (Trouble du spectre de l’autisme).

Le modèle de formation de base des SST suit cinq étapes : instruction, modelage, jeu de rôle, retour d’information et devoirs. En outre, nous allons modéliser la thérapie cognitivo-comportementale (TCC), telle que le « recadrage cognitif », qui est une technique utile pour comprendre les sentiments et les humeurs malheureux, et pour remettre en question les « croyances automatiques » parfois erronées qui peuvent se cacher derrière eux. Elle exige de former les utilisateurs à gérer leurs propres comportements multimodaux ainsi qu’à prêter attention et à s’adapter au comportement de leurs interlocuteurs dans une situation de stress social (par exemple parler en public).

Les objectifs

Le projet TAPAS développera des outils et des méthodes permettant aux SST de fournir une formation personnalisée aux compétences sociales et d’aider à surmonter le stress social dans ces situations quotidiennes impliquant une présentation à l’école et au travail.

Notre objectif est de développer une plateforme permettant aux participants de jouer des rôles dans les interactions sociales. La population ciblée est constituée d’individus neurotypiques, mais aussi d’individus présentant différentes échelles de pathologies sociales, notamment la timidité, l’alexithymie et les troubles du spectre autistique (TSA). La conception de la plateforme s’inspirera de deux méthodes courantes de formation aux compétences sociales : la SST conventionnelle et la thérapie cognitivo-comportementale.

Les résultats

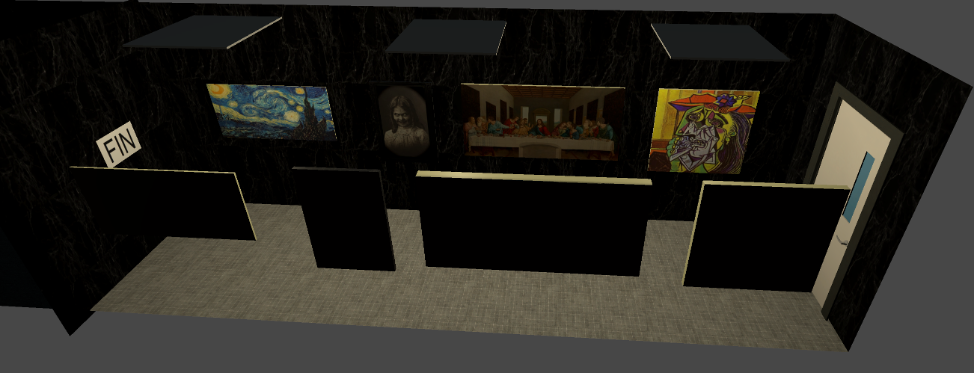

Nous concevrons trois scénarios pertinents qui formeront différents ensembles de compétences sociales :

- former l’utilisateur à travailler sur une tâche commune avec un ou plusieurs pair(s) virtuel(s),

- former l’utilisateur à maintenir l’attention et l’engagement d’un (petit) public virtuel lors de la présentation de certains documents,

- former l’utilisateur à présenter conjointement avec un pair virtuel un travail commun devant un petit public virtuel.

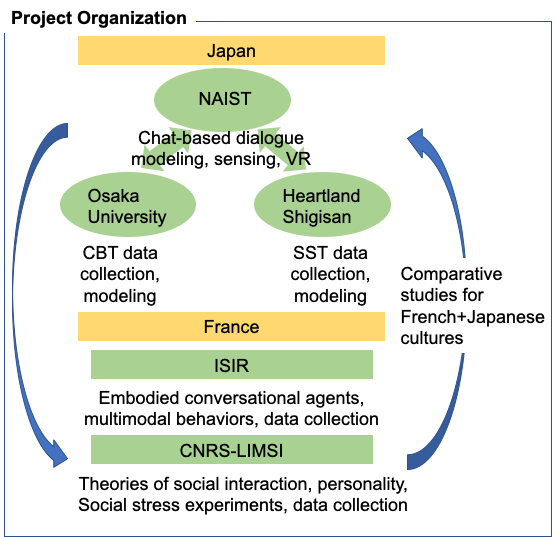

Partenariats et collaborations

- Institut des Systèmes Intelligents et de Robotique (ISIR), France,

- Laboratoire d’Informatique pour la Mécanique et les Sciences de l’Ingénieur (LIMSI), CPU group, France,

- Nara Institute of Science and Technology, Data Science Center, Japan.