Offres d’emploi

Ingénieur-e de recherche « Expert-e en contrôle-commande »

Mission :

Un poste d’ingénieur-e (CDD 12 mois) est proposé à l’Institut des Systèmes Intelligents et de Robotique de Sorbonne Université, pour le développement de contrôle de mains robotique et la gestion de la plateforme expérimentale associée.

Le but de ce poste d’ingénieur-e est d’intégrer les développements robotiques récents dans le cadre des projet européen PILLAR Robotics et EuRobin. L’objectif principal sera de mettre en œuvre et d’intégrer des stratégies de contrôle pour accomplir des tâches de manipulation dans le cadre de scénarios industriels et d’applications domestiques. Grâce à nos recherches et à notre collaboration, nous disposons de plusieurs composants/modules pour les applications robotiques, chacun dédié à une tâche spécifique : par exemple, la reconnaissance d’objets, l’estimation de la pose, la planification de mouvements pour la saisie, les modèles de langage, la navigation, la prise de décision, etc. Par conséquent, la majeure partie de l’activité de ce poste sera consacrée à la programmation et à l’intégration de ces stratégies de contrôle dans des plates-formes robotiques dédiées, par exemple TIAGo de PAL robotics.

Activités principales :

– Développements logiciels pour le contrôle de dispositifs robotiques (Thiago et Franka): contrôle commande, programmation, filtrage traitements de signaux de capteurs, machine learning.

– Réaliser des expériences : réaliser des expériences avec des mains robotisées, enregistrer et analyser les données.

Connaissances transversales requises :

Savoir-faire :

Les candidats doivent idéalement avoir :

1) un master ou un diplôme d’ingénieur-e en robotique et systèmes de contrôle,

2) une bonne expérience de la programmation (C++, Python sous ROS1 et ROS2),

3) une expérience des environnements de simulation robotique (par exemple, Gazebo et Bullet),

4) intérêt marqué pour la robotique expérimentale : conception et mise en œuvre d’expériences avec des systèmes intégrés et des robots,

5) bonne compréhension des systèmes de contrôle robotique ; par exemple, interaction physique homme-robot, reconnaissance d’intention, manipulation et saisie expérimentale,

5) capacité à collaborer en faisant preuve d’une grande autonomie et d’une grande responsabilité,

6) disponibilité pour se rendre aux réunions de projet avec les partenaires.

Savoir-faire transversaux : la capacité de communiquer des idées scientifiques, la capacité d’analyse et de synthèse, l’autonomie, et l’initiative.

Savoir être : capacité à analyser des données expérimentales et volonté de conduire des expérimentations avec des systèmes robotiques.

Pour candidater :

Les candidats intéressés peuvent contacter Mahdi Khoramshahi [mahdi.khoramshahi@sorbonne-universite.fr] et Stéphane Doncieux [stephane.doncieux@sorbonne-universite.fr] et Aline Baudry [aline.baudry@sorbonne-universite.fr], avec pour objet « [CANDIDAT INGÉNIEUR] », en fournissant leur CV et une lettre de motivation décrivant brièvement leur parcours et leurs projets de carrière. Le poste reste ouvert jusqu’à ce qu’un candidat satisfaisant soit trouvé.

Fonctions : Gestionnaire RH, en contrat à durée déterminée d’un an dès que possible

Emploi-type : Technicien/ne en gestion RH – (REFERRENS – J4D43 / J4C42)

Catégorie : B

Corps : niveau Technicien de recherche

BAP : J

Mission :

Il s’agit d’un contrat à durée déterminée de 1 an pour réaliser des fonctions polyvalentes de gestion RH et d’accueil au sein du service administratif du laboratoire ISIR.

Activités principales :

- Instruire les dossiers de demande de recrutement du laboratoire auprès des tutelles (lab&co / CANOPE // SIFAC)

- Alerter sur les situations spécifiques (lors du recrutement ou au cours du contrat)

- Faire le suivi des entrées / prolongations / sorties des personnels

- Suivre les modifications dans les dossiers des personnels

- Renseigner les bases des tutelles (RESEDA)

- Gérer la base des congés (AGATE)

- Instruire les accueils de stagiaires (conventions, accueil physique)

- Gérer le versement des gratifications / transport des stagiaires dans SIFAC

- Renseigner la base des stagiaires du laboratoire

- Accueil physique et téléphonique des visiteurs afin de les renseigner et les adresser aux personnels

- Gestion du courrier arrivé/départ

- Réception des livraisons

Autres activités :

- Participer à l’activité du service administratif pour assurer la continuité de service

Intitulé du poste: Ingénieur·e en Interaction Humain-Machine (IHM) – Coordination Technique

Contexte et objectifs :

Ce poste d’ingénieur·e s’inscrit dans les activités du LiLLab (https://www.lillabneurodev.fr/), living lab nationale inscrit dans la stratégie pour les troubles du neuro-développement.

Les activités de recherche du LiLLab, menées au sein de l’équipe ACIDE de l’ISIR, portent sur l’Interaction Humain-Machine dans le champ des troubles du neuro-développement. Nous menons des études auprès des personnes concernées en collaboration avec plusieurs équipes de recherche et cliniques.

Le LiLLab recrute un ingénieur ou une ingénieure en charge de la coordination technique des travaux en interaction humain-machine dans le champ des troubles du neuro-développement

Ce poste est un contrat de 24 mois, avec une possibilité d’extension jusqu’à fin 2027.

Missions :

– Coordonner les travaux techniques liés à l’interaction humain-machine dans le domaine des troubles du neuro-développement.

– Concevoir et développer des interfaces utilisateur adaptées aux personnes avec des troubles du neuro-développement.

– Collaborer avec les équipes de recherche, cliniques et les utilisateurs finaux pour assurer le développement de solutions pertinentes et efficaces.

– Réaliser des études et des tests utilisateurs pour évaluer et améliorer les interfaces.

– Développer des prototypes et des maquettes fonctionnelles.

– Mettre en œuvre des méthodologies de conception centrées sur l’utilisateur et des techniques de design thinking.

– Analyser les comportements des utilisateurs et collecter des données pour optimiser les interfaces.

– Rédiger des rapports techniques et scientifiques.

– Assurer une veille technologique sur les nouvelles tendances et innovations en matière d’IHM et de neuro-développement.

Profil recherché :

Diplôme d’ingénieur ou Master en informatique, interaction humain-machine, sciences cognitives, ergonomie ou domaine équivalent.

Informations générales :

– Type de poste : Ingénieur·e

– Date de début de contrat : à partir de Septembre 2024

– Durée du contrat : 24 mois

– Quotité de travail : 100%

– Niveau d’études souhaité : Master / Ecole d’Ingénieur·e / Doctorat

– Montant rémunération : standard sur grille

– Laboratoire d!accueil : ISIR (Institut des Systèmes Intelligents et de Robotique), Campus Pierre et Marie Curie, 4 place Jussieu, 75005 Paris.

Personne à contacter :

– Mohamed Chetouani

– Tel : +33 1 44 27 63 08

– Candidature : Les candidats intéressés doivent soumettre les documents suivants par email dans un fichier PDF unique à l’adresse suivante: mohamed.chetouani[@]sorbonne-universite.fr avec comme sujet « Candidature LiLLab » : (1) Curriculum vitae avec 2 références (les lettres de recommandation sont également les bienvenues) et (2) Résumé d’une page de vos antécédents et intérêts de recherche.

– Date limite de candidature : 17 juin 2024.

Postdoc « Multimodal Machine Learning for User Modeling and Profiling »

Objectives:

Personalized Human-Machine Interaction systems aim to provide tailored experiences that cater to the individual needs and preferences of human users. To achieve this, these systems rely on user models derived from user profiles and observations of human actions. However, adapting to changing contexts or individuals presents numerous challenges, including multimodal data collection and interpretation, privacy concerns, and transparency issues. There is a pressing need to develop new representations of human behavior that can capture the diversity among users while safeguarding their privacy.

This post-doctoral position is centered on the development of human-centered machine learning techniques aimed at personalized adaptation in interactive applications, with an emphasis on human-robot interaction. Recent strides in artificial intelligence, especially in the domain of deep learning, have unlocked advanced methodologies for user profiling and adaptation. Notably, representation learning (deep learning) and reasoning (Large Language Models, LLMs) have emerged as influential approaches, offering promising avenues for comprehending user behavior and providing tailored experiences in interactive applications. Rooted in a human-centered approach, the position will address ethical issues inherent in both the modeling process (e.g., biases, privacy concerns) and experimental design (e.g., working with vulnerable participants).

This position is for 24 months contract, but there is a possibility to be extended depending on the performance and circumstances.

Responsibilities:

- Develop advanced user modeling techniques to accurately represent user preferences, behaviors, and characteristics based on interaction data with AI systems.

- Investigate methods for integrating various types of data, including user interactions, feedback, and contextual information, to build comprehensive user profiles.

- Explore innovative approaches for dynamic user modeling that can adapt to changes in user preferences and behavior over time.

- Address privacy concerns by developing techniques for anonymizing or obfuscating sensitive user data while preserving model effectiveness.

- Collaborate with interdisciplinary teams including computer scientists, psychologists, and designers to ensure the usability and effectiveness of developed techniques.

- Publish research findings in top-tier conferences and journals in the field of Human-Machine Interaction and Machine Learning

Requirements:

The ideal candidate must have a PhD degree and a strong background in machine learning, human-machine interaction or robotics.

The successful candidate should have:

- Experience in human-machine interaction

- Good knowledge of Machine Learning Techniques

- Good knowledge of experimental design and statistics

- Excellent publication record

- Strong skills in Python

- Willing to work in multi-disciplinary and international teams

- Good communication skills

General information:

– Contract start date: from September 2024

– Contract duration: 24 months

– Level of study required: doctorate

– Salary: standard salary scale

– Host laboratory: ISIR (Institut des Systèmes Intelligents et de Robotique), Campus Pierre et Marie Curie, 4 place Jussieu, 75005 Paris.

Person to contact:

– Mohamed Chetouani

– Tel: +33 1 44 27 63 08

– Email : mohamed.chetouani@sorbonne-universite.fr

– Application: Interested candidates should submit the following by email in a single PDF file to: mohamed.chetouani[@]sorbonne-universite.fr with the subject: « Application Post-Doc Multimodal Representation » with:

- Curriculum vitae with 2 references (recommendation letters are also welcome)

- One-page summary of research background and interests

- At least three papers (either published, accepted for publication, or pre-prints) demonstrating expertise in one or more of the areas mentioned above

- Doctoral dissertation abstract and the expected date of graduation (for those who are currently pursuing a Ph.D)

Deadline for applications: 17 May 2024

Dans le cadre du concours ITRF (Ingénieurs et personnels Techniques de Recherche et de Formation) internes et externes à Sorbonne Université, un poste est à pouvoir à l’ISIR.

Fonctions : Assistant-e en gestion financière et comptable

Emploi-type : [Referens] J3E47 – Assistant-e en gestion financière et comptable

Catégorie : A

Corps : ASSISTANT INGENIEUR DE RECH.ET FORMATION

BAP : J – Gestion et pilotage

Nature : Concours externe

Mission :

Réaliser des fonctions financières au sein du service financier du service administratif de l’ISIR. L’assistant-e doit assurer la gestion financière et comptable des dépenses et/ou recettes dans le respect des techniques, des règles et des procédures applicables au domaine de la gestion financière et/ou comptable.

Activités principales :

- Assurer l’ensemble des opérations financières (achats, missions, commandes de vente, suivi des coûts de recrutement) dans le respect des règles du domaine en utilisant les systèmes d’information des tutelles (SIFAC/GESLAB/NEO/SIMBAD/CADROL…) pour plusieurs équipes de recherche et services de l’unité.

- Réaliser le suivi des crédits et conventions pour les porteurs de projets en coordination avec les autres gestionnaires financières du laboratoire pour plusieurs équipes de recherche de l’unité.

- Participer à l’établissement des états et bilans comptables et/ou financiers et les tableaux de bord nécessaires au suivi de l’activité, à partir des systèmes d’information des tutelles.

- Participer à la mise en oeuvre de la politique d’achat.

- Transmettre les informations pratiques sur les procédures administratives, financières et/ou comptables, sur l’évolution de la législation et de ses conséquences.

- Suivre l’évolution des règles, directives et procédures financières et/ou comptables.

- Classer et archiver les justificatifs des opérations financières et/ou comptables.

- Répondre aux audits des tutelles

Autres activités :

Participer à l’activité du service administratif pour assurer la continuité de service.

Conduite de projets : Non

Encadrement : Non

Lien vers la page du concours : https://recrutement.sorbonne-universite.fr/fr/personnels-biatss/concours-itrf/ouverture-des-inscriptions.html

Titre du poste : Post-doctorat en « Éthique de l’IA neuro-computationnelle »

Contexte :

Le projet européen CAVAA (https://cavaa.eu/) propose de réaliser une théorie de la conscience instanciée sous la forme d’une architecture informatique intégrée et de ses composants afin d’expliquer la conscience dans les systèmes biologiques et de l’intégrer dans les systèmes technologiques. Dans un monde régi par des états cachés, la conscience permet de traiter l’ « invisible », depuis les environnements inexplorés (passés et futurs contrefactuels) jusqu’aux interactions sociales qui dépendent des états internes des agents et des normes morales. En particulier, nous étudierons la capacité et la propension des agents dotés d’une telle architecture cognitive à raisonner, à prendre des décisions ou à revenir sur des expériences passées, à réfléchir sur ce qui était bien ou mal selon certaines normes morales, et sur les états futurs possibles qui pourraient être bien ou mal. L’ingénierie de la conscience de CAVAA s’accompagne d’un cadre éthique à l’égard des utilisateurs humains et des artefacts conscients dans le spectre plus large de l’IA digne de confiance, en tenant compte des objectifs partagés, des contrefactuels et des projections vers de nouveaux scénarios futurs, ainsi que de la prédiction de l’impact des choix. CAVAA vise à offrir une meilleure expérience à l’utilisateur grâce à sa capacité d’explication, d’adaptation et de lisibilité.

Lieu et environnement :

Le poste de post-doctorant sera situé à l’Institut des Systèmes Intelligents et de Robotique (ISIR, http://www.isir.upmc.fr), Paris, France. L’ISIR appartient à Sorbonne Université, au CNRS et à l’INSERM, et est situé dans le centre de Paris. Il n’est pas nécessaire de parler ou de comprendre le français. Ce travail se fera en étroite collaboration avec les philosophes, les ingénieurs et les neuroscientifiques computationnels du consortium CAVAA.

Missions :

Le travail post-doctoral se concentrera sur le raisonnement éthique à travers la virtualisation, la délibération et l’alignement sur les valeurs humaines. Le cadre théorique sera ancré dans l’apprentissage par renforcement probabiliste fondé sur un modèle (model-based), étendu pour inclure les valeurs homéostatiques, épistémiques et sociales, y compris les conventions sociales et les normes morales comme point de départ. Les travaux étudieront l’apprentissage par l’interaction avec l’environnement et avec d’autres agents, la prise de décision sociale, la simulation mentale et le raisonnement contrefactuel pour informer les humains des conséquences potentielles à long terme de leurs actions. Le modèle sera confronté à des données expérimentales sur la prise de décision humaine face à divers dilemmes sociaux et moraux. Le modèle sera également intégré dans l’architecture cognitive CAVAA et appliqué à des agents artificiels et à des robots dans des scénarios virtuels et réels impliquant la navigation spatiale et l’interaction sociale.

Profil recherché :

Nous recherchons des candidats très motivés ayant un solide dossier académique. Une excellente expérience est attendue à l’interface entre les neurosciences computationnelles et l’apprentissage automatique. Une expérience significative dans les architectures cognitives et la modélisation computationnelle pour les neurosciences, la psychologie, l’IA ou la robotique cognitive sera appréciée. Un intérêt marqué pour la philosophie de l’esprit et la philosophie morale est attendu. Admissibilité : Doctorat dans une discipline quantitative. Il n’y a pas de critère de nationalité ou d’âge.

Compétences requises :

La maîtrise de l’apprentissage par renforcement et de la théorie des jeux, un très bon niveau en mathématiques appliquées et des compétences de programmation avancées en C++ moderne et en python sont nécessaires.

Très bon niveau d’anglais (écrit et oral).

Informations générales :

– Type de poste : Post–Doc

– Date de début de contrat : 01/08/2024

– Durée du contrat : 26 mois (jusqu’au 30/09/2026)

– Quotité de travail : 100%

– Expérience souhaitée : Débutant à 4 ans

– Niveau d’études souhaité : Doctorat

– Laboratoire d’accueil : ISIR (Institut des Systèmes Intelligents et de Robotique), Campus Pierre et Marie Curie, 4 place Jussieu, 75005 Paris.

Personne à contacter :

– Mehdi Khamassi

– Tel:+33650764492

– Email : mehdi.khamassi@sorbonne-universite.fr

– Envoyer votre candidature par mail, avec [CAVAA post-doc application] en objet, un CV, une lettre de motivation (max 2 pages) et une liste de deux références.

– Date limite de dépôt de la candidature : 07/05/2024

Post-doctorat « Simuler le toucher social à distance via le son »

Contexte : Audio-touch : Simuler le toucher social à distance par le son

Le poste s’inscrit dans le cadre d’un projet financé par l’Agence Nationale de la Recherche (Modulation Multisensorielle et Affective du Toucher : Interaction et Intentionnalité). Ce projet rassemble un consortium de trois laboratoires de recherche, CNRS-LISN (O. Grynszpan, F. Bimbard, E. Prigent), UTC-Heudiasyc (I. Thouvenin) et SU-ISIR (M. Auvray & C. Pelachaud). L’objectif du consortium est de simuler la sensation d’être touché lors d’une interaction sociale dans des environnements virtuels. Ceci inclut l’étude des multiples dimensions impliquées dans le toucher social (i.e., sensations physiques, contenu émotionnel, et sens de l’action), la sonification du toucher social, la conception d’agents virtuels dotés de la capacité de produire du toucher social.

Dans le cadre de ce consortium, l’objectif de la recherche qui sera menée à l’ISIR est de s’appuyer sur la recherche de pointe sur le toucher social et la sonification des mouvements pour étudier empiriquement la conversion en sons des interactions sociales tactiles et des émotions correspondantes. En particulier, des études récentes menées à l’ISIR ont montré que les participants qui écoutent des sons enregistrés avec notre technique de sonification sont capables de catégoriser correctement les gestes tactiles (par exemple, caresser, tapoter) et que leurs évaluations de valence sont cohérentes avec les émotions sous-jacentes (par exemple, la colère, la joie, l’amour). De nombreuses questions scientifiques découlent de ces résultats, notamment les multiples dimensions du toucher social qui peuvent être sonifiées, les facteurs multisensoriels et contextuels qui augmentent la sensation d’être touché, les réponses perceptives et physiologiques des participants qui écoutent ces stimuli audio-tactiles. Toutes ces questions constitueront des avancées vers l’objectif de donner un accès à distance à des interactions sociales tactiles significatives.

Missions :

Le travail consistera à concevoir et à mener des expériences en laboratoire, à analyser les résultats et à contribuer à la rédaction des publications correspondantes.

Profil recherché :

Doctorat en sciences cognitives, en psychologie cognitive ou en sciences du comportement.

Compétences requises :

Une bonne connaissance et une bonne pratique des méthodes de psychologie expérimentale sont essentielles. Le candidat doit démontrer sa capacité à travailler au sein d’une équipe et de manière indépendante. Compte tenu de l’ampleur du projet, le candidat doit être en mesure d’assumer une responsabilité importante dans la réalisation de tous les aspects du projet de recherche, y compris la collecte de données, les statistiques, la programmation de base et la rédaction de publications.

Information générale :

– Date de début de contrat : 01/09/2024

– Durée du contrat : 2 ans

– Quotité de travail : 100%

– Expérience souhaitée : 1 à 10 ans

– Niveau d’études souhaité : Doctorat

– Laboratoire d’accueil : ISIR (Institut des Systèmes Intelligents et de Robotique), Campus Pierre et Marie Curie, 4 place Jussieu, 75005 Paris.

Personnes à contacter :

– Malika Auvray ; auvray(at)isir.upmc.fr

– Envoyer votre candidature par mail, avec [nom de l’offre] en objet, un CV et une lettre de motivation + contact de 2 référents.

– Date limite de dépôt de la candidature : 15 mai 2024

Post-doc : Développement d’un modèle numérique patient-spécifique pour la simulation chirurgicale de la valve mitrale

Contexte :

Le travail de post-doc s’inscrit dans le cadre d’un projet RHU-ICELAND qui regroupe plusieurs partenaires académiques, hospitaliers et un industriel. L’objectif du projet est de développer une nouvelle solution d’annuloplastie de la valve mitrale par voie transfémorale intégrant une échographie intra-cardiaque. Une telle solution peut être réalisée à cœur battant, sans circulation extracorporelle, fournissant ainsi, en première phase, une solution de réparation de la valve mitrale pour les patients considérés à haut risque qui ne sont pas éligibles à la chirurgie ouverte, et plus loin pour la plupart des patients nécessitant une réparation de la valve mitrale.

L’annuloplastie directe consiste à fixer un anneau ou une bande directement sur l’anneau mitral à l’aide d’ancres sous guidage direct échocardiographique et fluoroscopique. L’avantage de cette technique est qu’elle influence la forme de l’anneau mitral, reproduisant ainsi au plus près l’annuloplastie mitrale chirurgicale. Le projet porte sur deux phases essentielles : le développement d’un modèle numérique de l’anatomie et du système robotique permettant la dépose des agrafes sur la valve mitrale, et ensuite la conception et la validation du système robotique validé au préalable en numérique.

Objectifs techniques et scientifiques :

Le ou la post-doc recruté.e se penchera sur la modélisation numérique, dans un premier temps de la partie anatomique. L’objectif est de partir d’un modèle numérique open-source sur lequel il ou elle viendra rajouter des fonctionnalités pour s’approcher au mieux du modèle visé. Une fois le modèle anatomique est jugé satisfaisant, le ou la post-doc s’intéressera à la partie modèle numérique du robot endoscopique flexible (convoyeur) en partant d’un modèle numérique d’un robot existant développé pour la chirurgie obstétricienne. Le ou la post-doc aura le choix de mener les deux tâches en parallèle si c’est son souhait.

Validation expérimentale et gestion de projet :

Collaborer avec des équipes académiques et cliniques impliquées dans le projet pour participer à l’intégration de ses travaux dans le démonstrateur final. Le ou la post-doc bénéficiera d’un environnement de recherche stimulant et d’un accès à des données cliniques des partenaires cliniques et industriels du projet.

Profil recherché :

– Robotique, mécatronique, simulation et modélisation numérique,

– Compétences avancées en programmation (C++, Matlab, Python),

– Une maîtrise d’une librairie de simulation numérique de robots souples (e.g., SOFA) sera un plus,

– Enthousiasme pour la recherche interdisciplinaire et esprit de collaboration.

Structure d’accueil :

Le ou la candidat.e. recruté.e intégrera l’Institut des Systèmes Intelligents et de Robotique L’ISIR est sous la double tutelle de Sorbonne Université qui est une Université pluridisciplinaire d’envergure mondiale et du Centre National de la Recherche Scientifique (CNRS) qui est une institution de recherche parmi les plus importantes au monde. L’Institut national de la santé et de la recherche médicale (Inserm) est également tutelle de l’équipe AGATHE pour ses recherches médicales dans laquelle, le ou la post-doc recruté.e sera intégré.e.

L’ISIR organisé en plusieurs équipées pluridisciplinaires dont AGATHE. Parmi les activités de recherche abordées par les chercheuses et les chercheurs, la microrobotique, les drones, la robotique chirurgicale, les prothèses bioniques, les robots sociaux, et toutes sortes de systèmes intelligents et interactifs, physiques, virtuels ou de réalité mixte, l’intelligence artificielle, … Leurs applications adressent des enjeux sociétaux majeurs : santé, industrie du futur, transports, et service à la personne.

Information générale :

– Date de début de contrat : dès que possible

– Durée du contrat : 12 mois renouvelable pour 12 mois

– Quotité de travail : 100%

– Expérience souhaitée : Débutant à 4 ans

– Niveau d’études souhaité : Doctorat

– Laboratoire d’accueil : ISIR (Institut des Systèmes Intelligents et de Robotique), Campus Pierre et Marie Curie, 4 place Jussieu, 75005 Paris.

Personnes à contacter :

Jérôme Szewczyk (PU-Sorbonne Université) et Brahim Tamadazte (DR-CNRS)

Envoyer, un seul fichier pdf, un CV, une lettre de motivation et les articles scientifiques que vous jugez utiles au dossier à sz(at)isir.upmc.fr et brahim.tamadazte(at)cnrs.fr

Intitulé du poste : Post-doc « Haptique et interactions humain-machine multisensorielles »

Contexte :

Ce post-doc s’inscrit dans le cadre du projet ANR NeuroHCI. L’objectif global de NeuroHCI est d’améliorer la prise de décision humaine dans les mondes physique et numérique dans des contextes en interaction. Il existe différents scénarios dans lesquels un humain prend une décision avec un système interactif. La décision peut concerner un choix complexe du monde réel assisté par un ordinateur (par exemple, un traitement médical), le choix d’une méthode pour réaliser une tâche numérique (par exemple, retoucher une photo avec l’outil préféré), ou la manière dont nous décidons de la meilleure façon. pour effectuer une interaction haptique.

Missions :

L’approche scientifique envisagée reposera sur l’optimisation du retour haptique fourni à l’utilisateur en ce qui concerne la vision et l’audition en tirant parti de modèles informatiques d’intégration multisensorielle. Ainsi, les activités scientifiques du projet s’articuleront autour des questions suivantes:

– Comment s’assurer que les incohérences entre ce que l’utilisateur voit et ce qu’il ressent ne brisent pas l’illusion et comment atténuer leurs effets sur l’expérience utilisateur ?

– Comment les incohérences visuo-haptiques influencent les stratégies des utilisateurs (par exemple, avec quels objets ils décideront d’interagir) et la prise de décision de haut niveau

Profil recherché :

Le candidat idéal doit être titulaire d’un doctorat et d’une solide expérience en interaction homme-machine et/ou en sciences cognitives.

Compétences requises :

– Expérience en haptique désirée ;

– Solides compétences en Python, Matlab ou équivalent ;

– Bonne connaissance de la conception expérimentale, de la psychophysique et des statistiques ;

– Excellent dossier de publication ;

– Volonté de travailler dans une équipe multidisciplinaire ;

– Bonnes compétences en communication;

Information générale :

– Date de début de contrat : au plus tard le 01/06/2024

– Durée du contrat : 24 mois

– Quotité de travail : 100%

– Expérience souhaitée : Débutant à 4 ans

– Niveau d’études souhaité : Doctorat

– Laboratoire d’accueil : ISIR (Institut des Systèmes Intelligents et de Robotique), Campus Pierre et Marie Curie, 4 place Jussieu, 75005 Paris.

Personne à contacter :

– David Gueorguiev ; david.gueorguiev(at)sorbonne-universite.fr

– Envoyer votre candidature par mail, avec [nom de l’offre] en objet, un CV et une lettre de motivation.

Post-doc : « Apprentissage en robotique, avec application à la saisie d’objets »

Contexte :

Dans le cadre du projet FET Proactive DREAM (http://dream.isir.upmc.fr/), une approche de la robotique adaptative basée sur l’apprentissage ouvert a été définie. L’objectif principal est de permettre à un robot d’apprendre sans nécessiter une préparation minutieuse par un expert. Cette approche soulève de nombreux défis, notamment l’apprentissage avec des récompenses rares, l’apprentissage de représentations (pour les états et les actions), l’apprentissage et l’exploitation de modèles, le transfert d’apprentissage, le méta apprentissage et la généralisation. Ces sujets sont considérés en simulation, mais aussi sur des plateformes robotiques réelles, notamment dans le contexte de la saisie d’objets.

Missions :

Ce poste vise à contribuer à ces sujets dans le cadre de plusieurs projets européens, en particulier SoftManBot, Corsmal, INDEX et Learn2Grasp. S’appuyant sur les travaux antérieurs de l’équipe de recherche, les approches proposées devront être facilement adaptables à différentes plateformes robotiques et seront donc appliquées à différents robots (bras Panda de Franka-Emika, Baxter, PR2 ou TIAGO, par exemple).

Profil recherché :

Les candidats à ce poste doivent être titulaires d’un doctorat en apprentissage machine ou dans un domaine connexe dans lequel des applications robotiques (simulées ou réelles) ont été considérées.

Compétences requises :

Une excellente formation est attendue en apprentissage machine ainsi qu’une expérience en robotique. D’excellentes compétences en programmation en Python sont attendues.

Plus d’informations :

- Type de poste : Chercheuse / Chercheur post-doctoral

- Durée du contrat : 24 mois

- Niveau d’études souhaité : Doctorat

- Montant rémunération : Rémunération en fonction de l’expérience

- Laboratoire d’accueil : ISIR (Institut des Systèmes Intelligents et de Robotique), Campus Pierre et Marie Curie, 4 place Jussieu, 75005 Paris.

Personne à contacter :

- Stéphane Doncieux

- stephane.doncieux(at)sorbonne-universite.fr

- Envoyer votre candidature par mail, avec [nom de l’offre] en objet, un CV et une lettre de motivation.

Offres de doctorat, postdoctorat ou d’ingénieur·e de recherche pour le groupe HCI Sorbonne (Human Computer Interaction)

Contexte :

Nous avons plusieurs postes pour un postdoctorat ou en tant qu’ingénieur·e de recherche dans le groupe HCI Sorbonne (https://hci.isir.upmc.fr) à Sorbonne Université, Paris, France.

Missions :

Nous cherchons des personnes curieuses qui souhaitent réaliser des projets de recherche à l’intersection de l’IHM et neuroscience avec (au choix) la RV, l’haptique, la robotique ou l’IA. Des sujets possibles sont :

- Nouvelles techniques d’interaction en RV,

- RV et Haptique pour le jeux et/ou l’apprentissage,

- Modèles computationnels pour l’apprentissage, la prise de décision et la performance humaine,

- Systèmes de recommandation s’appuyant sur l’IA.

Exemples de travaux récents dans ces domaines :

- CoVR (UIST21): https://dl.acm.org/doi/10.1145/3379337.3415891

- AI-based Recommendation systems (CSCW 21): https://dl.acm.org/doi/abs/10.1145/3476068?sid=SCITRUS

- Adapting UIs with Reinforcement Learning (CHI 21): https://dl.acm.org/doi/abs/10.1145/3411764.3445497

- Mixed Control of Robotic systems (CHI 20): https://dl.acm.org/doi/10.1145/3313831.3376795

Profil recherché :

Pour un post-doctorat, un doctorat en IHM ou un domaine en lien avec l’IHM est nécessaire.

Compétences requises :

- Compétences solides en programmation et analyse strong programming and analytical skills,

- Solide expérience dans au moins un de ces domaines : IHM, RV, Haptique, Robotique, IA.

Plus d’informations :

- Type de poste : Postdoctorat ou Ingénieure de Recherche

- Date de début de contrat : dès que possible

- Durée du contrat : 1 à 2ans

- Niveau d’études souhaité : Master 2 (pour ingénieur), doctorat (pour post-doc)

- Laboratoire d’accueil : ISIR (Institut des Systèmes Intelligents et de Robotique), Campus Pierre et Marie Curie, 4 place Jussieu, 75005 Paris.

Personnes à contacter :

- Gilles Bailly et Sinan Haliyo

- Email : gilles.bailly(at)sorbonne-universite.fr ; sinan.haliyo(at)sorbonne-universite.fr

- Candidature : Envoyer votre candidature par mail, avec un CV et une lettre de motivation.

- Date limite de dépôt de la candidature : Aucune

Offres de thèse

Thesis title: “Foundation Models for Physics-Aware Deep Learning”

Context:

Physics-aware deep learning is an emerging research field aiming at investigating the potential of AI methods to advance scientific research for the modeling of complex natural phenomena. This is a fast-growing research topic with the potential to boost scientific progress and to change the way we develop research in a whole range of scientific domains. An area where this idea raises high hopes is the modeling of complex dynamics characterizing natural phenomena occurring in domains as diverse as climate science, earth science, biology, fluid dynamics. A diversity of approaches is being developed including data-driven techniques, methods that leverage first principles (physics) prior knowledge coupled with machine learning, neural solvers that directly solve differential equations. Despite significant advances, this remains an emerging topic that raises several open problems in machine learning and application domains. Among all the exploratory research directions, the idea of developing foundation models for learning from multiple physics is emerging as one of the fundamental challenges in this field. This PhD proposal is aimed at exploring different aspects of this new challenging topic.

Research Directions:

Foundation models have become prominent in domains like natural language processing (GPT, Llama, Mistral, etc) or vision (CLIP, DALL-E, Flamingo, etc). Trained with large quantities of data using self-supervision, they may be used or adapted for downstream tasks through pre-training from large amounts of training data. Initial attempts at replicating this framework in scientific domains is currently being investigated in fields as diverse as protein (Jumper et al. 2021), molecule (Zhou 2023), weather forecasting (Pathak 2022, Nguyen 2023, Kochkov 2024). Is the paradigm of foundation models adaptable to more general physics modeling such as the complex behavior of dynamical systems? Large initiatives are emerging on this fundamental topic (https://iaifi.org/generative-ai-workshop). Some preliminary attempts are currently being developed (McCabe 2023, Subramanian 2023, Hao 2024). They suggest that learning from multiple steady-state or time dependent partial differential equations (PDEs) could enhance the prediction performance on individual equations. This high stake, high gain setting might be the next big move in the domain of data-driven PDE modeling. The objective of the PhD is to explore different directions pertaining to the topic of foundation models for physics, focused on the modeling of dynamical systems.

– Solving parametric PDEs:

A first step is to consider solving parametric partial differential equations (PDEs), i.e. PDEs from one family with varying parameters including initial and boundary conditions, forcing functions, or coefficients. It is possible that different parameters values, give rise to very different dynamics. Current neural solvers operate either on fixed conditions or on a small range of parameters with training performed on a sample of the parameters. A first direction will be to analyze the potential of representative NN solvers to interpolate and extrapolate out of distribution to a large range of conditions when learning parametric solutions. A key issue is then the development of training techniques allowing for fast adaptation on new dynamics. We will investigate methods inspired from meta-learning for adaptive strategies (Yin 2021, Kirchmeyer 2022).

– Tackling multiple physics:

The foundation approach is particularly interesting in the case of scarce data, provided physics primitive could be learned from related but different PDE dynamics that are available in large quantities and then transferred to the case of interest. Learning from multiple PDEs raises algorithmic challenges since they operate on domains with different space and time resolutions, shapes and number of channels. We will consider an Encode-Process-Decode framework so that the commonalities between the dynamics are encoded and modeled in a shared latent space and the encoding-decoding process allows to project from and to the observation space for each PDE. As for the temporal variability of the observations, one will consider models that can operate on irregular series in the spirit of (Yin2023). This framework will be evaluated with selected backbones.

– Generalization and few shot capabilities:

Generalization to new dynamics is the core problem motivating the development of foundation models in science. This is a key issue for the adoption of data-driven methods in physics and more generally in any context were the data is scarce. We will consider the general framework of few shot learning aiming at fine tuning pre-trained models for downstream tasks. In this context the objective will be to develop frameworks for the fast adaptation of foundation models to target tasks. Different strategies will be analyzed and developed including parameters sampling, meta-learning for adaptation (Yin 2023) and strategies inspired from the developments in semantics and language applications like in-context learning (Chen 2024).

Position and Working Environment:

The PhD studentship is a three years position starting in October/November 2024. It does not include teaching obligation, but it is possible to engage if desired. The PhD candidate will work at Sorbonne Université (S.U.), Pierre et Marie Campus in the center of Paris. He/She will integrate while benefiting the MLIA team (Machine Learning and Deep Learning for Information Access) at ISIR (Institut des Systèmes Intelligents et de Robotique). MLIA is collaborating with fellow scientists from other disciplines such as climate or fluid mechanics. The PhD candidate will be encouraged to get involved in such collaborations.

Required Profile:

Master degree in computer science or applied mathematics, Engineering school. Background and experience in machine learning. Good technical skills in programming.

General information:

– Supervisor: Patrick Gallinari, patrick.gallinari@sorbonne-universite.fr

– Collaboration for the thesis: Cerfacs Toulouse, Institut d’Alembert, Sorbonne Université, CNAM Paris

– Host laboratory: ISIR (Institut des Systèmes Intelligents et de Robotique), Campus Pierre et Marie Curie, 4 place Jussieu, 75005 Paris.

– Start date: October/November 2024

– Note: The research topic is open and depending on the candidate profile could be oriented more on the theory or on the application side

– Keywords: deep learning, physics-aware deep learning, fluid dynamics, AI4Science

Contact person:

– Patrick Gallinari

– Email: patrick.gallinari@sorbonne-universite.fr

– Please send a cv, motivation letter, grades obtained in master, recommendation letters when possible to patrick.gallinari@sorbonne-universite.fr

– Application deadline: 15/12/2024

Subject: Physics-aware deep learning for modeling spatio-temporal dynamics

Context:

Physics-aware deep learning is an emerging research field aiming at investigating the potential of AI methods to advance scientific research for the modeling of complex natural phenomena. This research topic investigates how to leverage prior knowledge of first principles (physics) together with the ability of machine learning at extracting information from data. This is a fast-growing field with the potential to boost scientific progress and to change the way we develop research in a whole range of scientific domains. An area where this idea raises high hopes is the modeling of complex dynamics characterizing natural phenomena occurring in domains as diverse as climate science, earth science, biology, fluid dynamics, etc. This will be the focus of the PhD project.

Research Directions:

The direct application of state-of-the-art deep learning (DL) methods for modeling and solving physical dynamics occurring in nature is limited by the complexity of the underlying phenomena, the need for large amounts of data and their inability to learn physically consistent laws. This has motivated the recent exploration of physics-aware methods incorporating prior knowledge, by researchers from different communities (Willard et al. 2020, Thuerey et al. 2021). Although promising and rapidly developing, this research field faces several challenges. For this PhD project we will address two main challenges, namely the construction of hybrid models for integrating physics with DL and generalization issues which condition the usability of DL for physics.

– Integrating DL and physics for spatio-temporal dynamics forecasting and solving PDEs

In physics and many related fields, partial differential equations (PDEs) are the main tool for modeling and characterizing the dynamics underlying complex phenomena. Combining PDE models with ML is then a natural idea when building physics-aware DL models and it is one of the key challenges in the field. For now, this has been explored for two main directions: (i) augmenting low resolution solvers with ML in order to reach the accuracy of high-fidelity models at a reduced computational cost (Belbute-Perez et al. 2020, Kochkov et al. 2021, Um et al. 2020), and (ii) complementing incomplete physical models with ML by integrating observation data through machine learning (Yin et al. 2021a, Dona et al. 2022). The former topic is crucial for the entire field of numerical simulation while the latter allows for explorations beyond the current limits of numerical models. Simultaneously, the recent advances in neural operators (Li et al. 2021, Lu et al. 2021, Li et al. 2022, Yin et al. 2023) offer new methods for learning and modeling dynamics at different resolutions in space and time, providing the possibility of combining and learning multiple spatio-temporal scales within a unified formalism, a challenge in ML. A first direction of the PhD will then be to investigate physics-aware ML models by exploring the potential developments of hybrid models together with neural operators.

– Domain generalization for deep learning based dynamical models

Explicit physical models come with guarantees and can be used in any context (also called domain or environment) where the model is valid. These models reflect explicit causality relations between the different variables involved in the model. This is not the case for DL: statistical models learn correlations from sample observations, their validity is usually limited to the context of the training domain, and we have no guarantee that they extrapolate to new physical environments. This is a critical issue for the adoption of ML for modeling the physical world. Models of real-world dynamics should account for a wide range of contexts resulting from different forces, different initial and boundary conditions or different prior parameters conditioning the phenomenon. Ensuring generalization to these different contexts and environments is critical for real world applications. Surprisingly, only a few works have explored this challenging direction. In relation with the construction of hybrid models as described above, one will investigate this issue along two main directions. The first one exploits ideas from learning from multiple environments through task decomposition as in (Yin et al. 2021b, Kirchmeyer et al. 2022). This is a purely data-based approach. The second one, takes a dual perspective, relying on prior physical knowledge of the system equations and directly targets the problem of solving parametric PDEs (Huang 2022), exploiting ideas from meta-learning (Finn 2016).

Required Profile:

Master degree in computer science or applied mathematics, Engineering school. Background and experience in machine learning. Good technical skills in programming.

More information:

- Supervisor: Patrick Gallinari

- Collaboration within the framework of the thesis: INRIA team Ange, Paris; Inria team Epione, Sophia; Institut d’Alembert, Sorbonne University.

- Host laboratory: ISIR (Institut des Systèmes Intelligents et de Robotique), Campus Pierre et Marie Curie, 4 place Jussieu, 75005 Paris.

- Start date: October/November 2023

- Note: The research topic is open and depending on the candidate profile could be oriented more on the theory or on the application side

- Keywords: deep learning, physics-aware deep learning, climate data, fluid dynamics, earth science

Contact:

- Patrick Gallinari

- Email : patrick.gallinari(at)sorbonne-universite.fr

- Please send a cv, motivation letter, grades obtained in master, recommendation letters when possible to patrick.gallinari(at)sorbonne-universite.fr

- Application deadline: 15/12/2023

Offres de stage

Internship subject: Modeling the contribution of thalamo-cortical circuits to individual differences in behavioral flexibility

The ability to generate flexible behavioural responses is crucial for survival in complex and dynamic environments. Within a population, behavioural output is typically quite variable, leading to individual choices with differential adaptive values. Understanding the neural bases of these specific behavioural traits is currently a growing issue as it may be a key element to better understand the trajectories that may lead to pathological states.

While past research has largely considered the role of highly evolved brain regions such as the prefrontal cortex, the importance of subcortical regions has been increasingly recognized over the past few years. This is especially true for the mediodorsal thalamus (MD) which has extensive and multiple reciprocal connections with prefrontal areas and especially the orbitofrontal cortex (OFC), a well-known key hub for flexible behaviours, making it an important hub for executive functions. Functional dysconnectivity within thalamocortical circuits is associated with many conditions and neuropsychiatric disorders such as Schizophrenia, obsessive-compulsive disorder, ADHD or addiction. But the mechanisms by which these circuits may contribute to behavioral flexibility are still largely unknown.

In this project, we hypothesize that MD-OFC circuits may constitute a key element for understanding the neural underpinnings of variable behavioral output ranging from adaptive to maladaptive decision-making. Our preliminary dataset and model suggest that the MD->OFC functional connection is critical to support efficient flexible behaviour. We thus hypothesize that inter-individual variability in the learning strategy employed depends on the individual functional endophenotype of this pathway.

In this work, we will first model experimental data collected by our collaborators at the CNRS INCIA in Bordeaux where rats learn to choose between different levers that have different reward probabilities, different uncertainty levels, and subject to abrupt task changes. At a second stage, we will derive theoretical predictions from this modeling work in order to prepare for the new experiments that our collaborators will perform during a new ANR-funded project starting in October 2024. This ANR project also includes PhD funding at ISIR which could start in October 2025 in extension of the present internship.

The current task includes unsignalled abrupt changes to which the animal has to adapt, requiring a constant exploration-exploitation trade-off. The present version of the task is an extension of a task where we have previously shown that dopamine blockade impairs the exploration-exploitation trade-off in rats. Here we will compare an OFC-lesioned group and an MD-lesioned group with a control group, all alternatively facing difficult versus easy task conditions, where the contrast between levers’ reward probability is manipulated to make the best option more or less easy to find.

We predict that OFC lesions will impair rat performance only in the difficult condition, where subcortical structures involved in reward-based learning may be insufficient to learn the task. We will develop alternative computational models which may explain these behavior impairments through the manipulation of different model parameters. We will then simulate these models to verify that they can reproduce rat behavior, and fit them to the experimental data to find the best model. We will then evaluate whether significant model parameters change explain the data. We will finally perform model simulations in novel extensions of the task in order to derive theoretical predictions which could drive future experiments.

Job description:

– Supervisor: Mehdi Khamassi

– Starting date: 01/10/2024

– Duration: 1d/week during S1, full-time during S2 until 30/06/2025

– Level of studies required: M1/engineering

– Host laboratory: ISIR (Institut des Systèmes Intelligents et de Robotique), Campus Pierre et Marie Curie, 4 place Jussieu, 75005 Paris.

Contact person:

– Mehdi Khamassi

– Email : mehdi.khamassi@sorbonne-universite.fr

– Send your application by email, with [internship subject] in the subject line, a CV and a covering letter.

– Application deadline: 30/09/2024

Sujet du stage : Évaluation et intégration des retours causaux et contrastifs dans les algorithmes d’apprentissage par renforcement inverse

Résumé :

L’Apprentissage Machine Interactif (IML) a suscité une attention considérable ces dernières années en tant que moyen pour les agents intelligents d’apprendre à partir du feedback humain, de démonstrations ou d’instructions. Cependant, de nombreuses solutions d’IML existantes reposent principalement sur un feedback limité, ce qui impose une charge déraisonnable à l’expert impliqué. Notre projet vise à résoudre cette limitation en permettant à l’apprenant d’utiliser un feedback plus riche de l’expert, accélérant ainsi le processus d’apprentissage. De plus, nous cherchons à incorporer un modèle de l’expert pour sélectionner des requêtes plus informatives, réduisant ainsi davantage la charge sur l’expert.

Ce stage vous offre l’opportunité de participer à notre projet de recherche, où vous vous concentrerez spécifiquement sur l’évaluation d’algorithmes pour l’Apprentissage par Renforcement Inverse (IRL) et des approches connexes. L’IRL est une technique d’apprentissage par imitation axée sur l’inférence de la fonction de récompense sous-jacente aux démonstrations d’experts. Pour être plus précis, votre rôle consistera à tester des approches innovantes pour intégrer un feedback causal et contrastif tout en maintenant des hypothèses sur les objectifs potentiels de l’expert.

Objectifs du stage :

– Examiner des méthodes pour intégrer un feedback causal et contrastif dans le processus d’apprentissage par renforcement inverse ;

– Concevoir et mettre en œuvre un système basé sur les croyances qui permettra à l’apprenant de maintenir explicitement des hypothèses sur les objectifs de l’expert ;

– Utiliser le feedback reçu pour générer un postérieur qui informera les requêtes subséquentes et améliorera le processus d’apprentissage dans le cadre de l’IRL.

Profil recherché :

– Étudiant-e en Master 2 en informatique, systèmes intelligents ou domaines connexes ;

– Intérêt pour l’apprentissage par imitation, l’apprentissage par renforcement, l’apprentissage interactif robotique et la collaboration homme-machine ;

– Capacité à travailler de manière autonome et en équipe ;

– Excellentes compétences en communication écrite et orale en anglais.

Compétences requises :

– Maîtrise de la programmation Python et une certaine familiarité avec GitHub et Jupyter Notebook, ainsi que des connaissances en concepts d’apprentissage automatique et des environnements OpenAI Gym.

Informations générales :

– Encadrante : Silvia Tulli

– Date de début du stage : 1er mars 2024

– Durée du stage : 6 mois

– Niveau d’études souhaité : Master 2

– Laboratoire d’accueil : ISIR (Institut des Systèmes Intelligents et de Robotique), Campus Pierre et Marie Curie, 4 place Jussieu, 75005 Paris

Personne à contacter :

– Silvia Tulli ; tulli(at)isir.upmc.fr

– Envoyer votre candidature par mail, avec [sujet du stage] en objet, un CV et une lettre de motivation

Sujet du stage : Social Robot Navigation with Pepper Robot

Résumé :

L’interaction homme-robot est l’un des principaux piliers de la robotique qui a encore un long chemin à parcourir pour adapter les robots à nos environnements de vie quotidiens. Les robots travaillant dans des environnements peuplés d’humains devraient être capables de percevoir et de comprendre le comportement humain et d’adapter leurs mouvements pour être plus socialement conformes.

Cela signifie qu’ils doivent non seulement garantir la sécurité des personnes qui les entourent, mais également montrer des mouvements lisibles pour être plus compréhensibles par les humains. En effet, en générant des trajectoires à la fois lisibles et efficaces, nous pouvons optimiser l’efficacité du service et l’expérience client dans des espaces dynamiques et partagés. Dans le cadre du projet euROBIN, nous développons sur une pile de navigation sociale pour livrer de petits objets dans un scénario de type restaurant, à une personne spécifique, tout en agissant avec douceur et lisibilité afin que la personne cible et les autres personnes de l’environnement puissent comprendre les intentions du robot.

Cela nécessite, en dotant le robot des capteurs nécessaires pour percevoir l’environnement, de concevoir et de développer un système de perception capable de capturer les informations nécessaires sur l’environnement et les personnes qui s’y trouvent, et enfin développer des algorithmes de planification de mouvements capables de générer des mouvements “legible” pour le robot tout en s’adaptant aux changements de l’environnement.

Objectifs du stage :

L’objectif principal de ce stage est de développer une stack de navigation sociale pour le robot Pepper. Cette pile doit percevoir le comportement humain ainsi que toute autre information pertinente de la scène, prédire les mouvements et enfin générer des plans de mouvement lisibles pour le robot. Mais comme Pepper n’est pas équipé des capteurs nécessaires pour percevoir l’environnement, nous devons l’équiper de capteurs et d’unités de traitement supplémentaires. Nous souhaitons exploiter les caméras stéréo Intel RealSense et les GPU Nvidia Jetson pour améliorer les capacités de perception et de traitement du robot. Les algorithmes doivent être implémentés dans ROS (de préférence ROS2) et testés sur le robot Pepper. Mais cela peut aussi nécessiter de simuler le robot avant de tester sur le robot réel, pour lequel on peut utiliser Gazebo ou Unity. Ce stage est une belle opportunité de plonger dans l’écosystème ROS, de s’initier à la navigation sociale et également de s’initier aux dernières technologies en vision par ordinateur pour la robotique.

Le stage à l’ISIR, Sorbonne Université, comprend trois étapes principales. Dans un premier temps, ils se concentreront sur le développement de la stack ROS pour contrôler le robot Pepper, connecté aux caméras stéréo Intel RealSense et aux GPU Nvidia Jetson. La deuxième phase consiste à concevoir et mettre en œuvre le système de vision pour détecter et suivre les personnes et leur regard. La troisième étape consiste à mettre en œuvre les algorithmes de planification pour générer des mouvements legible pour le robot et à effectuer des tests limités dans un environnement contrôlé. Enfin, le stagiaire devra documenter son travail et éventuellement le présenter lors d’une conférence ou d’un atelier.

Profil recherché :

Des étudiants de Master 2 motivés avec une base académique solide en Vision par Ordinateur et Navigation Robotique, désireux de contribuer à une équipe de robotique dynamique et collaborative.

Compétences requises :

– programmation (Python / C++)

– implémenter des nœuds et des algorithmes dans ROS/ROS2

– débogage d’applications multithread

– algorithmes de planification de mouvement et d’évitement d’obstacles

– caméras de vision stéréo et de profondeur

– simulation (Gazebo, Unity, Isaac Sim, . . . )

– expérience de base avec un logiciel de conception CAO 3D (Solidworks, FreeCAD, …)

– et démontrer de solides compétences en résolution de problèmes.

Informations générales :

– Encadrants : Javad Amirian et Mouad Abrini

– Date de début du stage : le 1er Mars 2024

– Durée du stage : 5-6 mois

– Niveau d’études souhaité : Master 2

– Laboratoire d’accueil : ISIR (Institut des Systèmes Intelligents et de Robotique), Campus Pierre et Marie Curie, 4 place Jussieu, 75005 Paris.

Personne à contacter :

– Javad Amirian

– Email : amirian[at]isir.upmc.fr

– Envoyer votre candidature par mail, avec [sujet du stage] en objet, un CV et une lettre de motivation.

– Date limite de dépôt de la candidature : 31 Janvier 2024

Sujet du stage : Apprentissage de la saisie d’objets en robotique – réseau d’excellence européen

Résumé :

L’apprentissage de la saisie d’objets en robotique fait l’objet d’une attention croissante depuis plusieurs années, justifiée par les forts enjeux scientifiques et pratiques qui lui sont associés [1]. Si l’environnement est parfaitement déterministe, le problème est relativement simple : il s’agit de commander un bras manipulateur pour atteindre des positions précises, et ouvrir ou fermer le préhenseur. Mais ces approches se limitent à des scénarios très fortement contraints. Malgré les efforts de grands acteurs universitaires et industriels, réaliser de la saisie d’objet en environnement non-contrôlé est une tâche encore irrésolue, et soumise à de nombreuses difficultés [2].

D’une part, il s’agit d’un problème d’exploration difficile : il est très délicat de produire des saisies réussies avec un robot tant que l’on ne dispose pas d’un contrôleur efficace, autrement dit, tant que le problème n’est pas résolu. D’autre part, les expériences sur robots réels sont coûteuses, lentes, et sujettes à de nombreux problèmes d’intégration et de maintenance. L’apprentissage en simulation est donc préférable, mais le décalage entre simulation et réalité aboutit souvent à des problèmes de transférabilité des politiques entraînées en simulation.

Le moyen le plus commun d’aborder ce problème est de le simplifier en le considérant comme une tâche d’estimation de position de saisie sur un objet. D’abord sous la forme de prédictions de positions dans le plan, limitant la saisie à des mouvements du haut vers le bas [3], puis en ouvrant le problème à l’estimation de positions 6-DoF (position et orientation du préhenseur) [4]. Cependant, ces méthodes imposent de fortes hypothèses sur la structure du préhenseur, qui limitent ces travaux à des pinces parallèles ou à des préhenseurs pneumatiques.

Les algorithmes de qualité-diversité [5] sont des méthodes d’apprentissage évolutionnaire visant à générer des solutions performantes à un problème donné. De récents résultats de l’équipe ont montré que ces méthodes pouvaient permettre de générer de grands jeux de données de saisies diverses et robustes [6], qui peuvent être transférés sur robot réel [7] et généralisés à l’ensemble de l’espace opérationnel du robot [8].

Objectifs du stage :

EuROBin [9] est un réseau d’excellence de robotique en Europe, regroupant industriels et institutions publiques. En novembre prochain aura lieu le 2e évènement EuROBin au cours de la conférence Humanoïds à Nancy. Là-bas se déroulera une compétition coopérative, où seront valorisées les équipes qui réaliseront des tâches spécifiques avec des robots en exploitant des travaux d’autres équipes européennes.

L’objectif de ce stage est de s’appuyer sur les travaux antérieurs de l’équipe [10] pour étendre ces résultats aux robots engagés dans la compétition EuROBin. Il s’agit d’étudier les préhenseurs de chaque équipe engagé, d’adapter les résultats à ces préhenseurs, et de s’assurer que les partenaires européens puissent les exploiter sur leur robot pour améliorer leurs capacités de saisie.

Profil recherché :

Nous invitons les étudiants et étudiantes ayant un solide parcours académique en Intelligence Artificielle, Apprentissage Automatique ou en Science des données pour la Robotique à proposer leur candidature.

Formation : Actuellement en Master 2, ou de dernière année d’école d’ingénieur.

Compétences :

– Requises : Python, traitement de données, algorithmes d’apprentissages (théorie : méthodes classiques, apprentissage profond, CNN ; pratique : framework IA comme PyTorch), mesures et visualisation (matplotlib, seaborn).

– Optionnelles : Simulateurs robotiques (PyBullet, Isaac Gym …), vision par ordinateur, algorithmes évolutionnaires, parallélisation de calculs (CPU et GPU).

– Transversales : Appétence pour l’ingénierie orientée R&D, ou la recherche. Curiosité, esprit de synthèse. Initiative dans la recherche, développement de code robuste, clair et réutilisable.

Informations générales :

– Encadrant : Stéphane Doncieux

– Date de début du stage : janvier ou février 2024

– Durée du stage : 6 mois

– Niveau d’études souhaité : Actuellement en Master 2, ou de dernière année d’école d’ingénieur.

– Laboratoire d’accueil : ISIR (Institut des Systèmes Intelligents et de Robotique), Campus Pierre et Marie Curie, 4 place Jussieu, 75005 Paris.

Personnes à contacter :

– Stéphane Doncieux, Johann Huber, François Hélénon

– Email : stephane.doncieux (arobase) isir.upmc.fr ; johann.huber (arobase) isir.upmc.fr ; helenon (arobase) isir.upmc.fr

– Envoyer votre candidature par mail, avec [apprentissage_saisie_objets] en objet, un CV et une lettre de motivation. Il est fortement recommandé de joindre également un ou plusieurs projet(s) personnel(s) (github, etc…).

Sujet de stage : Contrôle de l’équilibre lors de la marche sur les mains

Contexte :

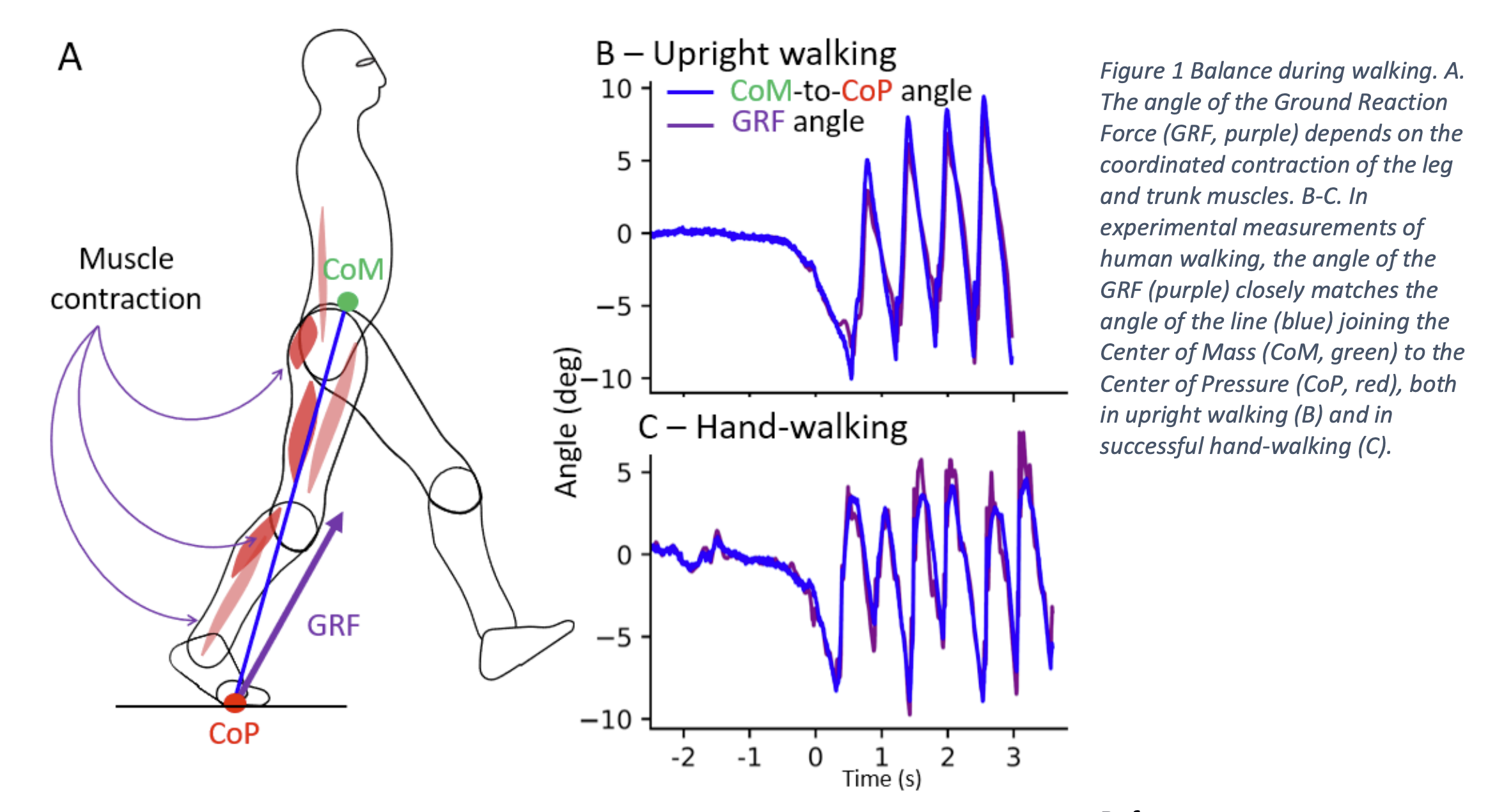

Maintenir l’équilibre lors d’un mouvement dynamique est une tâche difficile qui, chez l’homme, nécessite la contraction coordonnée de plus de 600 muscles pour ajuster les forces agissant sur le corps. Pendant la marche et la course, les muscles individuels ne se contractent pas indépendamment, mais travaillent ensemble en synergie, ce qui entraîne des performances motrices significatives : les muscles qui s’opposent ne se contractent donc pas simultanément [1]. De plus, les adultes en bonne santé maintiennent leur équilibre en minimisant la rotation autour de leur centre de masse (CoM, vert sur la figure 1.A). Ils y parviennent en orientant la force exercée par les jambes sur le sol (Ground Reaction Force – GRF, violet sur la figure 1) de telle sorte qu’elle pointe vers le CoM (Figure 1.B) [2]. Les résultats préliminaires indiquent que, lors d’une marche manuelle réussie, les sujets maintiennent également leur équilibre en orientant le GRF vers le CoM (Figure 1.C). Cela nécessite de nouvelles synergies musculaires.

Objectifs du stage :

La tâche consiste à analyser les données expérimentales de gymnastes humains marchant sur les mains. L’objectif du stage est :

1. Trouver un prédicteur biomécanique du moment où les sujets perdront l’équilibre, en comparant les succès (Figure 1.C) et essais infructueux de marche manuelle.

2. Identifier les synergies musculaires permettant aux sujets de maintenir leur équilibre lors d’essais réussis de marche manuelle.

Référence :

[1] E. Bizzi and V. C. K. Cheung, ‘The neural origin of muscle synergies’, Front Comput Neurosci, vol. 7, Apr. 2013.

[2] H. Herr and M. Popovic, ‘Angular momentum in human walking’, J Exp Biol, vol. 211, no. Pt 4, pp. 467–481, Feb. 2008, doi: 10.1242/jeb.008573.

Informations générales :

– Encadrantes : Charlotte Le Mouel, Chargée de Recherches CNRS, et Hélène Pillet, Professeur des Universités

– Date de début du stage : février – avril 2024

– Durée du stage: 3 à 6mois

– Niveau d’études souhaité : Master 2

– Laboratoire d’accueil : ISIR (Institut des Systèmes Intelligents et de Robotique), Campus Pierre et Marie Curie, 4 place Jussieu, 75005 Paris.

Personne à contacter :

– Prénom Nom : Charlotte Le Mouel et Hélène Pillet

– Email : charlotte.lemouel(at)normale.fr ; helene.pillet(at)ensam.eu

– Envoyer votre candidature par mail, avec [sujet du stage] en objet, un CV et une lettre de motivation.

– Date limite de dépôt de la candidature : 7 janvier 2024

Sujet du stage : Segmentation d’images IRM en endoscopie hépato-biliaire

Résumé :

Le projet MAAGIE vise à développer un ensemble d’outils logiciels pour l’aide à la navigation endoscopique dans les voies bilio-pancréatiques (Fig. 1). La plupart de ces outils s’appuient sur un modèle 3D de l’anatomie bilio-pancréatique du patient opéré (Fig. 2) [1]. En particulier, une thèse en cours porte sur la segmentation automatique basée deep learning (DL) d’images IRM pour la reconstruction de ces modèles 3D [2]. Une des difficultés majeures de ce travail réside dans la constitution d’une base de modèles 3D de référence pour servir de vérité terrain en phase d’entraînement des algorithmes basé DL. Actuellement, ces modèles 3D de référence sont segmentés manuellement, ce qui est très chronophage ou même parfois impossible.

Objectifs du stage :

Le but de ce stage est de mettre au point une aide informatique à la segmentation manuelle des modèles 3D pour parvenir à constituer une base de référence fiable et suffisante (on vise la cinquantaine de patients). Pour ce faire, deux approches seront explorées en parallèle :

1) On mettra au point un environnement d’aide à la segmentation manuelle proposant une prédiction de masque par croissance de région et propagation de coupe en coupe ainsi que des outils de rectification manuelle des contours du masque. On utilisera pour cela le contexte du logiciel 3D slicer notamment les modules Volume, Segmentation et Segment Editor [3];

2) On développera un algorithme de segmentation semi-automatique basé CNN en s’appuyant sur les ressources du framework MONAI [4]. L’idée ici est d’entraîner de façon interactive un modèle DL de segmentation : on entraîne d’abord le modèle avec une base de référence existante réduite et ensuite le modèle infère (approximativement) de nouveaux cas patients qui sont corrigés par un opérateur avant d’être ajoutés à la base d’apprentissage etc.

Profil recherché : M2 ou ingénieur dernière année – informatique, imagerie, IA

Compétences requises : autonomie de travail et aptitude au travail en équipe

Informations générales :

– Encadrants : J. Szewczyk (ISIR), M. Camus (Hôpital Saint-Antoine)

– Date de début du stage : février 2024

– Durée du stage : 6 mois

– Niveau d’études souhaité : Master 2 ou projet de fin d’études ingénieur-e

– Laboratoire d’accueil : ISIR (Institut des Systèmes Intelligents et de Robotique), Campus Pierre et Marie Curie, 4 place Jussieu, 75005 Paris.

Personnes à contacter :

– Jérôme Szewczyk

– Email : jerome.szewczyk(at)sorbonne-universite.fr

Envoyer votre candidature par mail, avec [sujet du stage] en objet, un CV et vos bulletins de notes de M1 et M2 si disponibles

Date limite de dépôt de la candidature : 15 décembre 2023

Sujet du stage : Actionnement électrique de la prothèse SYNSYS

Contexte :

L’Institut des Systèmes Intelligents et de Robotique (ISIR) propose un stage de M2 ou fin d’études d’école d’ingénieur passionnant et novateur, en collaboration avec l’entreprise PROTEOR, un des leaders dans le domaine des dispositifs médicaux, notamment les prothèses des membres inférieurs. Ce stage est axé sur l’amélioration de la prothèse SYNSYS de l’entreprise PROTEOR. La prothèse SYNSYS est une prothèse trans-fémorale légère munie de deux articulations, la première pour le genou et la seconde pour la cheville. Parmi les prothèses existantes, elle possède la meilleure autonomie de fonctionnement grâce à l’utilisation de l’énergie hydraulique.

Sujet du stage :

Le stage a pour objectif de contribuer à l’évolution et à l’optimisation de la prothèse SYNSYS de PROTEOR en y intégrant un étage de motorisation électrique. Le ou la candidat(e) sera impliqué(e) dans la conception, le développement et l’évaluation de cette nouvelle fonctionnalité qui vise à élargir les possibilités d’usage de la prothèse. Le travail expérimental sera central dans ce projet.

Profil recherché :

– Étudiant(e) en dernière année d’un Master 2 ou en fin d’études d’une école d’ingénieur en robotique, mécatronique, ou domaine connexe.

– Solide expérience en robotique et mécatronique, y compris la conception et le développement de systèmes mécaniques et électroniques.

– Force de proposition.

– Intérêt marqué pour la recherche expérimentale.

– Capacité à travailler de manière autonome et en équipe.

– Excellentes compétences en communication et en rédaction.

Informations générales :

– Encadrants : Waël Bachta, Enseignant-Chercheur en Robotique, et Nathanaël Jarrassé, Chercheur en Robotique

– Date de début du stage : à partir de février 2024

– Durée du stage : 5 à 6 mois

– Niveau d’études souhaité : Master 2

– Laboratoire d’accueil : ISIR (Institut des Systèmes Intelligents et de Robotique), Campus Pierre et Marie Curie, 4 place Jussieu, 75005 Paris.

Personnes à contacter :

– Waël Bachta et Nathanaël Jarrassé

– Email : bachta(at)isir.umpc.fr et jarrasse(at)isir.upmc.fr

Les candidat-e-s intéressé-e-s sont invité-e-s à envoyer leur CV, lettre de motivation et relevé de notes à : bachta(at)isir.umpc.fr et jarrasse(at)isir.upmc.fr. Veuillez inclure « Candidature Stage SYNSYS – ISIR » dans l’objet de l’e-mail. Les candidat-e-s présélectionné-e-s seront contacté-e-s pour un entretien.