Projet FHF : A Frontal Human Following technology for mobile robots

Les robots suivant les humains sont une fonction efficace et pratique, en particulier dans le contexte de la robotique de service. Cependant, la majorité des recherches existantes se sont concentrées sur le suivi derrière un humain, avec relativement peu d’attention accordée au robot opérant devant l’humain. Ce projet de suivi frontal, où le robot reste dans le champ de vision de l’utilisateur, est plus rassurant et facilite l’interaction. De nouveaux défis se présenteront lors de la mise au point d’un tracker capable d’estimer la pose d’un utilisateur à partir d’un LiDAR 2D à hauteur de genou, en particulier lorsque les jambes sont souvent masquées l’une par l’autre. Il est également nécessaire d’assurer la sécurité de l’utilisateur tout en se demandant comment le robot peut suivre l’utilisateur dans les situations où le robot serait en retard.

Le contexte

Les robots mobiles sont de plus en plus omniprésents dans divers environnements, tels que les centres commerciaux, les hôpitaux, les entrepôts et les usines. Nombre de tâches dans ces applications sont partagées entre les robots et les opérateurs humains par la voix, la vidéo, l’interaction par la force, etc., soit parce que l’expertise ou l’agilité humaine inhérente est requise pour certaines tâches, soit parce que le robot peut fournir une assistance potentielle à l’opérateur. Dans ce projet, nous nous concentrons sur l’étude du suivi automatique de l’utilisateur par le robot mobile basé sur le LiDAR 2D. Les algorithmes communs de suivi à l’arrière maintiennent le robot à une distance de l’utilisateur. Certaines études ont montré que les gens préfèrent voir les robots dans leur champ de vision, et peuvent se sentir mal à l’aise et en danger lorsque les robots apparaissent derrière eux. En outre, les services spécifiques exigent que les robots se présentent devant les utilisateurs. Par exemple, les robots d’assistance agissent comme des chiens d’aveugle pour fournir une aide à la navigation aux malvoyants. Par conséquent, le suivi frontal devient progressivement populaire.

Les objectifs

Les objectifs scientifiques de ce projet sont les suivants :

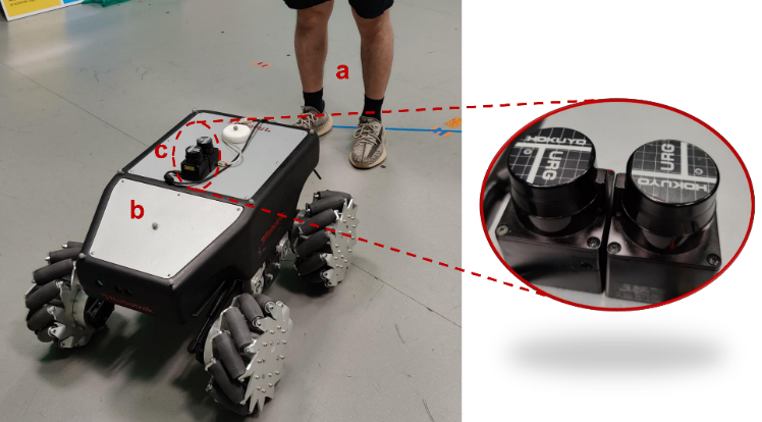

– Construire un tracker de pose humaine (orientation et position) basé sur le LiDAR 2D à hauteur du genou pour les robots mobiles en étudiant la marche humaine ;

– Collecter des scans LiDAR de différents volontaires ainsi que des données de vérité terrain sur l’orientation humaine afin de construire un modèle basé sur les données pour améliorer l’estimation de l’orientation humaine ;

– Résoudre le problème des jambes se cachant l’une et l’autre lors du balayage en modélisant la marche ou en utilisant des techniques d’apprentissage automatique ;

– Développer un générateur de mouvement permettant au robot de se déplacer devant l’utilisateur en toute sécurité et de manière naturelle.

Les résultats

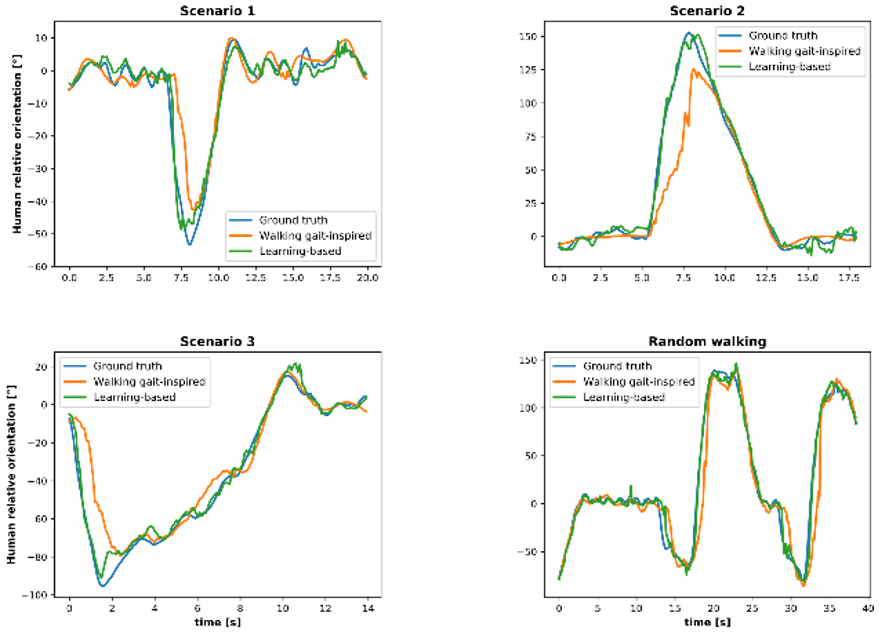

Douze volontaires (trois femmes et neuf hommes) ont été invités à participer à l’expérience de suivi frontal, et le tracker de posture humaine basé sur la marche humaine a montré de bonnes performances. Les analyses quantitatives ont révélé que l’erreur absolue moyenne (MAE) de position était d’environ 4 cm et que la MAE d’orientation était inférieure à 12 degrés pour la marche complexe.

Les données collectées pendant six heures sur cinq volontaires (une femme et quatre hommes) ont été utilisées pour construire des modèles permettant d’améliorer l’estimation de l’orientation. Grâce à la résolution du problème de retard, le modèle personnalisé a permis d’obtenir une MAE de 4 à 7 degrés pour les cinq volontaires.

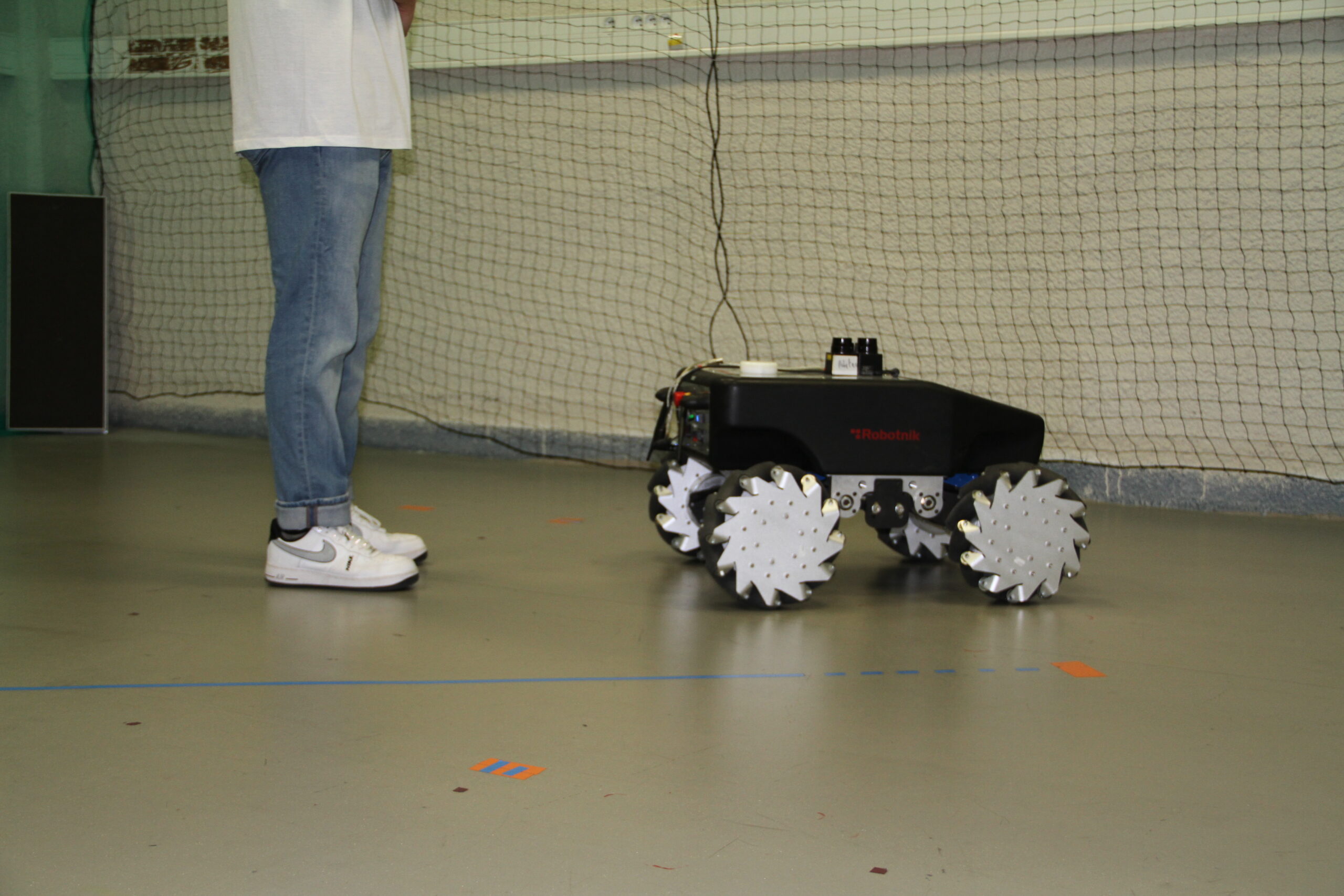

Le générateur de mouvement à suivi frontal permet au robot de venir naturellement devant l’utilisateur, toujours à une distance de sécurité d’un mètre au cours de l’expérience. Voir la vidéo pour plus de détails.

Publications

– 2D LiDAR-Based Human Pose Tracking for a Mobile Robot, ICINCO 2023,

– Human Orientation Estimation from 2D Point Clouds Using Deep Neural Networks in Robotic Following Tasks, soumis à IROS 2024,

– Large Workspace Frontal Human Following for Mobile Robots Utilizing 2D LiDAR, soumis à JIRS.