L’approche du projet Audio-touch combine les résultats de la recherche sur le toucher social et sur la sonification du mouvement, ce qui permet d’extraire certaines caractéristiques significatives des interactions tactiles et de les convertir en sons. Dans les études expérimentales du projet, les participant-es qui écoutaient les stimuli audio-touch peau à peau ont associé avec précision les sons à des gestes spécifiques et ont identifié de façon cohérente les intentions socio-émotionnelles sous-jacentes aux touchers convertis en sons.

De plus, les mêmes mouvements ont été enregistrés avec des objets inanimés, et des expériences supplémentaires ont révélé que la perception des participant-es était influencée par les surfaces impliquées dans les interactions tactiles (peau ou plastique). Cette approche audio-touch pourrait être un tremplin pour donner accès à l’expérience ineffable du toucher social à distance, avec des agents humains ou virtuels.

Le contexte

Le toucher est la première modalité sensorielle à se développer, et le toucher social a de nombreux effets bénéfiques sur le bien-être psychologique et physiologique des individus. Les situations de carences en touchers sociaux accentuent les sentiments d’isolement, d’anxiété et le besoin de lien social. Face à ce constat, il devient urgent d’explorer des moyens de recréer, à distance, les effets bénéfiques du toucher affectif.

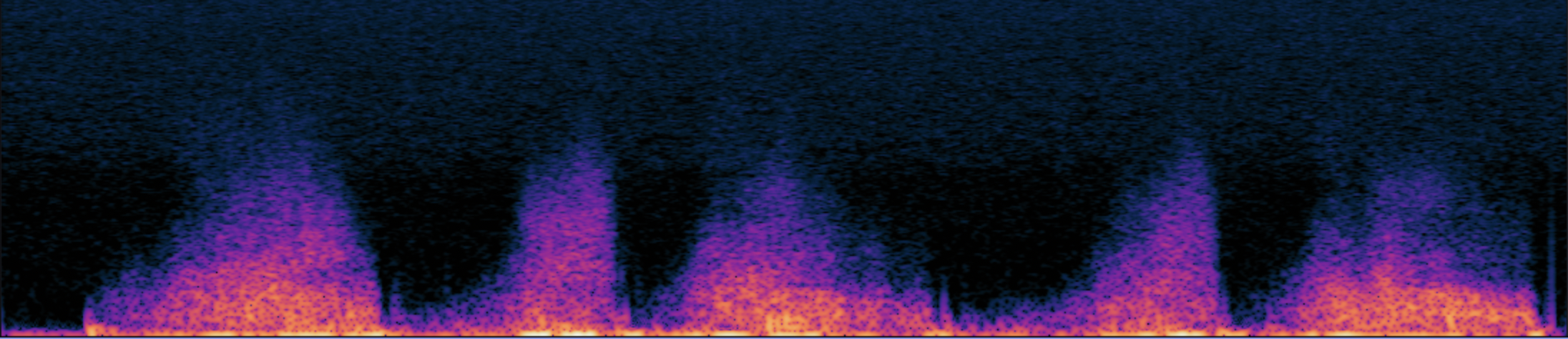

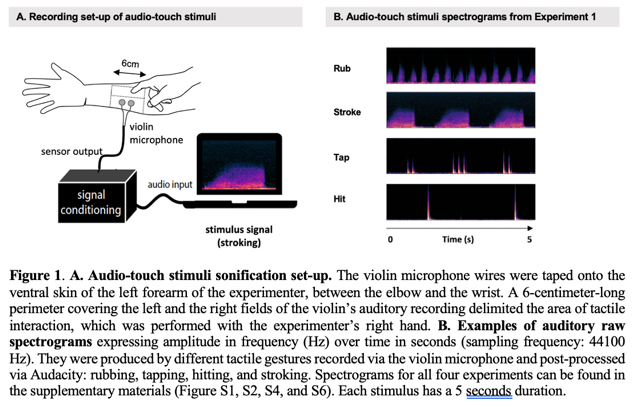

Ce projet est né de cette urgence, mais aussi d’une observation fondamentale : le toucher et l’audition partagent une base physique commune, celle des vibrations. Les études de sonification ont déjà montré qu’il était possible de traduire des mouvements et leurs propriétés en sons. Il devient alors envisageable de traduire certaines caractéristiques des interactions peau à peau en signaux auditifs perceptibles. De la convergence entre ce besoin de lien tactile à distance et les similitudes physiques entre toucher et son est né le projet Audio-touch, qui vise à transmettre les informations du toucher affectif via des sons.

Les objectifs

L’objectif principal de cette recherche est d’étudier les possibilités offertes par l’audio-touch : peut-on convertir du toucher peau à peau en sons ? Plus précisément, l’équipe a ensuite déterminé expérimentalement quelles informations du toucher social les stimuli audio-touch pouvaient communiquer aux personnes qui les écoutent : peut-on reconnaître différents types de gestes du toucher dans nos stimuli audio-touch ? peut-on reconnaître différentes intentions socio-affectives sous-jacentes à ces gestes du toucher sonifié ? la surface sur laquelle le toucher a lieu (peau versus objet inanimé) influence-t-elle ces perceptions ?

Les résultats

Les quatre expériences menées dans cette étude montrent que les gestes tactiles sociaux, leurs intentions socio-émotionnelles et la surface touchée (peau vs plastique) peuvent être reconnus uniquement à partir des sons audio-touch créés. En effet, les résultats montrent que :

– les participant-es ont correctement catégorisé les gestes (expérience 1),

– les participant-es ont identifié les émotions transmises (expérience 2),

– leur reconnaissance a été influencée selon la surface sur laquelle le toucher avait lieu (expériences 3 et 4).

Ces résultats ouvrent des perspectives à l’intersection des domaines de l’haptique et de l’acoustique, le projet Audio-touch se situant précisément à la croisée de ces deux champs, tant par sa méthodologie de captation des gestes tactiles que par son intérêt pour la perception humaine des signaux sonores issus du toucher. Ils s’inscrivent également dans les recherches en interaction humain-machine, et suggèrent que des sons issus du toucher social pourraient enrichir les expériences multisensorielles, notamment dans les interactions avec des agents sociaux virtuels.

Partenariats et collaborations

Le projet est une collaboration entre :

– Alexandra de Lagarde, doctorante de l’équipe ACIDE de l’ISIR,

– Catherine Pelachaud, directrice de recherche CNRS de l’équipe ACIDE de l’ISIR,

– Louise P. Kirsch, maîtresse de conférence INCC, à l’Université Paris Cité, et ancienne post-doctorante de l’équipe Piros à l’ISIR,

– Malika Auvray, directrice de recherche CNRS de l’équipe ACIDE de l’ISIR.

De plus, pour la partie acoustique liée au projet, l’étude a bénéficié de l’expertise de Sylvain Argentieri pour la partie enregistrements et de Mohamed Chetouani pour la partie traitement du signal.

Il s’inscrit également dans le cadre du programme ANR MATCH, qui explore la perception du toucher dans les interactions avec des agents virtuels, en partenariat avec HEUDIASYC (UTC) et le LISN (Université Paris Saclay).